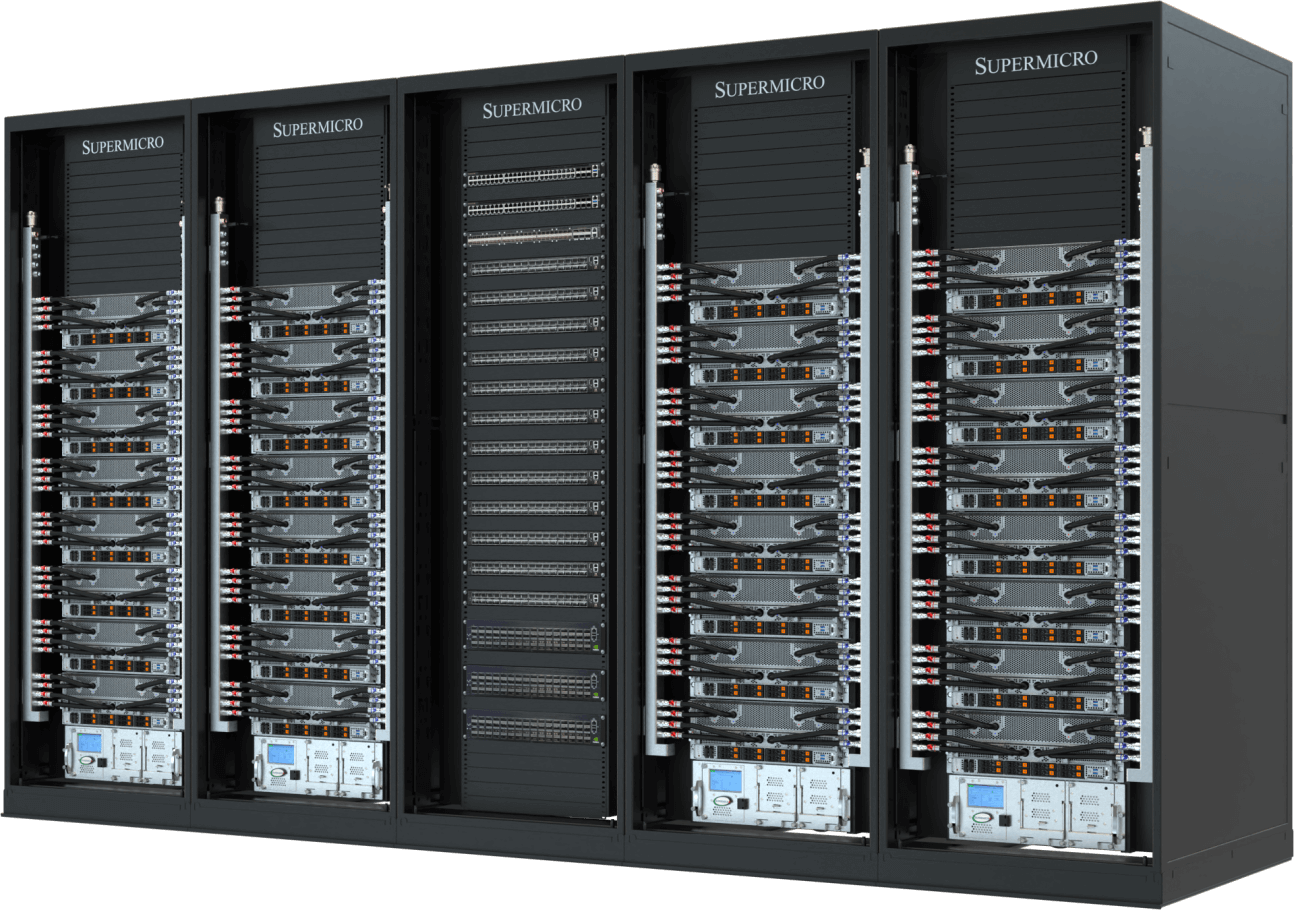

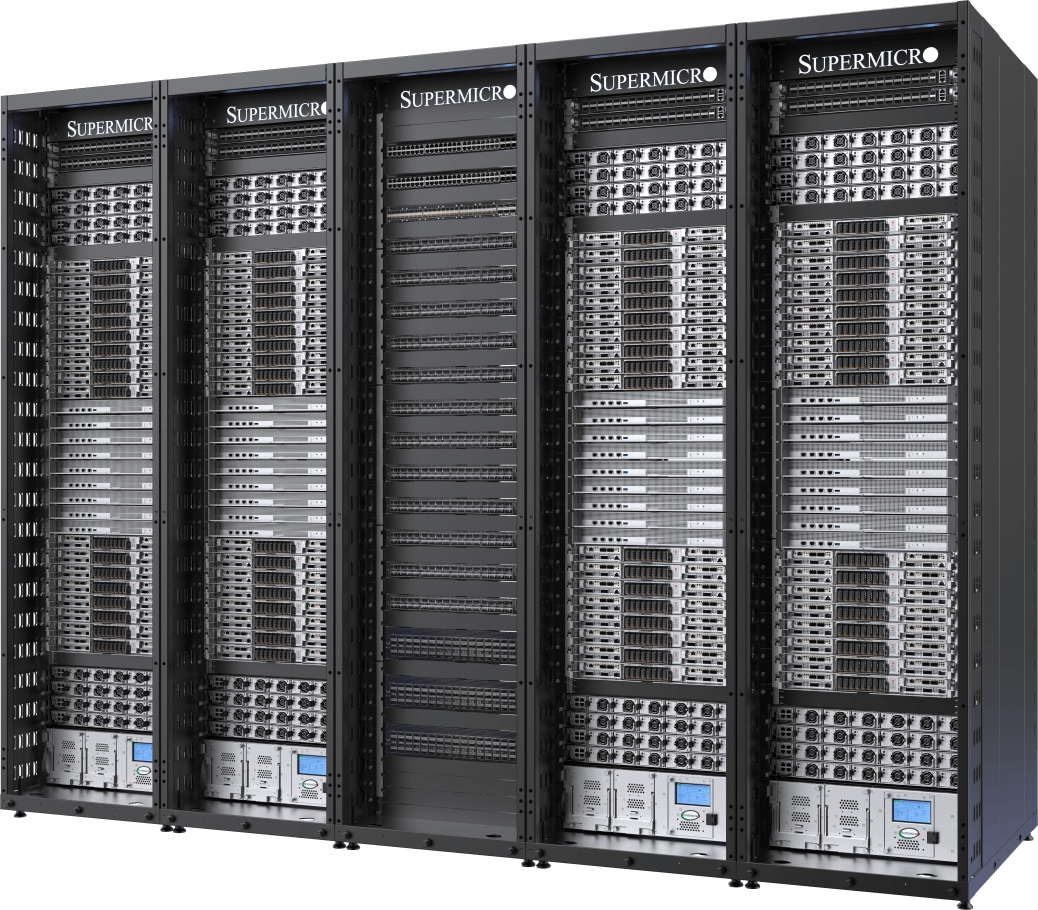

En la era de la IA, una unidad de cálculo ya no se mide sólo por el número de servidores. GPUs, CPUs, memoria, almacenamiento y estos recursos interconectados a través de múltiples nodos en racks construyen la Inteligencia Artificial actual. La infraestructura requiere tejidos de red de alta velocidad y baja latencia, y tecnologías de refrigeración y suministro de energía cuidadosamente diseñadas para mantener un rendimiento y eficiencia óptimos para cada entorno de centro de datos. La solución SuperCluster de Supermicro proporciona bloques de construcción fundacionales para la IA generativa de rápida evolución y los grandes modelos de lenguaje (LLM).

Integración completa a escala

Diseño y construcción de racks y clusters completos con una capacidad de fabricación global de hasta 5.000racks al mes

Pruebas, validación e implantación con servicio in situ

Los procesos de prueba L11 y L12 de eficacia probada validan exhaustivamente la eficacia y eficiencia operativas antes del envío.

Refrigeración líquida/enfriamiento por aire

Solución de refrigeración líquida o por aire totalmente integrada con placas frías para GPU y CPU, unidades de distribución de refrigeración y colectores

Gestión de suministros e inventarios

Un único proveedor para suministrar bastidores totalmente integrados de forma rápida y puntual con el fin de reducir el tiempo de implementación de la solución.

La solución completa de centro de datos llave en mano acelera el tiempo de entrega para casos de uso empresarial de misión crítica, y elimina la complejidad de construir un gran clúster, que anteriormente sólo era posible mediante el ajuste de diseño intensivo y la optimización que consume tiempo de la supercomputación.

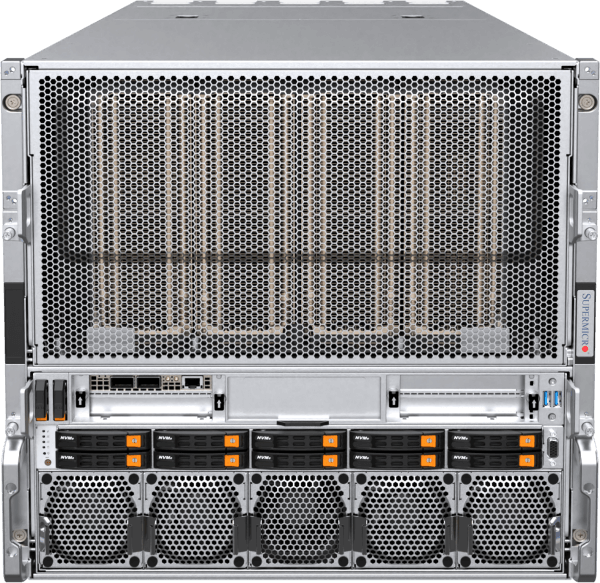

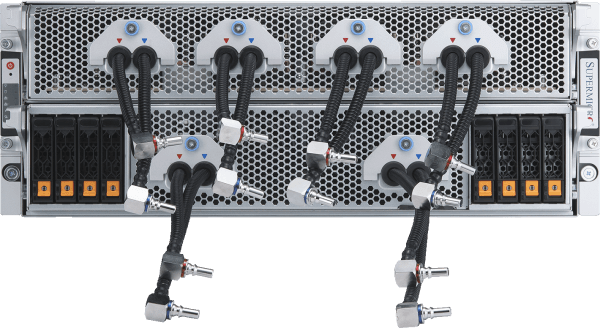

Liquid-Cooled NVIDIA HGX B200 AI Cluster

With up to 32 NVIDIA HGX B200 8-GPU, 4U Liquid-cooled Systems (256 GPUs) in 5 Racks

- Deploy the pinnacle of AI training and inference performance with 256 NVIDIA B200 GPUs in one scalable unit (5 racks)

- Supermicro Direct Liquid Cooling featuring 250kW capacity in-rack Coolant Distribution Unit (CDU) with redundant PSU and dual hot-swap pumps

- 45 TB of HBM3e memory in one scalable unit

- Scale-out with 400Gb/s NVIDIA Spectrum™-X Ethernet or NVIDIA Quantum-2 InfiniBand

- Customizable data storage fabric with industry leading parallel file system options

- Support for NVIDIA AI Enterprise Platform including NVIDIA NIM microservices

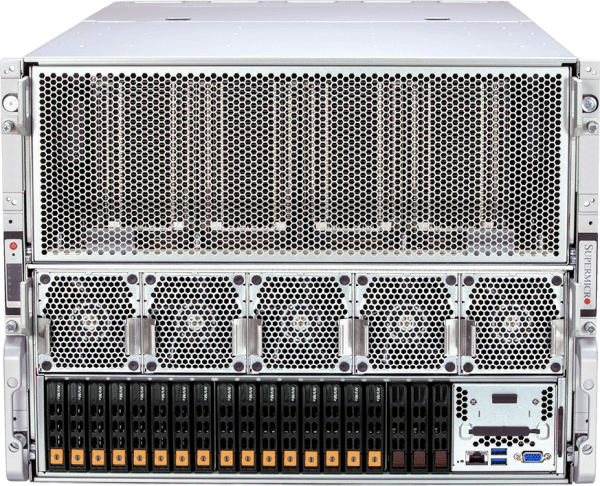

Compute Node

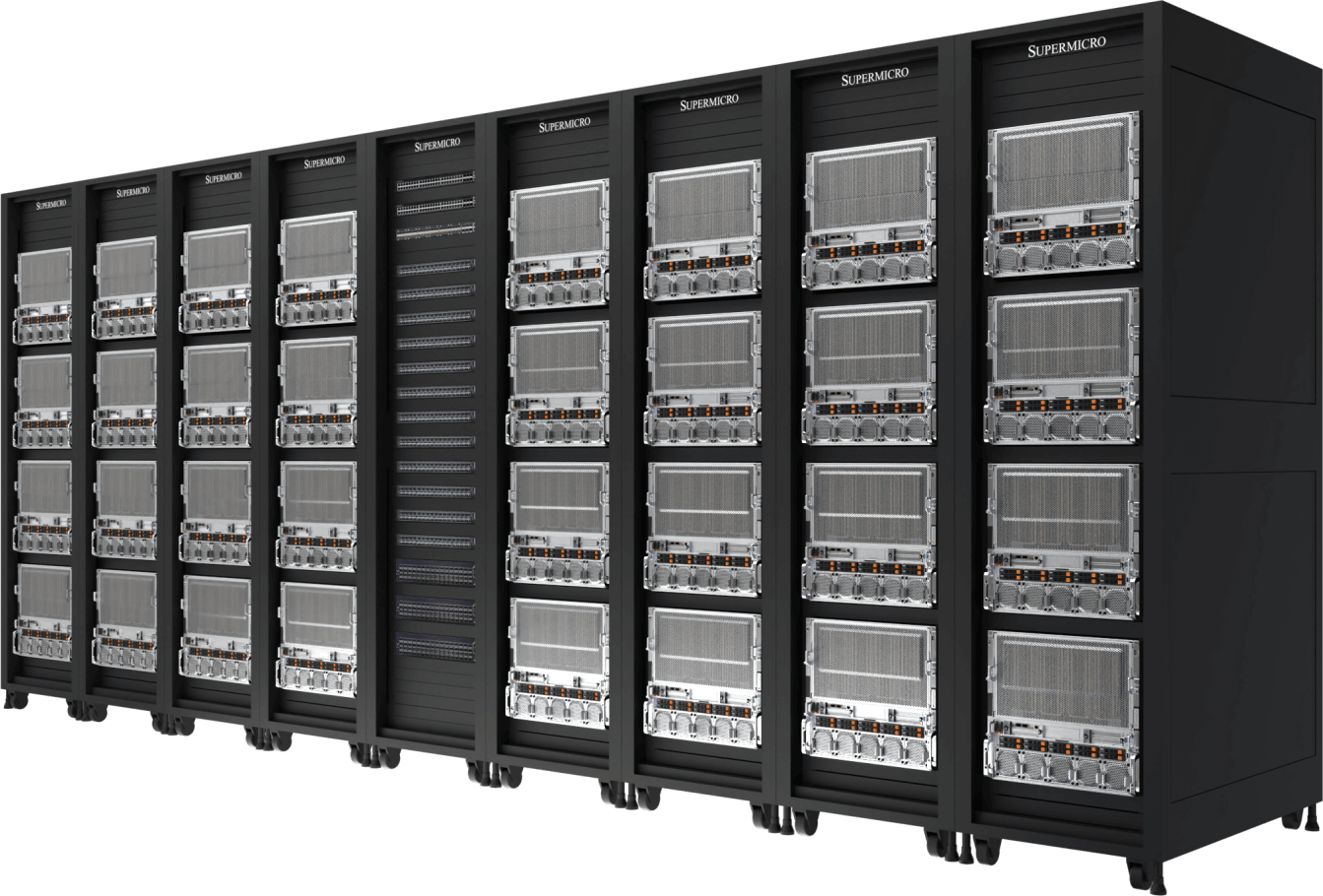

Air-Cooled NVIDIA HGX B200 AI Cluster

With 32 NVIDIA HGX B200 8-GPU, 10U Air-cooled Systems (256 GPUs) in 9 Racks

- Proven industry leading architecture with new thermally-optimized air-cooled system platform

- 45 TB of HBM3e memory in one scalable unit

- Scale-out with 400Gb/s NVIDIA Spectrum-X Ethernet or NVIDIA Quantum-2 InfiniBand

- Customizable data storage fabric with industry leading parallel file system options

- Support for NVIDIA AI Enterprise Platform including NVIDIA NIM microservices

Compute Node

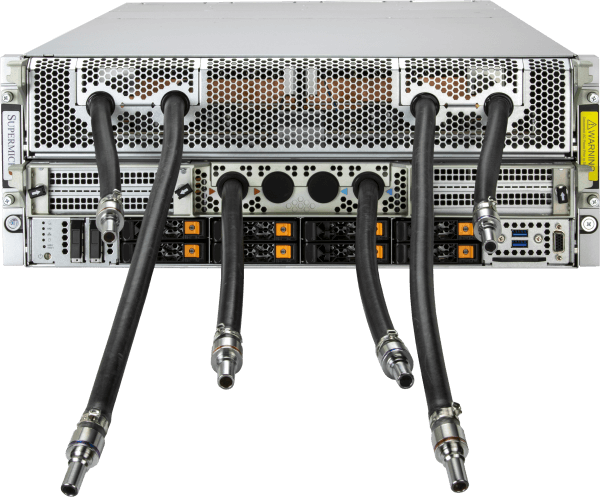

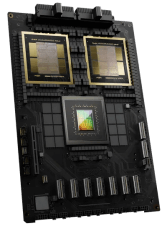

NVIDIA GB200 NVL72

Liquid-cooled Exascale Compute in a Single Rack

- 72x NVIDIA Blackwell B200 GPUs acting as one GPU with a massive pool of HBM3e memory (13.5TB per rack)

- 9x NVLink Switch, 4 ports per compute tray connecting 72 GPUs to provide 1.8TB/s GPU-to-GPU interconnect

- Supermicro Direct Liquid Cooling featuring 250kW capacity in-rack Coolant Distribution Unit (CDU) with redundant PSU and dual hot-swap pumps

- Supermicro’s end-to-end liquid-cooling solution and comprehensive onsite deployment services

- Ready for advanced networking technologies for scaling including NVIDIA BlueField®-3 SuperNIC, Spectrum-X, Quantum-2, and next generation 800 Gb/s networking platforms

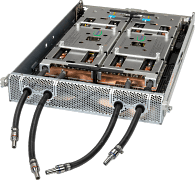

Compute Tray

- ARS-121GL-NBO-LCC

(not sold individually)

Clúster líder de IA refrigerada por líquido

Con 32 sistemas NVIDIA HGX H100/H200 de 8 GPU, 4U y refrigeración líquida (256 GPU) en 5 racks

- Duplicación de la densidad de cálculo a través de la solución de refrigeración líquida personalizada de Supermicro con una reducción de hasta el 40% en el coste de electricidad para el centro de datos.

- 256 GPU NVIDIA H100/H200 en una unidad escalable

- 20 TB de HBM3 con H100 o 36 TB de HBM3e con H200 en una unidad escalable

- Conexión en red 1:1 con cada GPU para permitir RDMA y almacenamiento NVIDIA GPUDirect para el entrenamiento de modelos de lenguaje de gran tamaño con hasta billones de parámetros.

- Tejido de almacenamiento de canalización de datos de IA personalizable con opciones de sistemas de archivos paralelos líderes del sector

- Supports NVIDIA Quantum-2 InfiniBand and Spectrum™-X Ethernet platform

- Certified for NVIDIA AI Enterprise Platform including NVIDIA NIM microservices

Nodo informático

Diseño probado

Con 32 NVIDIA HGX H100/H200 8-GPU, 8U Sistemas refrigerados por aire (256 GPUs) en 9 Racks

- Arquitectura probada líder del sector para implantaciones de infraestructuras de IA a gran escala

- 256 GPU NVIDIA H100/H200 en una unidad escalable

- 20 TB de HBM3 con H100 o 36 TB de HBM3e con H200 en una unidad escalable

- Conexión en red 1:1 con cada GPU para permitir RDMA y almacenamiento NVIDIA GPUDirect para el entrenamiento de modelos de lenguaje de gran tamaño con hasta billones de parámetros.

- Tejido de almacenamiento de canalización de datos de IA personalizable con opciones de sistemas de archivos paralelos líderes del sector

- Supports NVIDIA Quantum-2 InfiniBand and Spectrum-X Ethernet platform

- Certified for NVIDIA AI Enterprise Platform including NVIDIA NIM microservices

Nodo informático