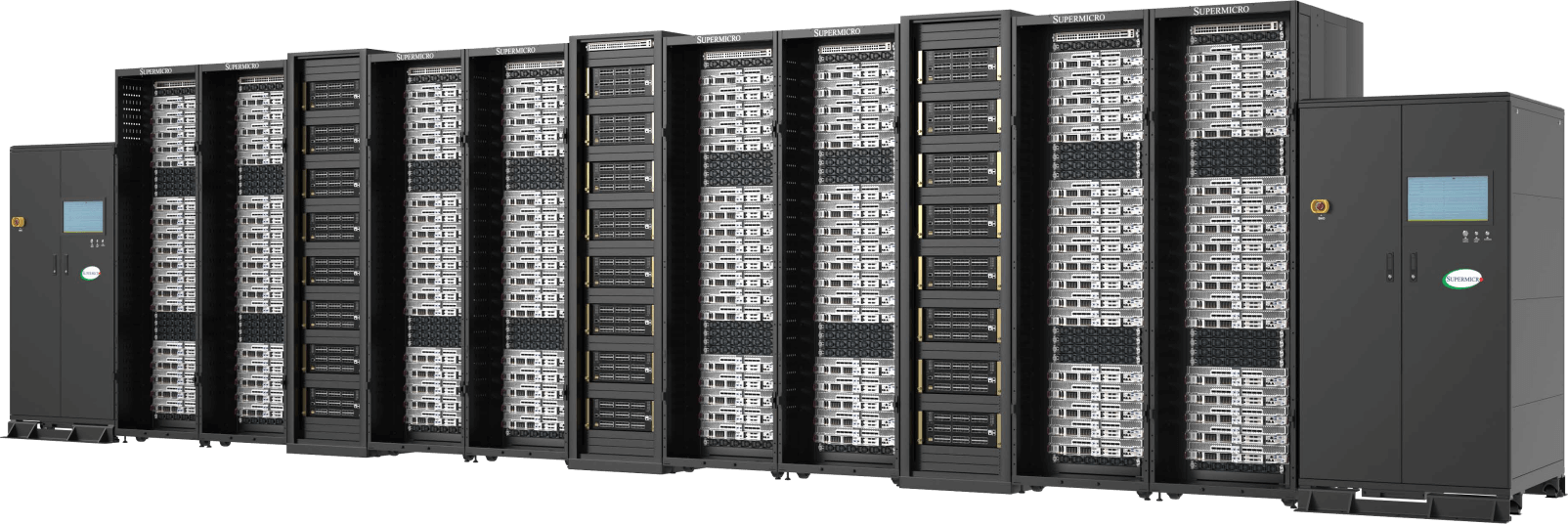

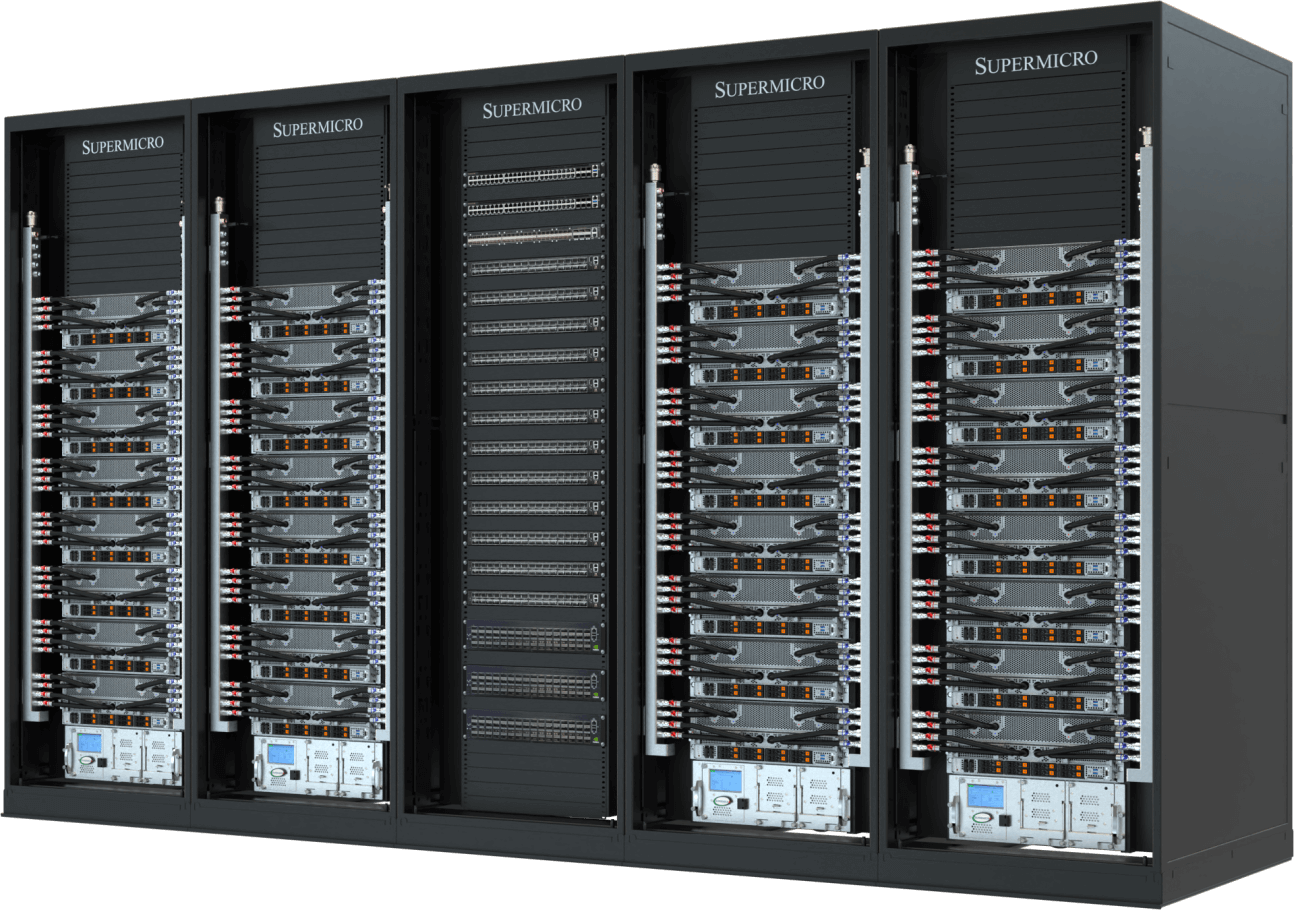

En la era de la IA, una unidad de computación ya no se mide solo por el número de servidores. Las GPU, CPU, memoria y almacenamiento interconectados, así como estos recursos repartidos en múltiples nodos en racks, conforman la inteligencia artificial actual. La infraestructura requiere estructuras de red de alta velocidad y baja latencia, así como tecnologías de refrigeración y suministro de energía cuidadosamente diseñadas para mantener un rendimiento y una eficiencia óptimos en cada entorno de centro de datos. La solución SuperCluster Supermicroofrece soluciones integrales para centros de datos de IA para la IA generativa y los modelos de lenguaje grandes (LLM), que están en rápida evolución.

Integración completa a escala

Diseño y construcción de racks completos y clusters con una capacidad de fabricación global de hasta 5,000 bastidores al mes

Probar, validar, implantar con el servicio in situ

Los probados procesos de prueba L11, L12 validan a fondo la eficacia y eficiencia operativas antes del envío

Refrigeración por líquido/refrigeración por aire

Solución de refrigeración líquida o por aire totalmente integrada con placas frías para GPU y CPU, unidades de distribución de refrigeración y colectores

Gestión de suministros e inventarios

Un único proveedor para suministrar bastidores totalmente integrados de forma rápida y puntual para reducir el tiempo hasta la solución para una rápida implantación

La solución completa de centro de datos llave en mano acelera el tiempo de entrega para casos de uso empresarial de misión crítica, y elimina la complejidad de construir un gran clúster, que anteriormente sólo era posible mediante el ajuste de diseño intensivo y la optimización que consume tiempo de la supercomputación.

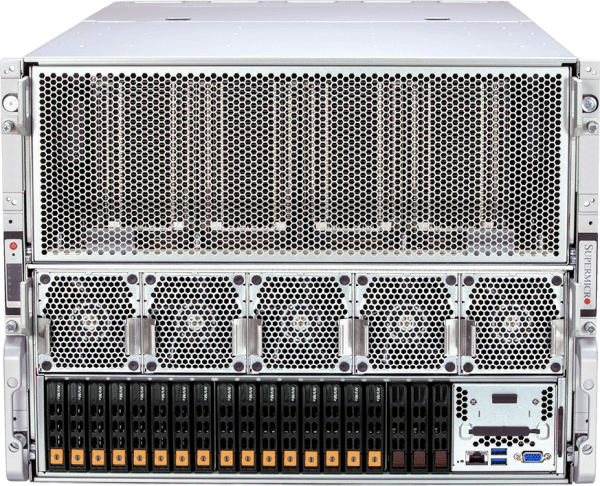

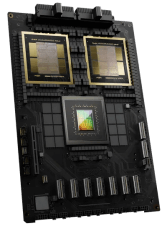

Clúster de IA NVIDIA HGX B300 de 2 OU refrigerado por líquido

Clúster de 144 nodos totalmente integrado y refrigerado por líquido con hasta 1152 GPU NVIDIA B300.

- Densidad de rendimiento de entrenamiento de IA sin igual gracias a NVIDIA HGX B300 con nodos de sistema compactos de 2 OU refrigerados por líquido.

- Refrigeración líquida Supermicro con CDU en fila con capacidad de 1,8 MW (opciones de CDU en rack disponibles)

- Gran capacidad de memoria GPU HBM3e (288 GB* de memoria HBM3e por GPU) y huella de memoria del sistema para el entrenamiento de modelos básicos.

- Amplíe su capacidad con NVIDIA Quantum-X800 InfiniBand para obtener estructuras de IA ultra y gran ancho de banda.

- Opciones de estructura de almacenamiento dedicada con compatibilidad total con NVIDIA GPUDirect RDMA y almacenamiento o RoCE.

- Diseñado para ser totalmente compatible con las plataformas de software de IA de NVIDIA, incluidas NVIDIA AI Enterprise y NVIDIA Run:ai.

Nodo informático

Clúster de IA NVIDIA HGX B300 de 4U refrigerado por líquido

Clúster de 72 nodos totalmente integrado y refrigerado por líquido con hasta 576 GPU NVIDIA B300.

- Implemente formación e inferencia de IA de alto rendimiento con NVIDIA HGX B300, optimizado para densidad de cálculo y facilidad de mantenimiento.

- Refrigeración líquida Supermicro diseñada para un funcionamiento sostenido de alta potencia y una mayor eficiencia energética.

- Gran capacidad de memoria GPU HBM3e (288 GB* de memoria HBM3e por GPU) y huella de memoria del sistema para el entrenamiento de modelos básicos.

- Amplíe con NVIDIA Spectrum™-X Ethernet o NVIDIA Quantum-X800 InfiniBand.

- Opciones de estructura de almacenamiento dedicada con compatibilidad total con NVIDIA GPUDirect RDMA y almacenamiento o RoCE.

- Diseñado para ser totalmente compatible con las plataformas de software de IA de NVIDIA, incluidas NVIDIA AI Enterprise y NVIDIA Run:ai.

Nodo informático

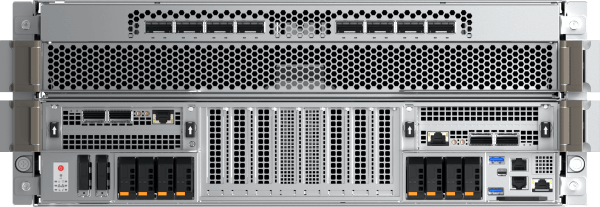

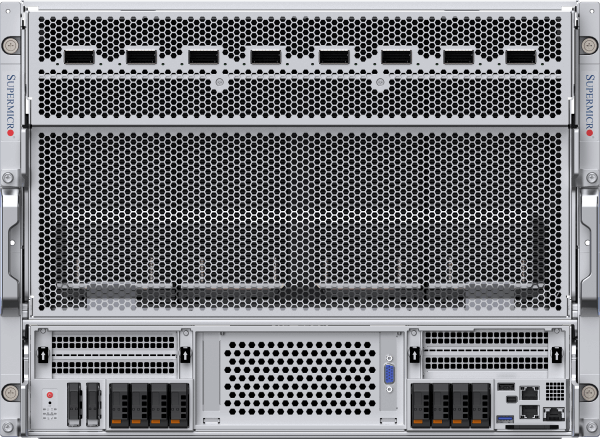

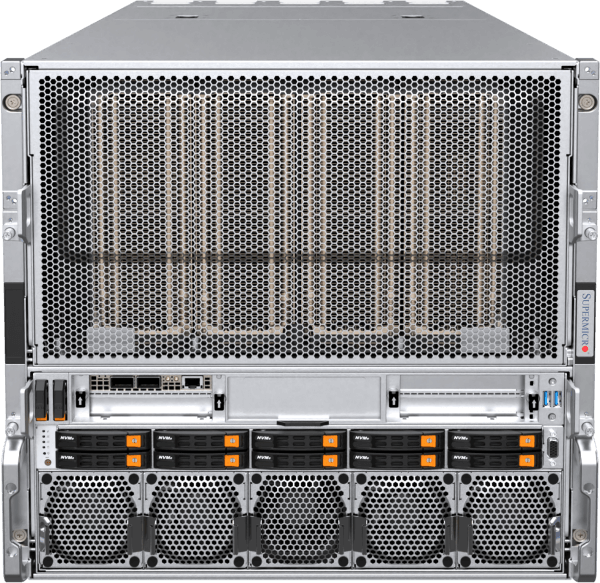

Clúster de IA NVIDIA HGX B300 de 8U refrigerado por aire

Clúster de 72 nodos totalmente integrado y refrigerado por aire con hasta 576 GPU NVIDIA B300.

- Implemente formación e inferencia de IA escalables con NVIDIA HGX B300 en un diseño refrigerado por aire para una mayor compatibilidad con los centros de datos.

- Diseño térmico y flujo de aire optimizados que permiten un funcionamiento de alto rendimiento sin necesidad de infraestructura de refrigeración líquida.

- Gran capacidad de memoria GPU HBM3e (288 GB* de memoria HBM3e por GPU) y huella de memoria del sistema para el entrenamiento de modelos básicos.

- Amplíe con NVIDIA Spectrum™-X Ethernet o NVIDIA Quantum-X800 InfiniBand.

- Opciones de estructura de almacenamiento dedicada con compatibilidad total con NVIDIA GPUDirect RDMA y almacenamiento o RoCE.

- Diseñado para ser totalmente compatible con las plataformas de software de IA de NVIDIA, incluidas NVIDIA AI Enterprise y NVIDIA Run:ai.

Nodo informático

Clúster de IA NVIDIA HGX B200 refrigerado por líquido

Con hasta 32 sistemas NVIDIA HGX B200 de 8 GPU, 4U y refrigeración líquida (256 GPU) en 5 racks

- Implemente lo último en rendimiento de entrenamiento e inferencia de IA con 256 GPU NVIDIA B200 en una unidad escalable (5 racks).

- Refrigeración líquida Supermicro con unidad de distribución de refrigerante (CDU) en rack con capacidad de 250 kW, fuente de alimentación redundante y dos bombas intercambiables en caliente.

- 45 TB de memoria HBM3e en una unidad escalable

- Escalabilidad con NVIDIA Spectrum™-X Ethernet a 400 Gb/s o NVIDIA Quantum-2 InfiniBand

- Opciones de estructura de almacenamiento dedicada con compatibilidad total con NVIDIA GPUDirect RDMA y almacenamiento o RoCE.

- Diseñado para ser totalmente compatible con las plataformas de software de IA de NVIDIA, incluidas NVIDIA AI Enterprise y NVIDIA Run:ai.

Nodo informático

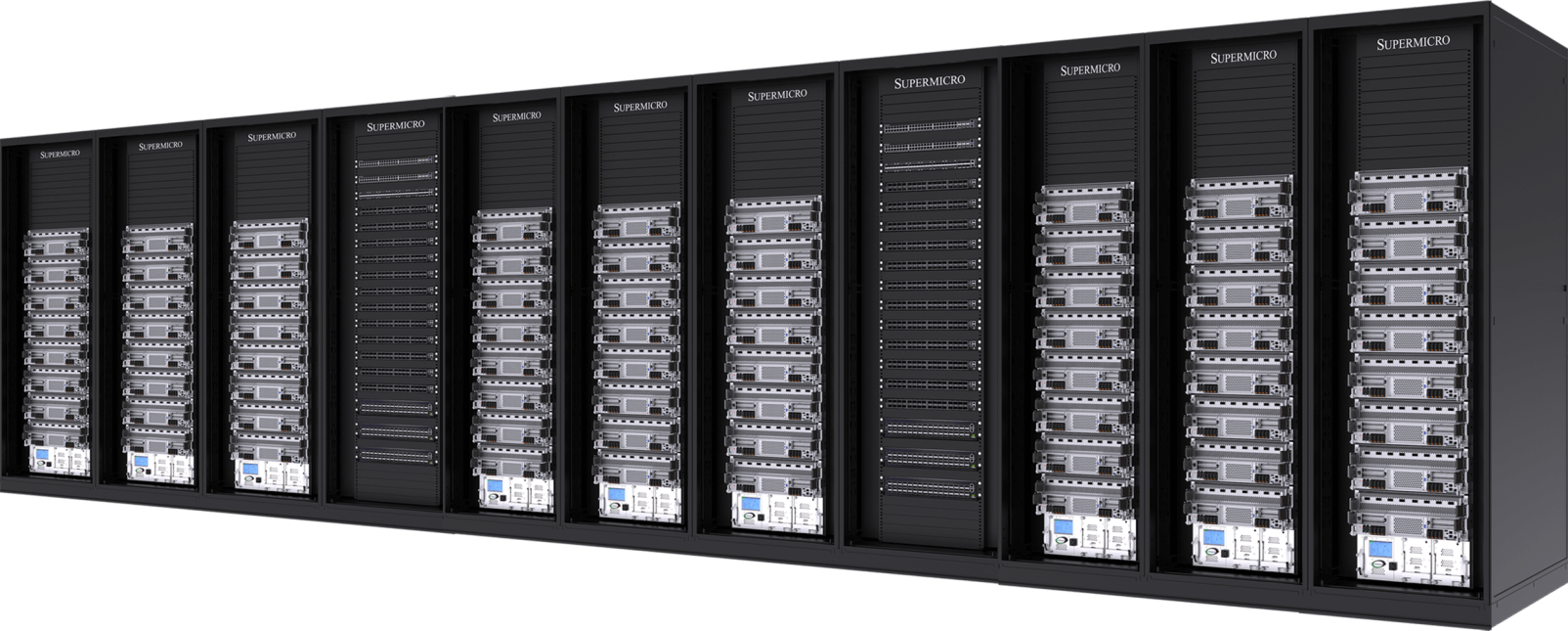

Clúster de IA NVIDIA HGX B200 refrigerado por aire

Con 32 sistemas NVIDIA HGX B200 de 8 GPU, 10U refrigerados por aire (256 GPU) en 9 racks

- Arquitectura líder en la industria probada con una nueva plataforma de sistema refrigerado por aire térmicamente optimizada

- 45 TB de memoria HBM3e en una unidad escalable

- Amplíe con Ethernet NVIDIA Spectrum-X de 400 Gb/s o NVIDIA Quantum-2 InfiniBand.

- Opciones de estructura de almacenamiento dedicada con compatibilidad total con NVIDIA GPUDirect RDMA y almacenamiento o RoCE.

- Nodos de sistema certificados por NVIDIA, totalmente compatibles con las plataformas de software de IA de NVIDIA, incluidas NVIDIA AI Enterprise y NVIDIA Run:ai.

Nodo informático

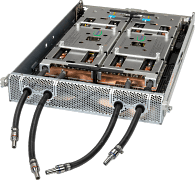

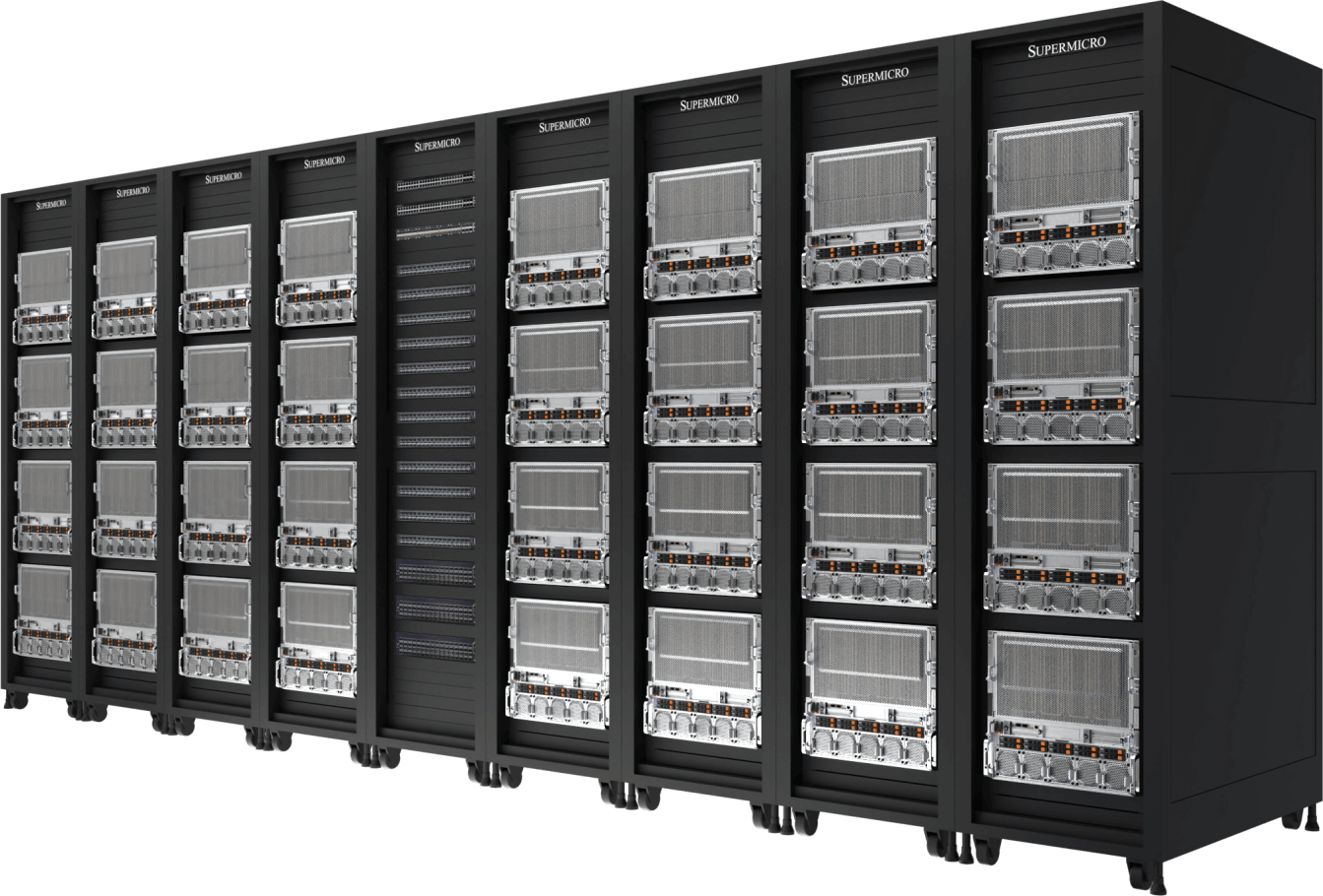

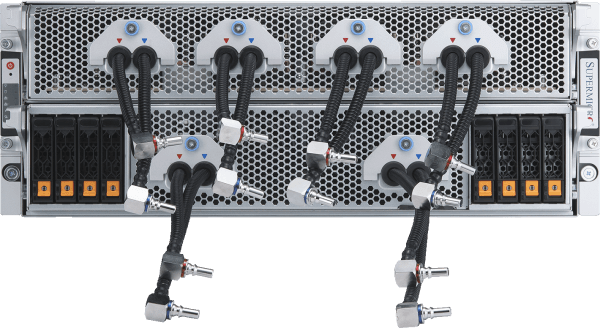

NVIDIA GB200 NVL72

Ordenador Exascale refrigerado por líquido en un solo bastidor

- 72 GPU NVIDIA Blackwell B200 que actúan como una sola GPU con un enorme conjunto de memoria HBM3e (13,5 TB por rack).

- Conmutador NVLink 9x, 4 puertos por bandeja informática que conectan 72 GPU para proporcionar una interconexión GPU-GPU de 1,8 TB/s.

- Refrigeración líquida Supermicro con unidad de distribución de refrigerante (CDU) en rack con capacidad de 250 kW, fuente de alimentación redundante y dos bombas intercambiables en caliente.

- Opciones de estructura de almacenamiento dedicada con compatibilidad total con NVIDIA GPUDirect RDMA y almacenamiento o RoCE.

- Amplíe con Ethernet NVIDIA Spectrum™-X de 400 Gb/s o NVIDIA Quantum-2 InfiniBand.

- Diseñado para ser totalmente compatible con las plataformas de software de IA de NVIDIA, incluidas NVIDIA AI Enterprise y NVIDIA Run:ai.

Bandeja de computación

- ARS-121GL-NBO-LCC

(no se vende por separado)

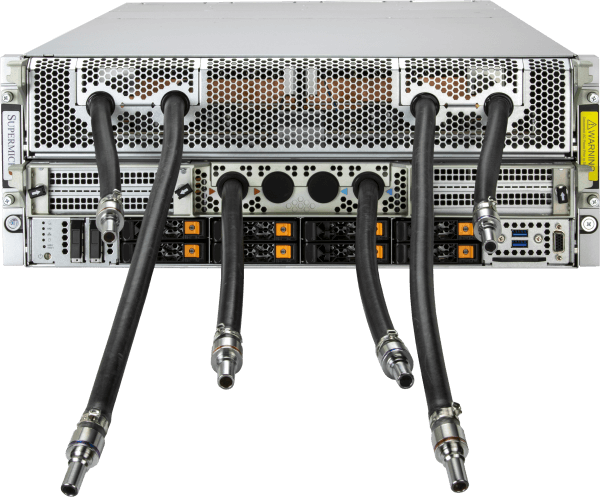

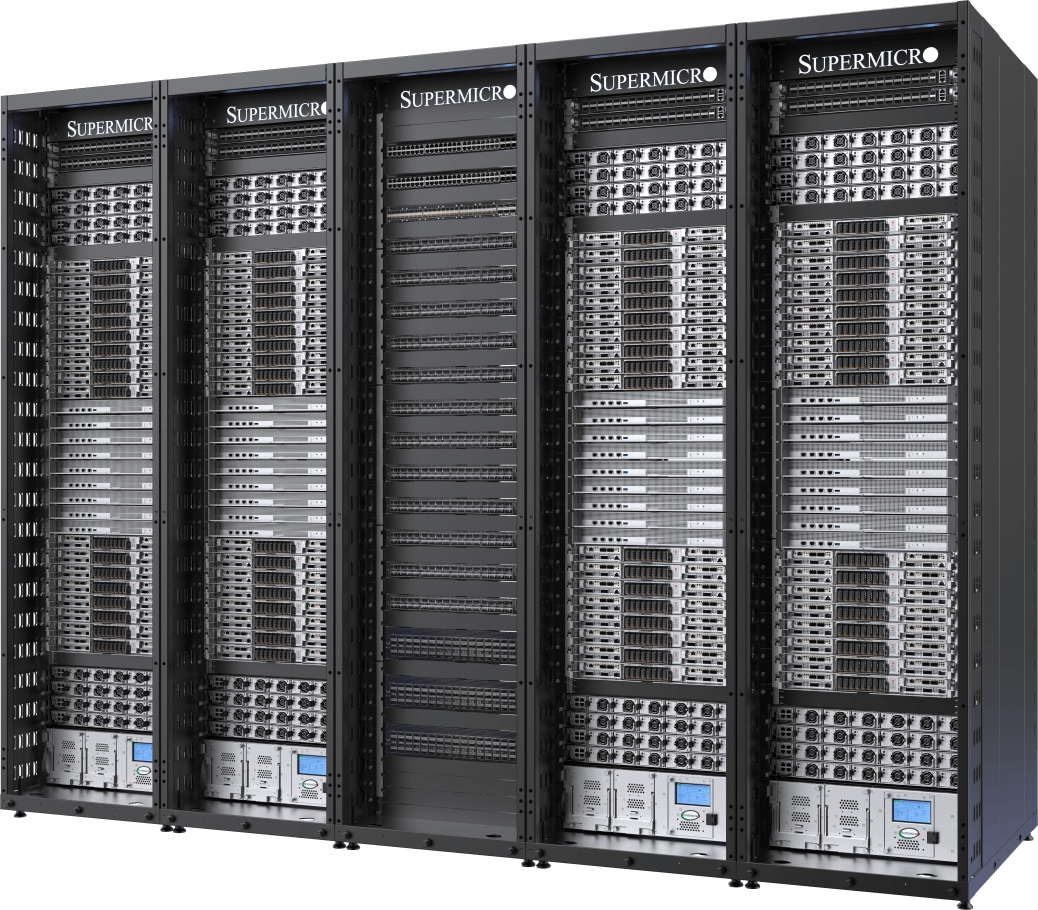

Clúster líder de IA con refrigeración líquida

Con 32 sistemas NVIDIA HGX H100/H200 de 8 GPU, 4U y refrigeración líquida (256 GPU) en 5 racks

- Duplicación de la densidad de cálculo a través de la solución de refrigeración líquida personalizada de Supermicro con una reducción de hasta el 40% en el coste de electricidad para el centro de datos.

- 256 GPU NVIDIA H100/H200 en una unidad escalable

- 20 TB de HBM3 con H100 o 36 TB de HBM3e con H200 en una unidad escalable

- Opciones de estructura de almacenamiento dedicada con compatibilidad total con NVIDIA GPUDirect RDMA y almacenamiento o RoCE.

- Amplíe con Ethernet NVIDIA Spectrum™-X de 400 Gb/s o NVIDIA Quantum-2 InfiniBand.

- Nodos de sistema certificados por NVIDIA, totalmente compatibles con las plataformas de software de IA de NVIDIA, incluidas NVIDIA AI Enterprise y NVIDIA Run:ai.

Nodo informático

Diseño probado

Con 32 sistemas NVIDIA HGX H100/H200 de 8U refrigerados por aire (256 GPU) en 9 racks

- Arquitectura probada líder del sector para implantaciones de infraestructuras de IA a gran escala

- 256 GPU NVIDIA H100/H200 en una unidad escalable

- 20 TB de HBM3 con H100 o 36 TB de HBM3e con H200 en una unidad escalable

- Amplíe con Ethernet NVIDIA Spectrum™-X de 400 Gb/s o NVIDIA Quantum-2 InfiniBand.

- Tejido de almacenamiento de canalización de datos de IA personalizable con opciones de sistemas de archivos paralelos líderes del sector

- Nodos de sistema certificados por NVIDIA, totalmente compatibles con las plataformas de software de IA de NVIDIA, incluidas NVIDIA AI Enterprise y NVIDIA Run:ai.

Nodo informático