Beschleunigte Building Blocks mit Intel-GPUs

Für KI und -Inferenz im Cloud-Maßstab

Die Nachfrage nach hochleistungsfähigen KI Learning (DL)-Trainingscomputern hat sich laut OpenAI seit 2013 alle 3,5 Monate verdoppelt und steigt mit der wachsenden Größe der Datensätze und der Anzahl der Anwendungen und Dienste, die auf großen Sprachmodellen (LLMs), Computer Vision, Empfehlungssystemen und mehr basieren.

Angesichts der steigenden Nachfrage nach höherer Trainings- und Inferenzleistung, Durchsatz und Kapazität benötigt die Branche speziell entwickelte Systeme, die eine höhere Effizienz, geringere Kosten, einfache Implementierung, Flexibilität für Anpassungen und Skalierbarkeit von KI bieten. KI einer unverzichtbaren Technologie für verschiedene Bereiche geworden, darunter Copiloten, virtuelle Assistenten, Fertigungsautomatisierung, autonomer Fahrzeugbetrieb und medizinische Bildgebung, um nur einige zu nennen. Supermicro mit Intel zusammengetan, um Cloud-Scale-Systeme und Rack-Designs mit Intel Gaudi KI anzubieten.

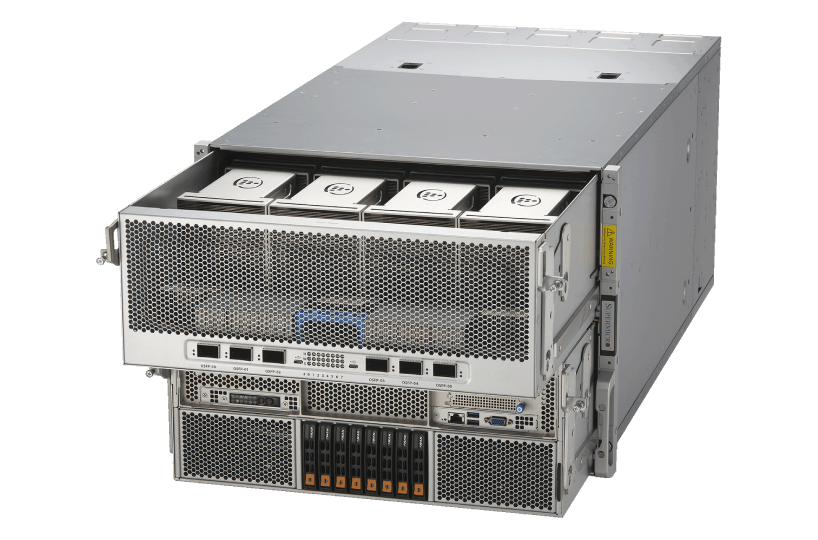

Neue Supermicro Gaudi® 3 KI und Inferenzplattform

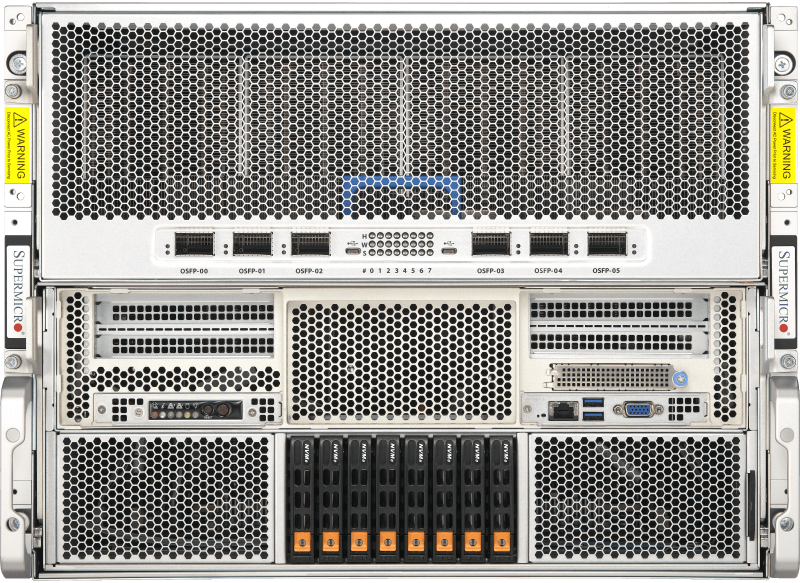

Die neue Supermicro KI bietet mehr Auswahl auf dem KI für Unternehmen und basiert auf den Intel® Gaudi 3-Beschleunigern der dritten Generation, die entwickelt wurden, um die Effizienz des Trainings und KI großer KI weiter zu steigern. Die X14 Gaudi 3-Lösung Supermicro ist sowohl in luftgekühlter als auch in flüssigkeitsgekühlter Konfiguration erhältlich und lässt sich leicht skalieren, um eine Vielzahl von KI zu erfüllen.

- GPU: 8 Gaudi 3 HL-325L (luftgekühlt) oder HL-335 (flüssigkeitsgekühlt) Beschleuniger auf OAM 2.0 Baseboard

- CPU: Zwei Intel® Xeon® 6 Prozessoren

- Speicher: 24 DIMMs - bis zu 6 TB Speicher in 1DPC

- Laufwerke: Bis zu 8 hot-swap PCIe 5.0 NVMe

- Stromversorgungen: 8 3000W hocheffiziente, voll redundante (4+4) Titanium Level

- Netzwerk: 6 integrierte OSFP 800GbE-Ports für Scale-out

- Erweiterungssteckplätze: 2 PCIe 5.0 x16 (FHHL) + 2 PCIe 5.0 x8 (FHHL)

- Arbeitsbelastungen: KI und Inferenz

Supermicro KI

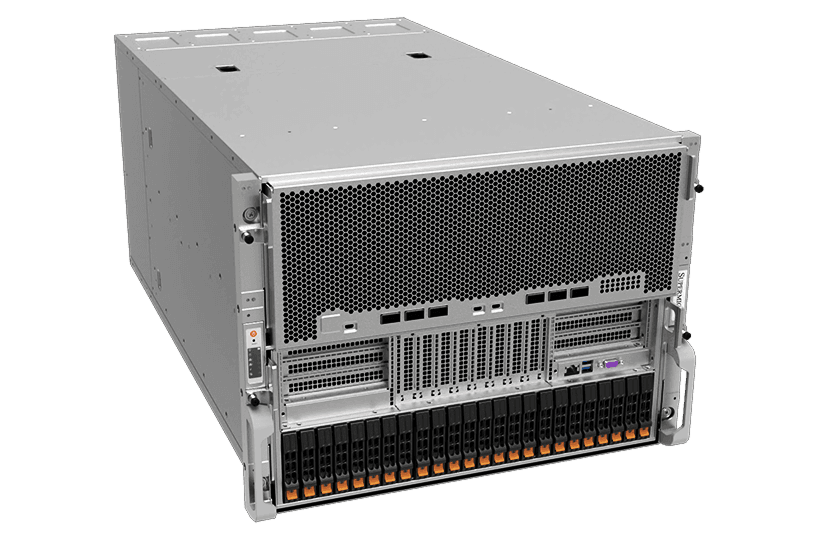

Aufbauend auf dem Erfolg des ursprünglichen Supermicro KI legt der Gaudi 2 KI den Schwerpunkt auf zwei wesentliche Aspekte: die Integration von KI mit integrierten Hochgeschwindigkeits-Netzwerkmodulen zur Steigerung der Betriebseffizienz beim Training modernster KI und die Bereitstellung der Auswahlmöglichkeiten , die die KI benötigt.

- GPU: 8 Gaudi2 HL-225H Mezzanine-Karten

- CPU: Zwei Intel® Xeon® Prozessoren der 3. Generation, skalierbar

- Speicher: 32 DIMMs - bis zu 8TB registrierter ECC DDR4-3200MHz SDRAM

- Laufwerke: bis zu 24 Hot-Swap-Laufwerke (SATA/NVMe/SAS)

- Leistung: 6x 3000W Hocheffiziente (54V+12V) voll-redundante Netzteile

- Vernetzung: 24x 100GbE (48 x 56Gb) PAM4 SerDes Links durch 6 QSFP-DDs

- Erweiterungssteckplätze: 2x PCIe 4.0-Switches

- Arbeitsbelastungen: KI und Inferenz

Supermicro mit Intel® Gaudi® 3 ist für reale KI optimiert.

Neue Supermicro mit Intel® Xeon® Prozessoren der 6er-Serie mit P-Cores und Intel Gaudi 3-Beschleunigern zeigen Leistungssteigerungen gegenüber früheren Generationen

Supermicro Intel® Gaudi® KI -Cluster-Referenzdesign

Beschleunigung und Kostensenkung von KI mit dem X14 Intel® Gaudi® 3 Accelerator-basierten System Supermicro durch den Einsatz von Open-Source-Software und Ethernet nach Industriestandard

Supermicro GAUDI 3 KI skalierbare Leistung für KI

Optimierte Lösungen für Rechenzentren jeder Größe und Arbeitslast für neue Services und höhere Kundenzufriedenheit

Supermicro Intel GAUDI 3-Systeme verbessern KI von Unternehmen

KI mit hoher Bandbreite unter Verwendung von Intel Xeon 6 Prozessoren für effizientes LLM- und GenAI-Training und Inferenz über Unternehmensskalen hinweg

Supermicro Hyper KI von Unternehmen auf der VMWARE-Plattform

Rechnerische KI Anwendungsfälle: Large Language Model (LLM) und KI - ResNet50 auf Intel® Data Center Flex 170 GPU

Beschleunigung von KI mit Supermicro in der INTEL® Developer Cloud

Supermicro KI mit Intel® Xeon®-Prozessoren und Intel® Gaudi® 2 KI bieten Entwicklern und Unternehmen leistungsstarke und hocheffiziente KI , Trainings- und Inferenzfunktionen.

Überlegene Medienverarbeitungs- und Bereitstellungslösung auf Basis von Supermicro mit Intel® Data Center GPU Flex-Serie

Supermicro mit Intel® Data Center GPU Flex-Serie

Supermicro : Neue Medienverarbeitungslösungen auf Basis der Intel Data Center GPU Flex-Serie

Sehen Sie sich an, wie unsere Produktexperten die neuen Supermicro auf Basis der gerade angekündigten Intel Data Center GPU Flex-Serie diskutieren. Erfahren Sie, wie diese Lösungen Ihnen und Ihrem Unternehmen zugute kommen können.

Bereitstellung von skalierbarem Cloud-Gaming

Supermicro mit Intel® Data Center GPU Flex-Serie

Supermicro alle Systemkomponenten für Cloud-Dienstleister, um eine umweltfreundliche, kostengünstige und profitable Cloud-Gaming-Infrastruktur aufzubauen.

Innovative Lösungen für Cloud Gaming, Medien, Transcoding und KI

Sep 08 2022, 10:00 Uhr PDT

Produkt- und Lösungsexperten Supermicro Intel werden in einer informellen Sitzung die Vorteile der Lösungen in den Bereichen Cloud Gaming, Medienbereitstellung, Transcodierung und KI unter Verwendung der kürzlich angekündigten Intel Flex Series GPUs diskutieren. Das Webinar erläutert die Vorteile der Supermicro , die idealen Server und die Vorteile der Verwendung der Intel Flex Series GPUs.

Supermicro Habana® Hochleistungsfähiges, hocheffizientes KI

Ermöglicht ein bis zu 40 % besseres Preis-Leistungs-Verhältnis für Deep Learning-Training als herkömmliche KI