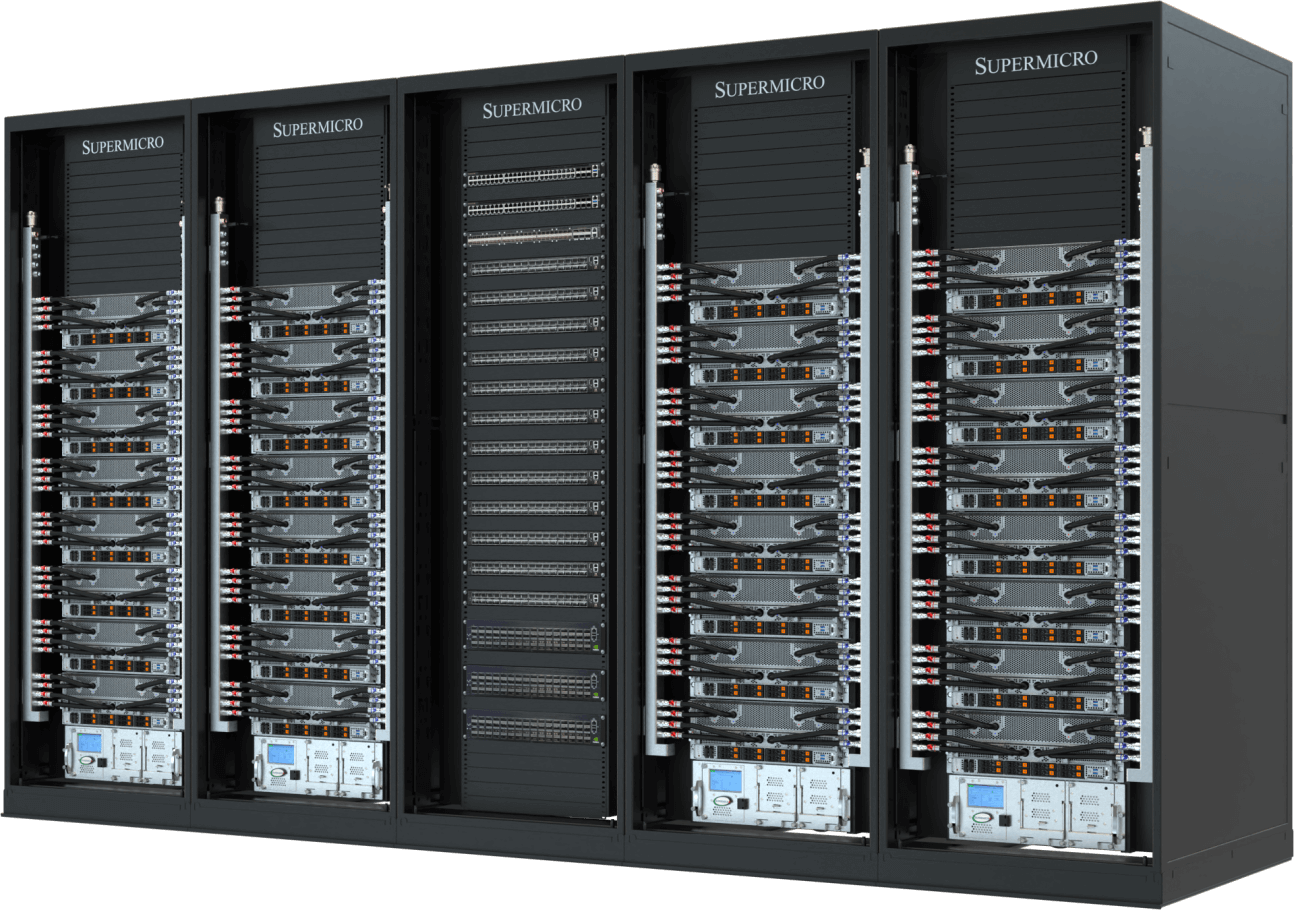

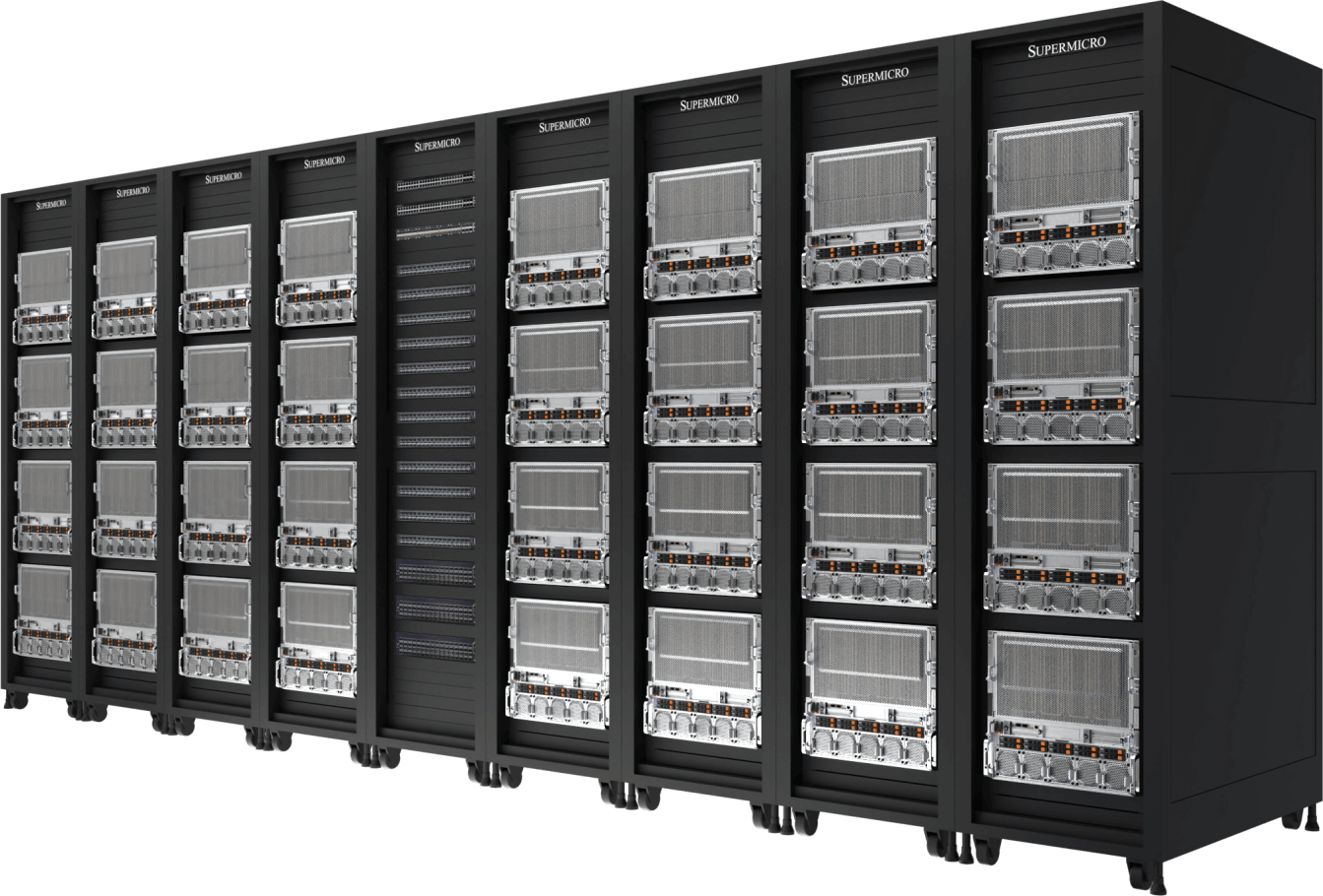

Im Zeitalter der KI wird die Rechenleistung nicht mehr nur anhand der Anzahl der Server gemessen. Miteinander verbundene GPUs, CPUs, Speicher und diese Ressourcen über mehrere Knoten in Racks hinweg bilden die Grundlage der heutigen künstlichen Intelligenz. Die Infrastruktur erfordert Hochgeschwindigkeits-Netzwerkstrukturen mit geringer Latenz sowie sorgfältig konzipierte Kühltechnologien und Stromversorgungslösungen, um eine optimale Leistung und Effizienz für jede Rechenzentrumsumgebung zu gewährleisten. Die SuperCluster-Lösung Supermicrobietet End-to KI für sich schnell entwickelnde generative KI große Sprachmodelle (LLMs).

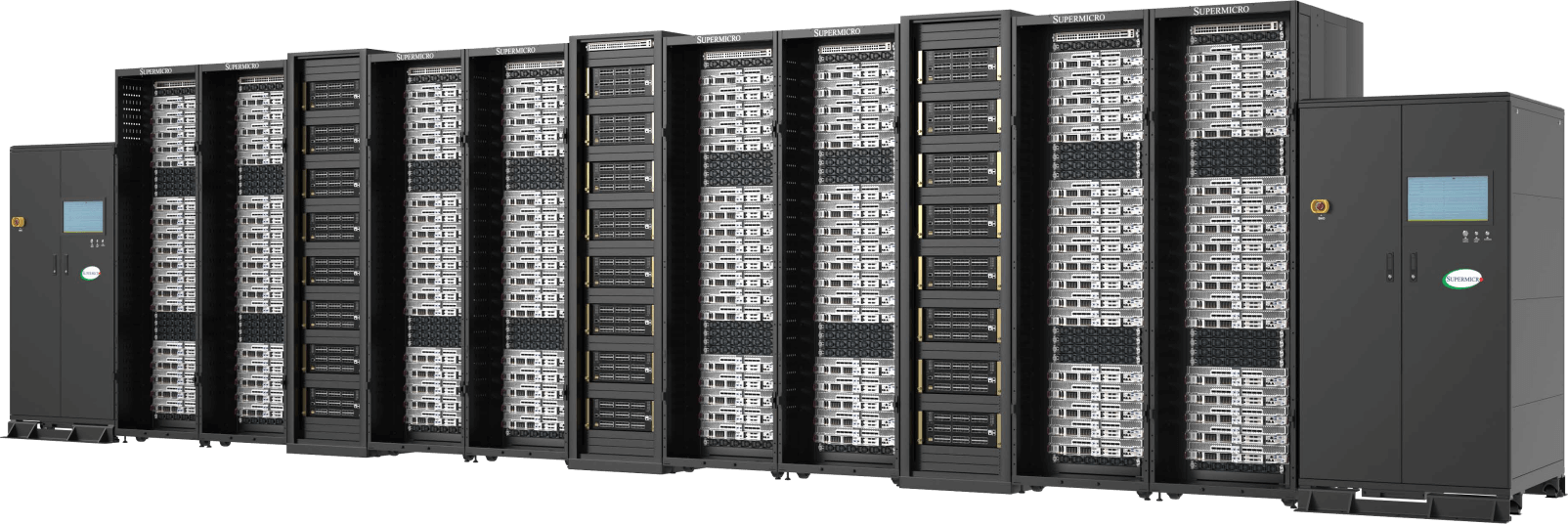

Vollständige Integration in großem Maßstab

Entwurf und Bau von kompletten Racks und Clustern mit einer weltweiten Fertigungskapazität von bis zu 5,000 Gestelle pro Monat

Testen, Validieren, Bereitstellen mit Vor-Ort-Service

Bewährte L11- und L12-Prüfverfahren validieren die betriebliche Effektivität und Effizienz vor der Auslieferung gründlich

Flüssigkeitskühlung/Luftkühlung

Vollständig integrierte Flüssigkeits- oder Luftkühllösung mit GPU- und CPU-Kühlplatten, Kühlverteilern und Verteilern

Versorgung und Bestandsmanagement

One-Stop-Shop für die schnelle und pünktliche Lieferung vollständig integrierter Racks, um die Zeit bis zur Lösung zu verkürzen und eine schnelle Bereitstellung zu ermöglichen

Die schlüsselfertige Rechenzentrumslösung beschleunigt die Zeit bis zur Bereitstellung für geschäftskritische Unternehmensanwendungen und beseitigt die Komplexität des Aufbaus eines großen Clusters, die bisher nur durch intensive Designabstimmung und zeitaufwändige Optimierung des Supercomputing erreicht werden konnte.

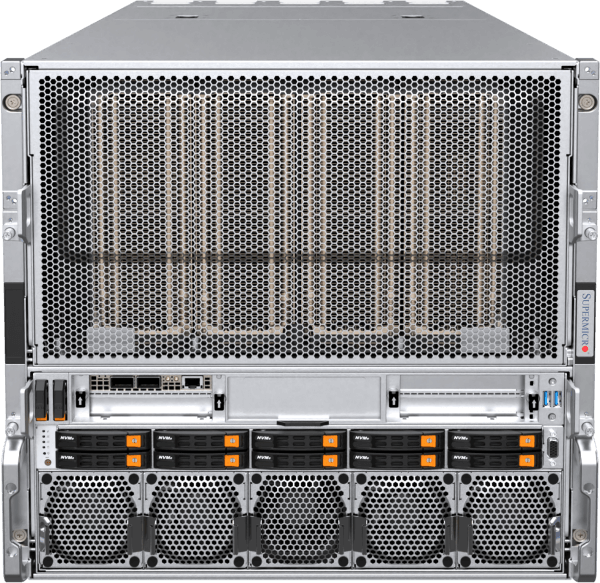

Flüssigkeitsgekühlter 2-OU NVIDIA HGX B300 KI

Vollständig integrierter, flüssigkeitsgekühlter Cluster mit 144 Knoten und bis zu 1152 NVIDIA B300-GPUs

- Unübertroffene KI dank NVIDIA HGX B300 mit kompakten 2-OU-Systemknoten mit Flüssigkeitskühlung

- Supermicro Liquid Cooling mit 1,8 MW Leistung in Reihe geschalteten CDUs (CDU-Optionen im Rack verfügbar)

- Große HBM3e-GPU-Speicherkapazität (288 GB* HBM3e-Speicher pro GPU) und Systemspeicherbedarf für das Training von Basismodellen

- Skalierbarkeit mit NVIDIA Quantum-X800 InfiniBand für KI ultra und hoher Bandbreite

- Spezielle Speicher-Fabric-Optionen mit vollständiger Unterstützung für NVIDIA GPUDirect RDMA und Storage oder RoCE

- Entwickelt für die vollständige Unterstützung von NVIDIA KI , einschließlich NVIDIA KI und NVIDIA Run:KI

Rechenknoten

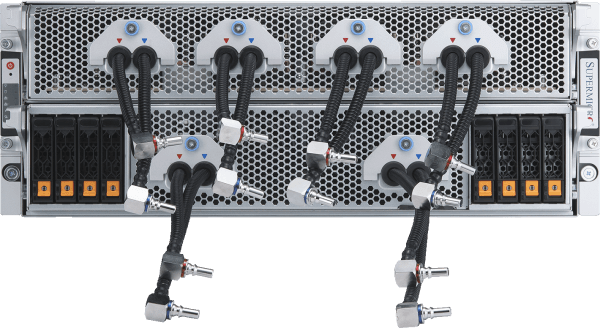

Flüssigkeitsgekühlter 4U NVIDIA HGX B300 KI

Vollständig integrierter, flüssigkeitsgekühlter Cluster mit 72 Knoten und bis zu 576 NVIDIA B300-GPUs

- Setzen Sie leistungsstarkes KI und KI-Inferenz mit NVIDIA HGX B300 ein, das für Rechendichte und Wartungsfreundlichkeit optimiert ist.

- Supermicro Liquid Cooling wurde für einen dauerhaften Hochleistungsbetrieb und eine verbesserte Energieeffizienz entwickelt.

- Große HBM3e-GPU-Speicherkapazität (288 GB* HBM3e-Speicher pro GPU) und Systemspeicherbedarf für das Training von Basismodellen

- Skalierung mit NVIDIA Spectrum™-X Ethernet oder NVIDIA Quantum-X800 InfiniBand

- Spezielle Speicher-Fabric-Optionen mit vollständiger Unterstützung für NVIDIA GPUDirect RDMA und Storage oder RoCE

- Entwickelt für die vollständige Unterstützung von NVIDIA KI , einschließlich NVIDIA KI und NVIDIA Run:KI

Rechenknoten

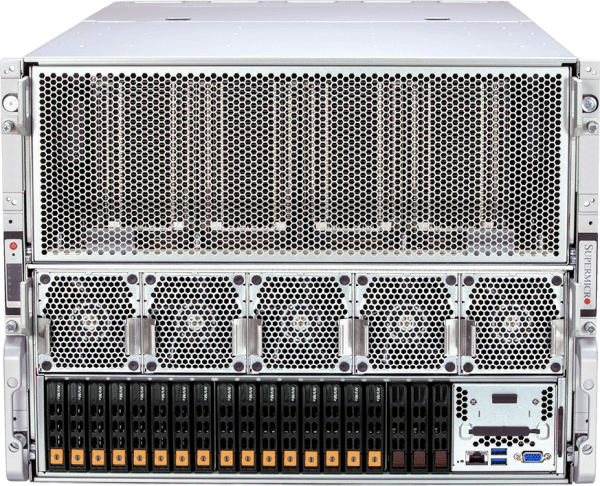

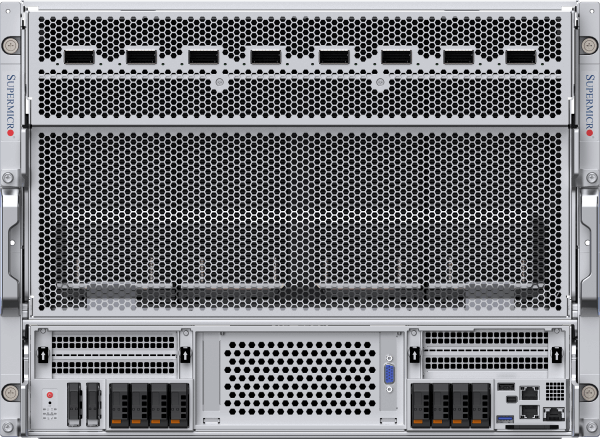

Luftgekühlter 8U NVIDIA HGX B300 KI

Vollständig integrierter luftgekühlter Cluster mit 72 Knoten und bis zu 576 NVIDIA B300-GPUs

- Skalierbares KI und Inferenz mit NVIDIA HGX B300 in einem luftgekühlten Design für eine breitere Kompatibilität mit Rechenzentren

- Optimierter Luftstrom und thermisches Design ermöglichen einen leistungsstarken Betrieb ohne Flüssigkeitskühlung.

- Große HBM3e-GPU-Speicherkapazität (288 GB* HBM3e-Speicher pro GPU) und Systemspeicherbedarf für das Training von Basismodellen

- Skalierung mit NVIDIA Spectrum™-X Ethernet oder NVIDIA Quantum-X800 InfiniBand

- Spezielle Speicher-Fabric-Optionen mit vollständiger Unterstützung für NVIDIA GPUDirect RDMA und Storage oder RoCE

- Entwickelt für die vollständige Unterstützung von NVIDIA KI , einschließlich NVIDIA KI und NVIDIA Run:KI

Rechenknoten

Flüssigkeitsgekühlter NVIDIA HGX B200 KI

Mit bis zu 32 NVIDIA HGX B200 8-GPU, 4U flüssigkeitsgekühlte Systeme (256 GPUs) in 5 Racks

- Nutzen Sie die Spitzenleistung im Bereich KI und -Inferenz mit 256 NVIDIA B200-GPUs in einer skalierbaren Einheit (5 Racks).

- Supermicro Liquid Cooling mit einer Kühlmittelverteilungseinheit (CDU) mit einer Kapazität von 250 kW im Rack, redundanter Stromversorgung und zwei Hot-Swap-Pumpen

- 45 TB HBM3e-Speicher in einer skalierbaren Einheit

- Skalierbarkeit mit 400 Gb/s NVIDIA Spectrum™-X Ethernet oder NVIDIA Quantum-2 InfiniBand

- Spezielle Speicher-Fabric-Optionen mit vollständiger Unterstützung für NVIDIA GPUDirect RDMA und Storage oder RoCE

- Entwickelt für die vollständige Unterstützung von NVIDIA KI , einschließlich NVIDIA KI und NVIDIA Run:KI

Rechenknoten

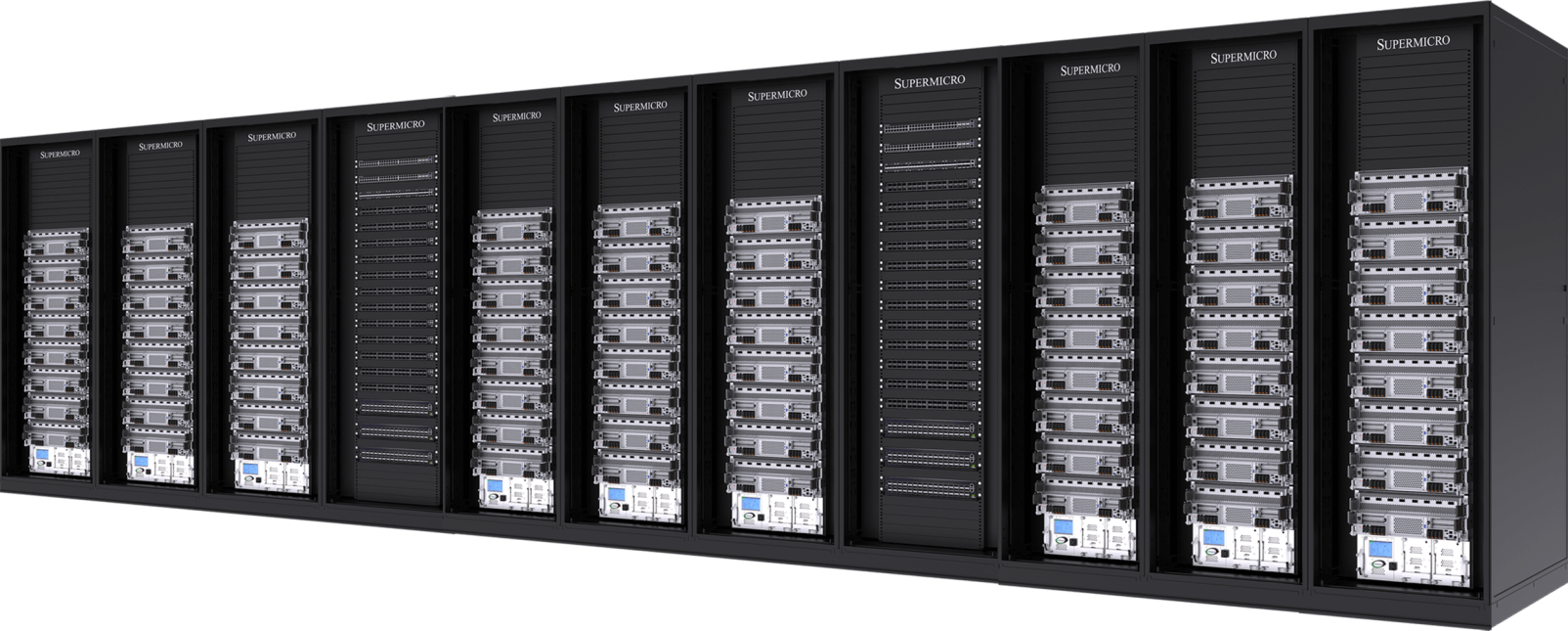

Luftgekühlter NVIDIA HGX B200 KI

Mit 32 NVIDIA HGX B200 8-GPU, 10U luftgekühlte Systeme (256 GPUs) in 9 Racks

- Bewährte, branchenführende Architektur mit neuer, thermisch optimierter, luftgekühlter Systemplattform

- 45 TB HBM3e-Speicher in einer skalierbaren Einheit

- Skalierbarkeit mit 400 Gb/s NVIDIA Spectrum-X Ethernet oder NVIDIA Quantum-2 InfiniBand

- Spezielle Speicher-Fabric-Optionen mit vollständiger Unterstützung für NVIDIA GPUDirect RDMA und Storage oder RoCE

- NVIDIA-zertifizierte Systemknoten, die NVIDIA KI vollständig unterstützen, darunter NVIDIA KI und NVIDIA Run:KI

Rechenknoten

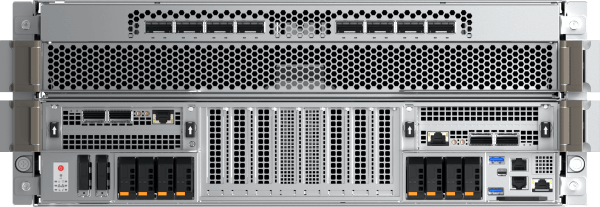

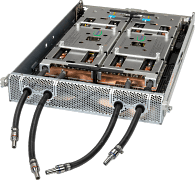

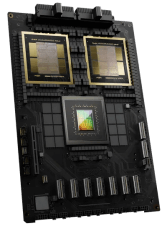

NVIDIA GB200 NVL72

Flüssigkeitsgekühlter Exascale-Rechner in einem einzigen Rack

- 72 NVIDIA Blackwell B200-GPUs, die als eine GPU mit einem riesigen Pool an HBM3e-Speicher (13,5 TB pro Rack) fungieren

- 9x NVLink-Switch, 4 Ports pro Rechenfach, der 72 GPUs verbindet, um eine GPU-zu-GPU-Verbindung mit 1,8 TB/s bereitzustellen

- Supermicro Liquid Cooling mit einer Kühlmittelverteilungseinheit (CDU) mit einer Kapazität von 250 kW im Rack, redundanter Stromversorgung und zwei Hot-Swap-Pumpen

- Spezielle Speicher-Fabric-Optionen mit vollständiger Unterstützung für NVIDIA GPUDirect RDMA und Storage oder RoCE

- Skalierbarkeit mit 400 Gb/s NVIDIA Spectrum™-X Ethernet oder NVIDIA Quantum-2 InfiniBand

- Entwickelt für die vollständige Unterstützung von NVIDIA KI , einschließlich NVIDIA KI und NVIDIA Run:KI

Fach für Rechenleistung

- ARS-121GL-NBO-LCC

(nicht einzeln erhältlich)

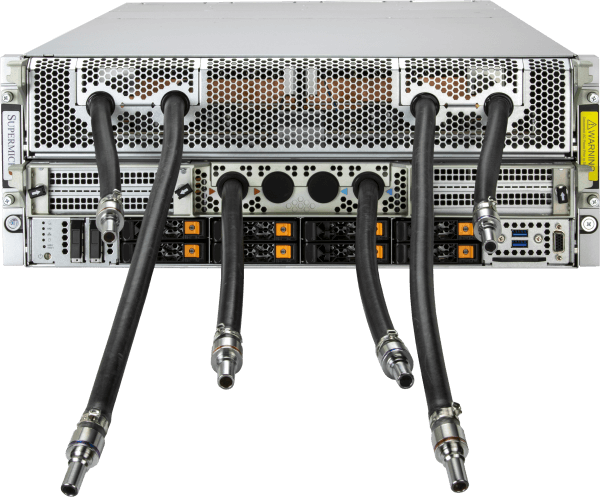

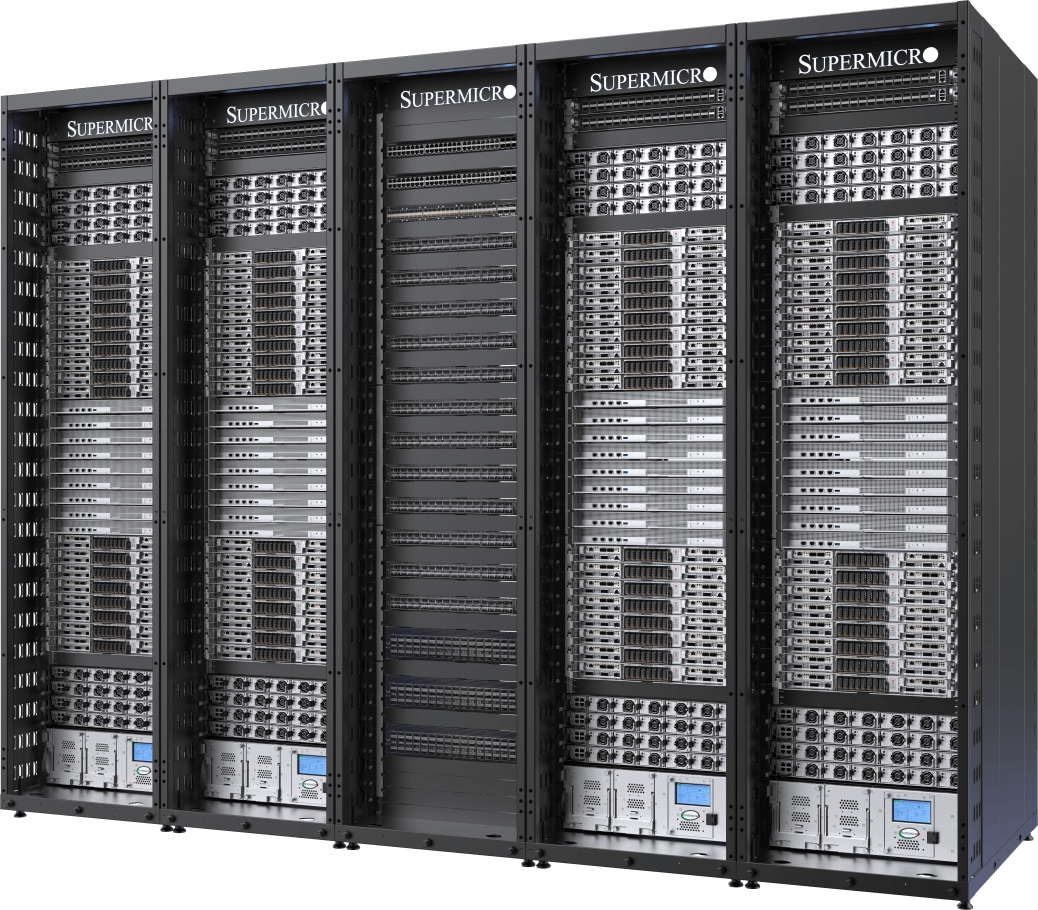

Führender flüssigkeitsgekühlter KI

Mit 32 NVIDIA HGX H100/H200 8-GPU, 4U flüssigkeitsgekühlten Systemen (256 GPUs) in 5 Racks

- Verdopplung der Rechendichte durch die maßgeschneiderte Flüssigkeitskühlungslösung Supermicromit einer Senkung der Stromkosten für Rechenzentren um bis zu 40 %.

- 256 NVIDIA H100/H200-GPUs in einer skalierbaren Einheit

- 20 TB HBM3 mit H100 oder 36 TB HBM3e mit H200 in einer skalierbaren Einheit

- Spezielle Speicher-Fabric-Optionen mit vollständiger Unterstützung für NVIDIA GPUDirect RDMA und Storage oder RoCE

- Skalierbarkeit mit 400 Gb/s NVIDIA Spectrum™-X Ethernet oder NVIDIA Quantum-2 InfiniBand

- NVIDIA-zertifizierte Systemknoten, die NVIDIA KI vollständig unterstützen, darunter NVIDIA KI und NVIDIA Run:KI

Rechenknoten

Bewährtes Design

Mit 32 NVIDIA HGX H100/H200 8-GPU, 8U luftgekühlte Systeme (256 GPUs) in 9 Racks

- Bewährte, branchenführende Architektur für den Einsatz von KI in großem Maßstab

- 256 NVIDIA H100/H200-GPUs in einer skalierbaren Einheit

- 20 TB HBM3 mit H100 oder 36 TB HBM3e mit H200 in einer skalierbaren Einheit

- Skalierbarkeit mit 400 Gb/s NVIDIA Spectrum™-X Ethernet oder NVIDIA Quantum-2 InfiniBand

- Anpassbare KI -Speicherstruktur mit branchenführenden parallelen Dateisystemoptionen

- NVIDIA-zertifizierte Systemknoten, die NVIDIA KI vollständig unterstützen, darunter NVIDIA KI und NVIDIA Run:KI

Rechenknoten