GPU-Server-Systeme

Unerreichte GPU-Systeme: Deep Learning-optimierte Server für das moderne Rechenzentrum

NVIDIA GB300 NVL72

Liquid Cooled Rack-Scale Solution with 72 NVIDIA B300 GPUs and 36 Grace CPUs

- GPU: 72 NVIDIA B300 GPUs via NVIDIA Grace Blackwell Superchips

- CPU: 36 NVIDIA Grace CPUs via NVIDIA Grace Blackwell Superchips

- Memory: Up to 21 TB HBM3e (GPU Memory), Up to 17 TB LPDDR5X (System Memory)

- Drives: up to 144 E1.S PCIe 5.0 drive bays

Universal GPU Systems

Modular Building Block Design, Future Proof Open-Standards Based Platform in 4U, 5U, 8U, or 10U for Large Scale AI training and HPC Applications

- GPU: NVIDIA HGX H100/H200/B200/B300, AMD Instinct MI350 Series/MI325X/MI300X/MI250 OAM Accelerator, Intel Data Center GPU Max Series

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 32 DIMMs, 9TB

- Drives: Up to 24 Hot-swap E1.S, U.2 or 2.5" NVMe/SATA drives

Liquid-Cooled Universal GPU Systems

Direct-to-chip liquid-cooled systems for high-density AI infrastructure at scale.

- GPU: NVIDIA HGX H100/H200/B200

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 32 DIMMs, 9TB

- Drives: Up to 24 Hot-swap U.2 or 2.5" NVMe/SATA drives

3U/4U/5U GPU Lines with PCIe 5.0

Maximum Acceleration and Flexibility for AI, Deep Learning and HPC Applications

- GPU: Up to 10 NVIDIA H100 PCIe GPUs, or up to 10 double-width PCIe GPUs

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 32 DIMMs, 9TB or 12TB

- Drives: Up to 24 Hot-swap 2.5" SATA/SAS/NVMe

NVIDIA MGX™ Systems

Modular Building Block Platform Supporting Today's and Future GPUs, CPUs, and DPUs

- GPU: Up to 4 NVIDIA PCIe GPUs including NVIDIA RTX PRO™ 6000 Blackwell Server Edition, H200 NVL, H100 NVL, and L40S

- CPU: NVIDIA GH200 Grace Hopper™ Superchip, Grace™ CPU Superchip, or Intel® Xeon®

- Memory: Up to 960GB ingegrated LPDDR5X memory (Grace Hopper or Grace CPU Superchip) or 16 DIMMs, up to 4TB DRAM (Intel)

- Drives: Up to 8 E1.S + 4 M.2 drives

AMD APU Systems

Multi-processor system combining CPU and GPU, Designed for the Convergence of AI and HPC

- GPU: 4 AMD Instinct MI300A Accelerated Processing Unit (APU)

- CPU: AMD Instinct™ MI300A Accelerated Processing Unit (APU)

- Memory: Up to 512GB integrated HBM3 memory (4x 128GB)

- Drives: Up to 8 2.5" NVMe or Optional 24 2.5" SATA/SAS via storage add-on card + 2 M.2 drives

4U GPU Lines with PCIe 4.0

Flexible Design for AI and Graphically Intensive Workloads, Supporting Up to 10 GPUs

- GPU: NVIDIA HGX A100 8-GPU with NVLink, or up to 10 double-width PCIe GPUs

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 32 DIMMs, 8TB DRAM or 12TB DRAM + PMem

- Drives: Up to 24 Hot-swap 2.5" SATA/SAS/NVMe

2U 2-Node Multi-GPU with PCIe 4.0

Dense and Resource-saving Multi-GPU Architecture for Cloud-Scale Data Center Applications

- GPU: Up to 3 double-width PCIe GPUs per node

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 8 DIMMs, 2TB per node

- Drives: Up to 2 front hot-swap 2.5” U.2 per node

GPU Workstation

Flexible Solution for AI/Deep Learning Practitioners and High-end Graphics Professionals

- GPU: Up to 4 double-width PCIe GPUs

- CPU: Intel® Xeon®

- Memory: Up to 16 DIMMs, 6TB

- Drives: Up to 8 hot-swap 2.5” SATA/NVMe

Supermicro -Testbericht: Eine Woche mit einem NVIDIA HGX B200

Das JumpStart-Programm Supermicroverfolgt einen ganz anderen Ansatz bei der Hardware-Bewertung. Anstelle einer kurzen, vorab festgelegten Demo in einer gemeinsam genutzten Laborumgebung bietet JumpStart qualifizierten Kunden kostenlosen, zeitlich begrenzten Bare-Metal-Zugriff auf einen Katalog echter Produktionsserver.

Sicherung von KI mit Intel® TDX, NVIDIA Confidential Computing und Supermicro mit NVIDIA HGX™ B200-GPUs: Eine Grundlage für vertrauliche KI großem Maßstab

Dieses Whitepaper untersucht, wie Intels Trust Domain Extensions (TDX) und NVIDIA Confidential Computing in Verbindung mit den HGX B200-basierten Systemen Supermicrogemeinsam eine leistungsstarke, sichere und skalierbare Plattform für KI der nächsten Generation bieten.

Sakura Internet Koukaryoku Cloud Services beschleunigen KI

Sakura Internet Koukaryoku entwickelt neue Dienste mit dem 8U SYS-821GE-TNR-System Supermicro, das die NVIDIA HGX™ 8-GPU KI integriert und generative KI beschleunigt.

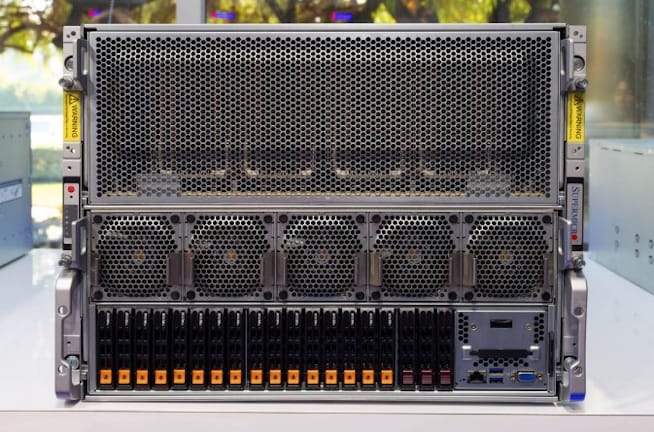

Supermicro 8x NVIDIA H200 GPU luftgekühlter KI

Heute setzen wir unsere Betrachtung massiver KI mit einem Blick auf den Supermicro fort. Wenn es um die Leistungsfähigkeit KI Supermicrogeht, ist dies eines der Systeme, das sich als luftgekühlter NVIDIA-Server von anderen auf dem Markt unterscheidet.

Supermicro GAUDI 3 KI skalierbare Leistung für KI

Optimierte Lösungen für Rechenzentren jeder Größe und Arbeitslast für neue Services und höhere Kundenzufriedenheit

Supermicro Intel GAUDI 3-Systeme verbessern KI von Unternehmen

KI mit hoher Bandbreite unter Verwendung von Intel Xeon 6 Prozessoren für effizientes LLM- und GenAI-Training und Inferenz über Unternehmensskalen hinweg

Lamini entscheidet sich für Supermicro Server für LLM-Tuning-Angebot

Durch den Einsatz von Supermicro -Servern mit AMD Instinct™ MI300X-Beschleunigern ist Lamini in der Lage, LLM-Tuning mit hoher Geschwindigkeit anzubieten.

Das Supermicro -System bietet eine vierfache Leistungssteigerung für ANSYS® LS-DYNA®.

Supermicro CPU Superchip-Systeme bieten 4-fache Leistung bei gleichem Stromverbrauch

Applied Digital baut mit Supermicro KI riesige KI auf

Applied Digital bietet Anwendern die neueste skalierbare KI HPC-Infrastruktur für KI und HPC-Simulationen mit Supermicro .

Supermicro AMD EPYC bieten KI (AS-4125GS-TNRT)

Supermicro langem GPU-Server in mehr Formen und Größen Supermicro , als wir in diesem Testbericht behandeln können. Heute schauen wir uns ihren relativ neuen luftgekühlten 4U-GPU-Server an, der zwei AMD EPYC Series CPUs, PCIe Gen5 und eine Auswahl von acht Add-in-GPU-Karten mit doppelter Breite oder zwölf mit einfacher Breite unterstützt.

Supermicro Nvidia entwickeln Lösungen zur Beschleunigung von CFD-Simulationen für die Automobil- und Luftfahrtindustrie

Supermicro mit NVIDIA Datacenter-GPUs sorgen für eine deutliche Beschleunigung von CFD-Simulationen und verkürzen so die Markteinführungszeit für Fertigungsunternehmen.

Ein Blick auf den flüssigkeitsgekühlten Supermicro 8x NVIDIA H100 KI

Heute wollten wir uns den flüssigkeitsgekühlten Supermicro ansehen. Dabei handelt es sich um das 8x NVIDIA H100-System Supermicromit einer Besonderheit: Es ist flüssigkeitsgekühlt, um die Kühlkosten und den Stromverbrauch zu senken. Da wir die Fotos hatten, dachten wir uns, wir würden dies in einen Artikel einbauen.

Optionen für den Zugriff auf PCIe-GPUs in einer Hochleistungsserverarchitektur

Das Verständnis der Konfigurationsoptionen für Supermicro sorgt für maximale Leistung bei Workloads.

Petrobras erwirbt von Atos integrierte Supermicro , um Kosten zu senken und die Genauigkeit der Exploration zu erhöhen

Supermicro verhilft Petrobras zum 33. Platz in der Top500-Rangliste vom November 2022

Supermicro ProphetStor maximieren die GPU-Effizienz für das Training von Multitenant-LLMs

In der dynamischen Welt der KI und des maschinellen Lernens ist die effiziente Verwaltung von GPU-Ressourcen in mandantenfähigen Umgebungen von größter Bedeutung, insbesondere beim Training von Large Language Models (LLM).

Supermicro erweitern das GPU-Angebot für SEEWEB und bieten anspruchsvollen Kunden schnellere Ergebnisse für KI HPC-Workloads.

Seeweb wählt Supermicro , um die Anforderungen seiner Kunden hinsichtlich HPC- und KI zu erfüllen

H12 Universal GPU Server

Offenes, auf Standards basierendes Serverdesign für architektonische Flexibilität

Epyc mit Wendell von Level1Techs

Wir betrachten einen Server, der für KI maschinelles Lernen optimiert ist. Supermicro viel Arbeit investiert, um so viel wie möglich in den 2114GT-DNR (2U2N) zu packen – einen Server mit optimierter Dichte. Das ist eine wirklich coole Konstruktion: In diesem 2U-Gehäuse befinden sich zwei Systeme. Die beiden redundanten Netzteile haben jeweils eine Leistung von 2.600 W, und wir werden sehen, warum wir so viel Leistung benötigen. Er beherbergt sechs AMD Instinct-GPUs und die dualen Epyc . Sehen Sie sich das technische Niveau an, das Supermicro in das Design dieses Servers Supermicro .

H12 2U 2-Knoten Multi-GPU

Multi-Node-Design für Rechen- und GPU-Beschleunigungsdichte

NEC treibt KI mit fortschrittlichen GPU-Systemen von Supermicro voran

NEC nutzt Supermicro mit NVIDIA® A100 für den Bau eines Supercomputers für KI (auf Japanisch)

Supermicro : KI -Learning-Server mit hoher Dichte

Unser neuestes Rechenzentrumssystem bietet die höchste Dichte an fortschrittlichen NVIDIA Ampere-GPUs mit schneller GPU-GPU-Verbindung und Intel® Xeon® Scalable-Prozessoren der 3. In diesem TECHTalk zeigen wir, wie wir unvergleichliche KI in einem 4U-Rack-Höhenpaket ermöglichen.

Hybrid-2U2N-GPU-Workstation-Server-Plattform Supermicro Hands-on

Heute beenden wir unsere neueste Serie mit einem Blick auf das Supermicro , ein 2U-System mit 2 Knoten und 6 GPUs, das Patrick kürzlich in Supermicro ausprobieren konnte.

Supermicro ein NVIDIA Redstone 2U-Server

Heute schauen wir uns das Supermicro an, das Patrick kürzlich im Supermicro ausprobieren konnte.

Vorstellung des bahnbrechenden GPU-Systemdesigns – Supermicro TECHTalk mit IDC

Präsentiert von Josh Grossman, Principal Product Manager, Supermicro Peter Rutten, Research Director, Infrastructure Systems, IDC

Mission Critical Server-Lösungen

Maximierung der KI und -Bereitstellung mit virtualisierten NVIDIA A100-GPUs

Supermicro mit NVIDIA HGX A100 bieten eine Reihe flexibler Lösungen zur Unterstützung von NVIDIA Virtual Compute Server (vCS) und NVIDIA A100-GPUs, KI und die Bereitstellung kleiner und großer KI ermöglichen.

Supermicro : 2U-Server mit 2 Knoten

Die bahnbrechende Multi-Node-GPU/CPU-Plattform Supermicro ist mit keinem anderen Produkt auf dem Markt vergleichbar. Mit unserem fortschrittlichen Building Block Solutions®-Design und der ressourcenschonenden Architektur nutzt dieses System die modernsten CPU- und GPU-Engines sowie fortschrittliche Speicher mit hoher Dichte in einem platzsparenden Formfaktor und bietet so eine unvergleichliche Energieeffizienz und Flexibilität.

SuperMinute: 4U-System mit HGX A100 8-GPU

Für die anspruchsvollsten KI Supermicro die leistungsstärksten und schnellsten Server auf Basis von NVIDIA A100™ Tensor Core-GPUs. Mit der neuesten Version der NVIDIA® NVLink™- und NVIDIA NVSwitch™-Technologien können diese Server in einem einzigen 4U-System KI von bis zu 5 PetaFLOPS liefern.

SuperMinute: 2U-System mit HGX A100 4-GPU

Der neue AS -2124GQ-NART Server bietet die Leistung der NVIDIA A100 Tensor Core GPUs und des HGX A100 4-GPU Baseboards. Das System unterstützt PCI-E Gen 4 für schnelle CPU-GPU-Verbindungen und Hochgeschwindigkeits-Netzwerkerweiterungskarten.