Ihre NVIDIA Blackwell-Reise beginnt hier

In dieser transformativen Phase der KI, in der die sich weiterentwickelnden Skalierungsgesetze die Grenzen der Rechenzentrumskapazitäten immer weiter verschieben, bieten unsere neuesten NVIDIA Blackwell-basierten Lösungen, die in enger Zusammenarbeit mit NVIDIA entwickelt wurden, beispiellose Rechenleistung, Dichte und Effizienz mit einer luft- und flüssigkeitsgekühlten Architektur der nächsten Generation. Mit unseren sofort einsetzbaren KI Supermicro Ihr erster Ansprechpartner für den Einstieg in die Welt von NVIDIA Blackwell und bietet Ihnen nachhaltige, hochmoderne Lösungen, die KI beschleunigen.

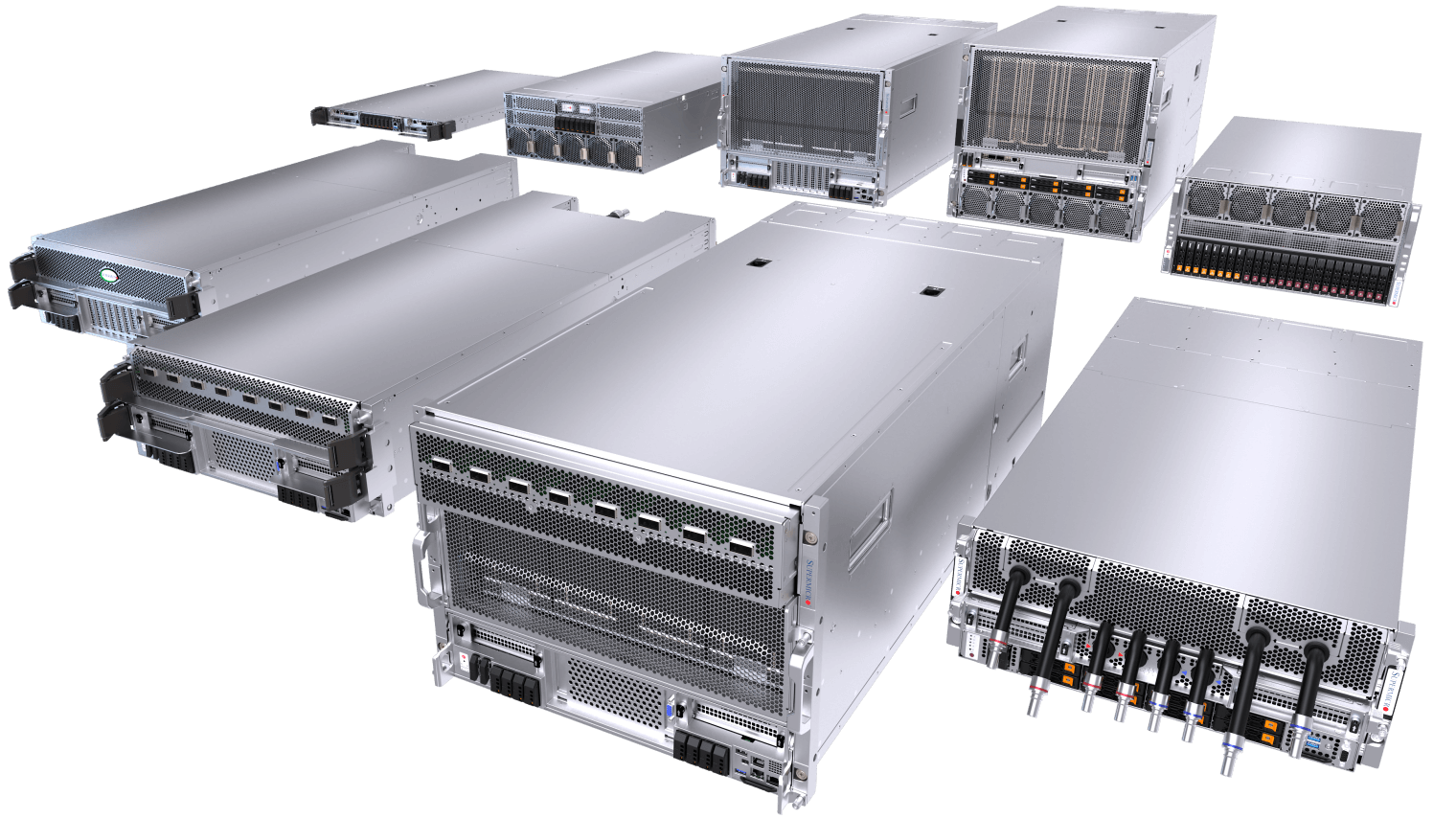

End-to-End KI Data Center Building Block Solutions Vorteil

Eine breite Palette von luft- und flüssigkeitsgekühlten Systemen mit mehreren CPU-Optionen, eine vollständige Software-Suite für die Verwaltung von Rechenzentren, schlüsselfertige Integration auf Rack-Ebene mit vollständiger Vernetzung, Verkabelung und L12-Validierung auf Clusterebene, weltweite Lieferung, Support und Service.

- Umfassende Erfahrung

- Die KI -Bausteinlösungen Supermicrobilden die Grundlage für das weltweit größte flüssigkeitsgekühlte KI .

- Flexible Angebote

- Luft- oder flüssigkeitsgekühlt, GPU-optimiert, mehrere System- und Rack-Formfaktoren, CPUs, Speicher, Netzwerkoptionen. Optimierbar für Ihre Bedürfnisse.

- Pionier der Flüssigkeitskühlung

- Bewährte, skalierbare und Plug-and-Play-Flüssigkeitskühlungslösungen zur Unterstützung der KI . Speziell für die NVIDIA Blackwell Architektur entwickelt.

- Schnelle Zeit bis zum Onlinegang

- Beschleunigte Bereitstellung mit globaler Kapazität, erstklassiger Bereitstellungsexpertise und One-Site-Services, um Ihre KI schnell in Produktion zu bringen.

Die kompakteste Hyperscale KI

NVIDIA HGX™ B300-System, optimiert für OCP ORV3-Design mit bis zu 144 GPUs in einem Rack

Das flüssigkeitsgekühlte NVIDIA HGX B300-System Supermicromit 2 HE bietet eine unübertroffene GPU-Dichte für Hyperscale-Bereitstellungen. Jeder kompakte 8-GPU-Knoten entspricht der OCP ORV3-Spezifikation mit fortschrittlicher DLC-2-Technologie und passt in 21-Zoll-Racks, sodass bis zu 18 Knoten und insgesamt 144 GPUs pro Rack möglich sind. Mit Blind-Mate-Verbindungen und einer modularen GPU/CPU-Tray-Architektur unterstützt das System jede B300-GPU mit einer TDP von bis zu 1.100 W und reduziert gleichzeitig den Platzbedarf im Rack, den Stromverbrauch und die Kühlkosten erheblich. Ideal für KI maximale Leistungsdichte bei außergewöhnlicher Wartungsfreundlichkeit benötigen.

288 GB HBM3e pro GPU

2-OU Flüssigkeitsgekühltes System

für NVIDIA HGX B300 8-GPU

Bis zu 144 NVIDIA Blackwell Ultra in einem standardisierten ORV3-Rack

Ultra Performance für KI Reasoning

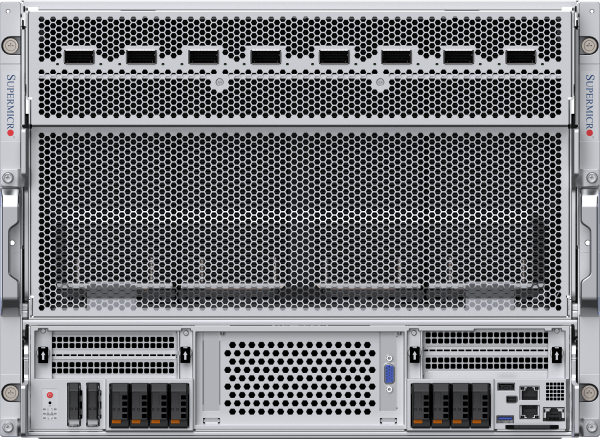

Die fortschrittlichste luft- und flüssigkeitsgekühlte Architektur für NVIDIA HGX™ B300

Die Supermicro HGX-Plattform versorgt viele der weltweit größten KI mit Rechenleistung für KI transformativen KI von heute. Das luftgekühlte 8U-System mit NVIDIA Blackwell Ultra maximiert die Leistung von acht 1100-W-HGX-B300-GPUs mit insgesamt 2,3 TB HBM3e-Speicher. Acht frontseitige OSFP-Ports mit integrierten ConnectX®-8 SuperNICs mit 800 Gb/s ermöglichen die schlüsselfertige Bereitstellung von NVIDIA Quantum-X800 InfiniBand- oder Spectrum-X™ Ethernet-Clustern. Das flüssigkeitsgekühlte 4U-System verfügt über DLC-2-Technologie mit 98 % Wärmeabfuhr und erzielt damit 40 % Energieeinsparungen im Rechenzentrum. Supermicro Center Building Block Solutions® (DCBBS) und das Know-how bei der Bereitstellung vor Ort bieten Komplettlösungen für Flüssigkeitskühlung, Netzwerktopologie und Verkabelung, Stromversorgung und Wärmemanagement, um die Zeit bis zur Inbetriebnahme KI zu verkürzen.

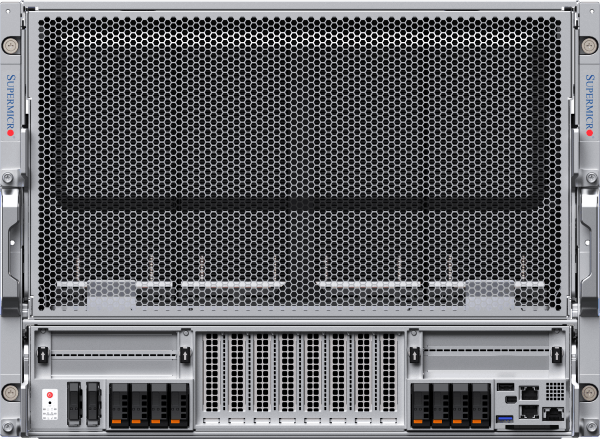

4U flüssigkeitsgekühltes oder 8U luftgekühltes System

für NVIDIA HGX B300 8-GPU

Front-I/O-Flüssigkeitskühlsystem mit integriertem NVIDIA ConnectX-8 -Netzwerk mit 800 Gb/s

Luftgekühltes Front-I/O-System für NVIDIA Blackwell Ultra HGX B300 8-GPU mit integriertem NVIDIA ConnectX-8-Netzwerk

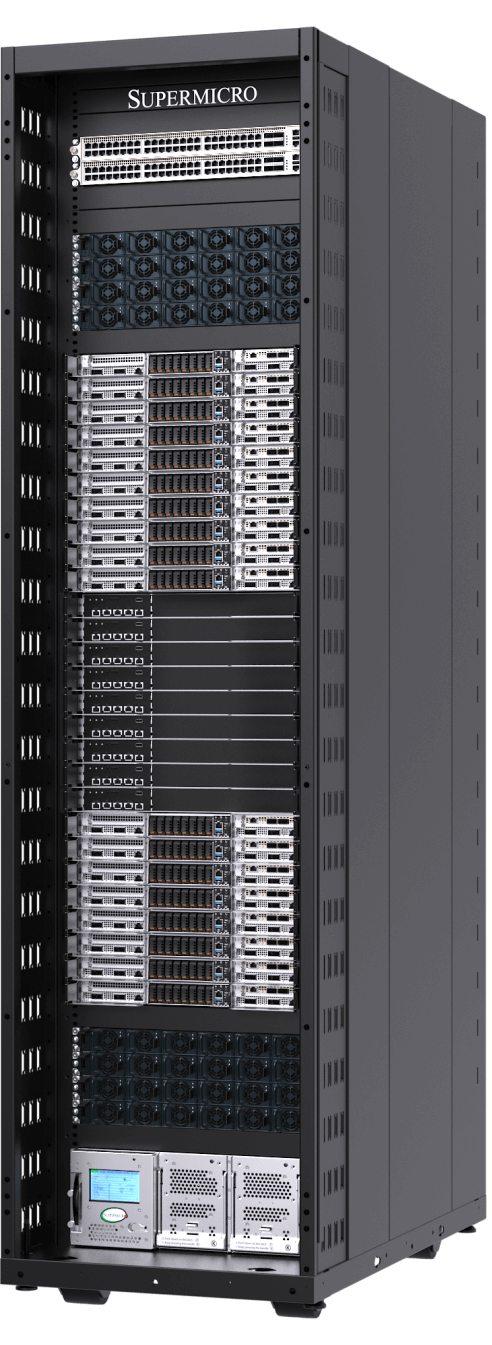

Eine Exascale-Rechenleistung in einem Rack

End-to-End-Flüssigkeitskühlungslösung für NVIDIA GB300 NVL72

Der Supermicro GB300 NVL72 bewältigt KI vom Training grundlegender Modelle bis hin zu groß angelegten Schlussfolgerungen. Er kombiniert hohe KI mit der direkten Flüssigkeitskühlungstechnologie Supermicro und ermöglicht so maximale Rechendichte und Effizienz. Basierend auf NVIDIA Blackwell Ultra integriert ein einzelnes Rack 72 NVIDIA B300-GPUs mit jeweils 288 GB HBM3e-Speicher. Mit 1,8 TB/s NVLink-Verbindungen arbeitet der GB300 NVL72 als Exascale-Supercomputer in einem einzigen Knoten. Die verbesserte Netzwerktechnologie verdoppelt die Leistung über die gesamte Rechnerstruktur und unterstützt Geschwindigkeiten von 800 Gb/s. Die Fertigungskapazitäten und End-to-End-Services Supermicro beschleunigen die Bereitstellung von flüssigkeitsgekühlten KI und verkürzen die Markteinführungszeit für GB300 NVL72-Cluster.

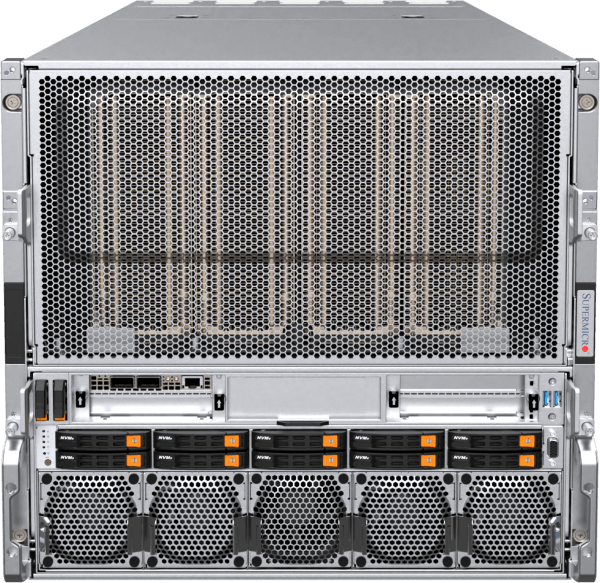

NVIDIA GB300 NVL72 und GB200 NVL72

für NVIDIA GB300/GB200 Grace™ Blackwell Superchip

72 NVIDIA Blackwell Ultra in einer NVIDIA NVLink-Domäne. Jetzt mit Ultra und Skalierbarkeit

72 NVIDIA Blackwell-GPUs in einer NVIDIA NVLink-Domäne. Die Spitze der KI .

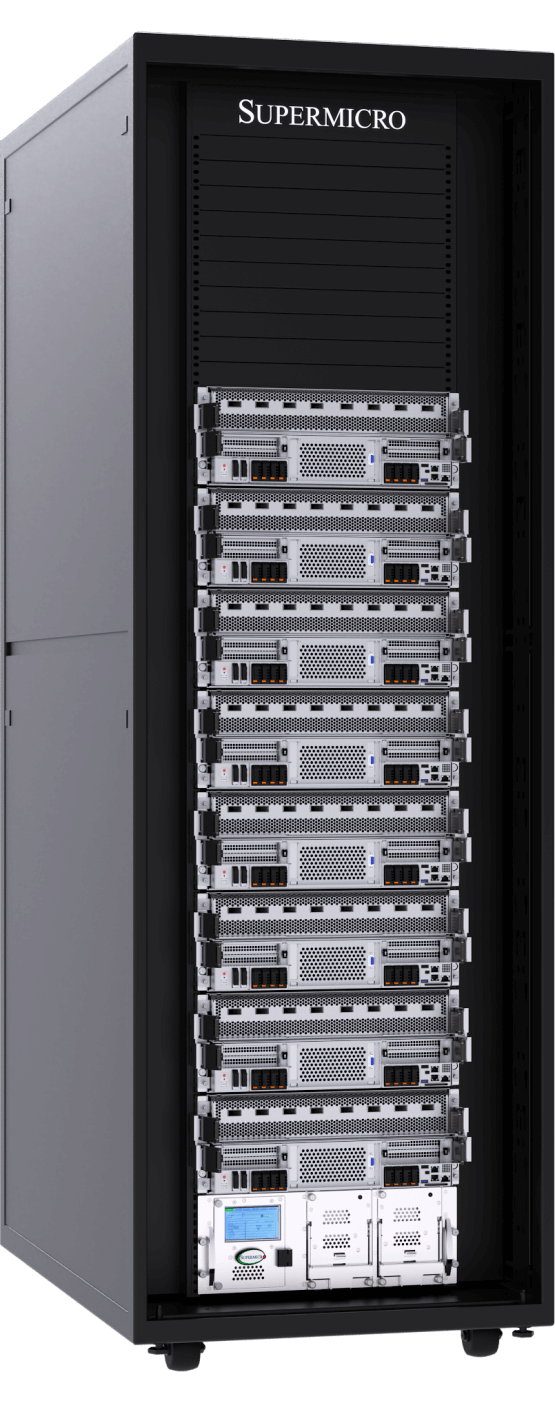

Luftgekühltes System, weiterentwickelt

Das meistverkaufte luftgekühlte System, neu gestaltet und optimiert für die NVIDIA HGX B200 8-GPU

Die neuen luftgekühlten NVIDIA HGX B200 8-GPU-Systeme zeichnen sich durch eine verbesserte Kühlarchitektur, eine hohe Konfigurierbarkeit für CPU, Speicher, Speicherplatz und Netzwerk sowie eine verbesserte Wartungsfreundlichkeit von vorne oder hinten aus. Bis zu 4 der neuen luftgekühlten 8U/10U-Systeme können in einem Rack installiert und vollständig integriert werden, wodurch die gleiche Dichte wie bei der Vorgängergeneration erreicht wird und gleichzeitig eine bis zu 15-fache Inferenz- und 3-fache Trainingsleistung erzielt wird. Alle Supermicro HGX B200-Systeme sind mit einem 1:1-Verhältnis von GPU zu NIC ausgestattet und unterstützen NVIDIA BlueField®-3 oder NVIDIA ConnectX®-7 für die Skalierung über eine Hochleistungs-Computing-Struktur.

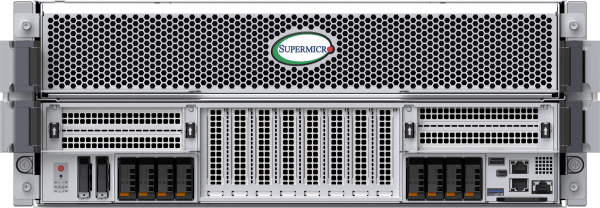

8U Front I/O oder 10U Rear I/O Luftgekühltes System

für NVIDIA HGX B200 8-GPU

Luftgekühltes Front-I/O-System mit erweiterter Flexibilität bei der Konfiguration des Systemspeichers und Wartungsfreundlichkeit in kalten Gängen

Luftgekühlte Rear-I/O-Konstruktion für das Training großer Sprachmodelle und Inferenzen mit hohem Volumen

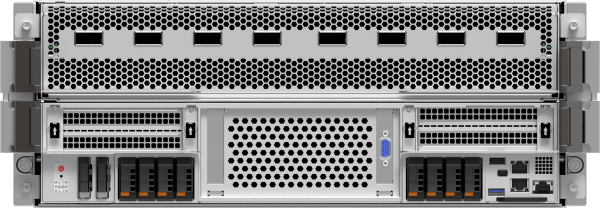

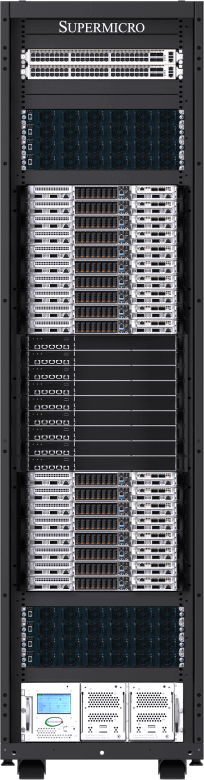

Flüssigkeitsgekühltes System der nächsten Generation

Bis zu 96 NVIDIA HGX™ B200 Grafikprozessoren in einem einzigen Rack mit maximaler Skalierbarkeit und Effizienz

Das neue frontseitige, flüssigkeitsgekühlte 4U NVIDIA HGX B200 8-GPU-System verfügt über die DLC-2-Technologie Supermicro. Die direkte Flüssigkeitskühlung fängt nun bis zu 92 % der von Serverkomponenten wie CPU, GPU, PCIe-Switch, DIMM, VRM und PSU erzeugten Wärme auf und ermöglicht so bis zu 40 % Energieeinsparungen im Rechenzentrum und einen Geräuschpegel von nur 50 dB. Die neue Architektur verbessert die Effizienz und Wartungsfreundlichkeit des Vorgängers, der für NVIDIA HGX H100/H200 8-GPU-Systeme entwickelt wurde, noch weiter. Das Rack-Scale-Design mit den neuen vertikalen Kühlmittelverteilern (CDM) ist in Konfigurationen mit 42U, 48U oder 52U erhältlich und sorgt dafür, dass horizontale Verteiler keine wertvollen Rack-Einheiten mehr belegen. Dadurch können 8 Systeme mit 64 NVIDIA Blackwell-GPUs in einem 42U-Rack und bis zu 12 Systeme mit 96 NVIDIA-GPUs in einem 52U-Rack untergebracht werden.

4U Front I/O oder Rear I/O Flüssigkeitsgekühltes System

für NVIDIA HGX B200 8-GPU

Flüssigkeitsgekühltes Front-I/O DLC-2-System mit bis zu 40 % Energieeinsparung im Rechenzentrum und einem Geräuschpegel von nur 50 dB

Flüssigkeitsgekühltes Rear-I/O-System für maximale Rechendichte und Leistung

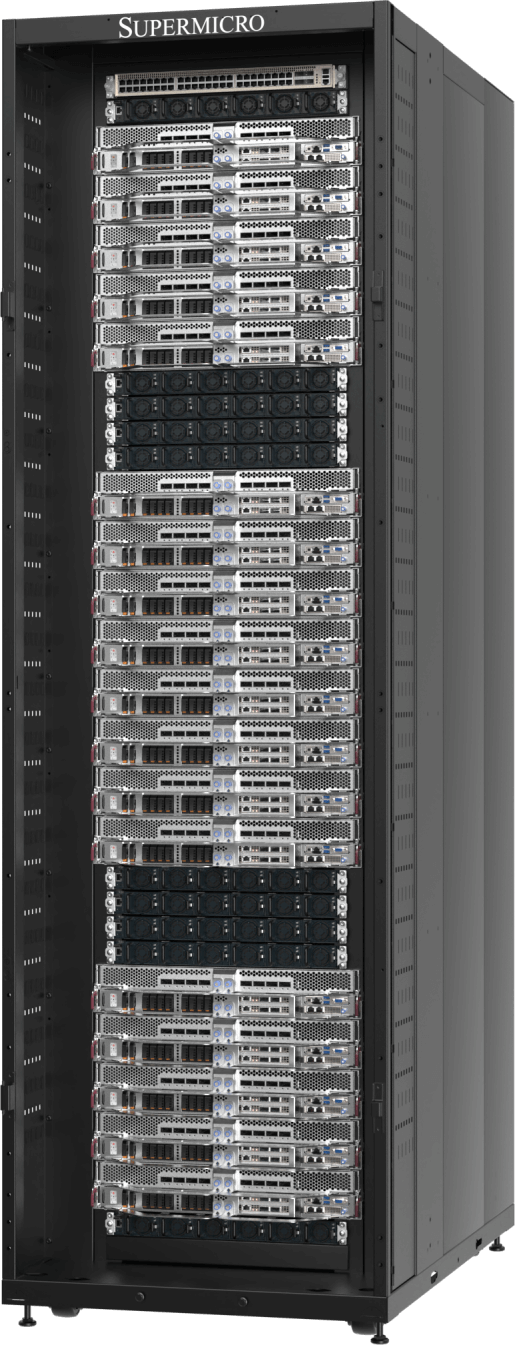

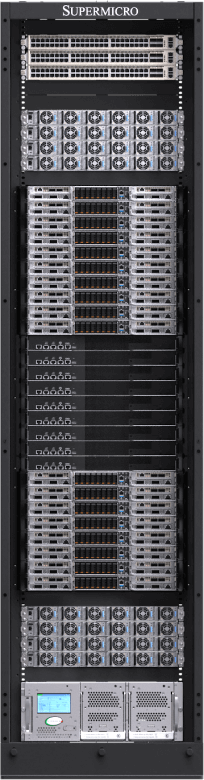

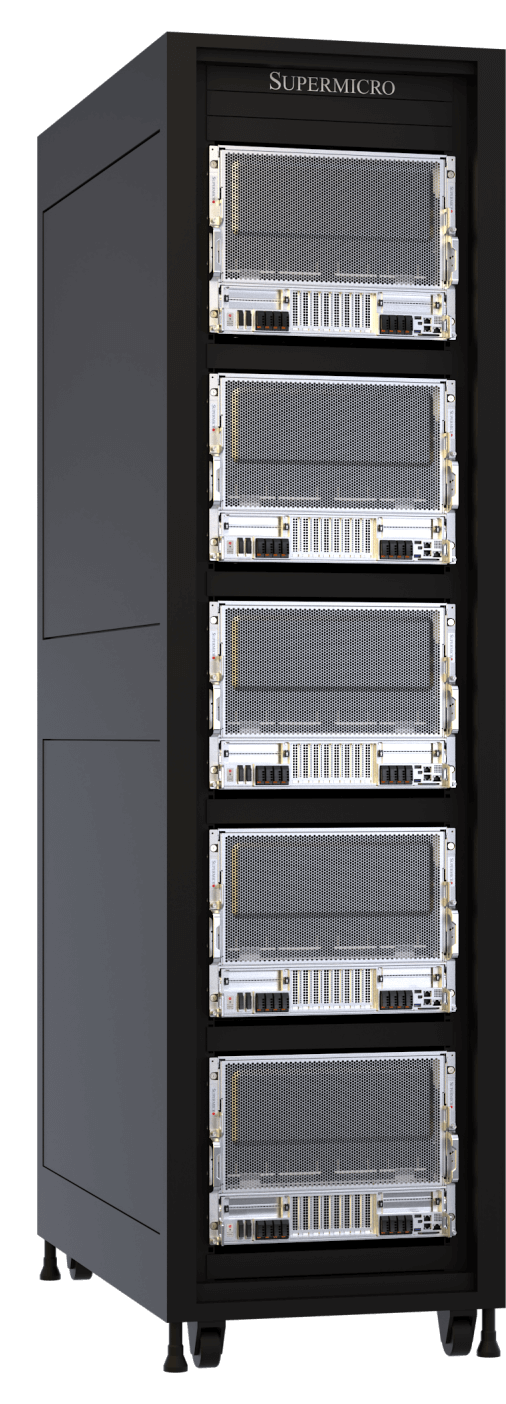

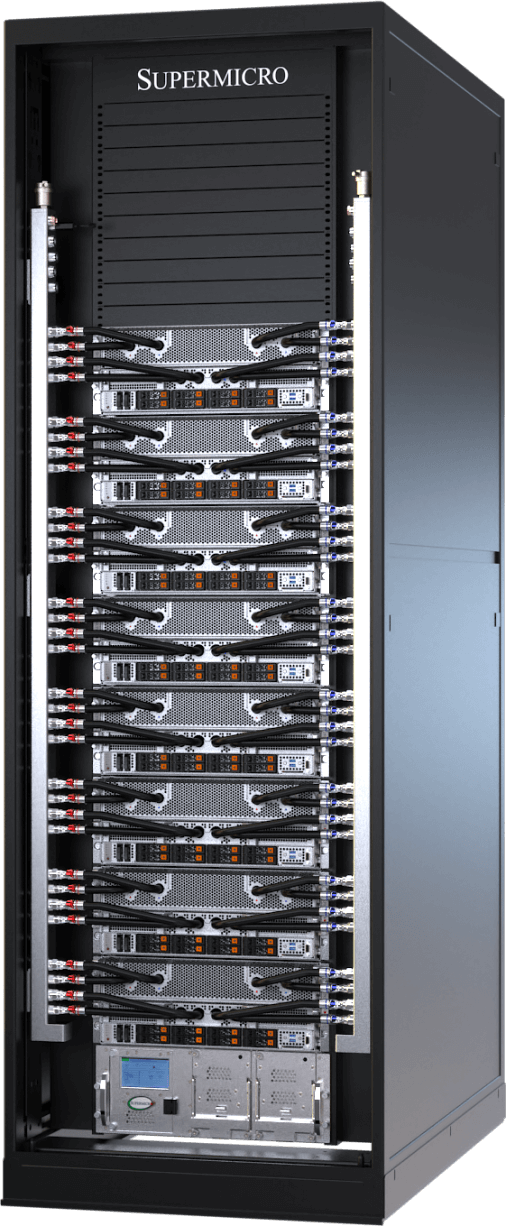

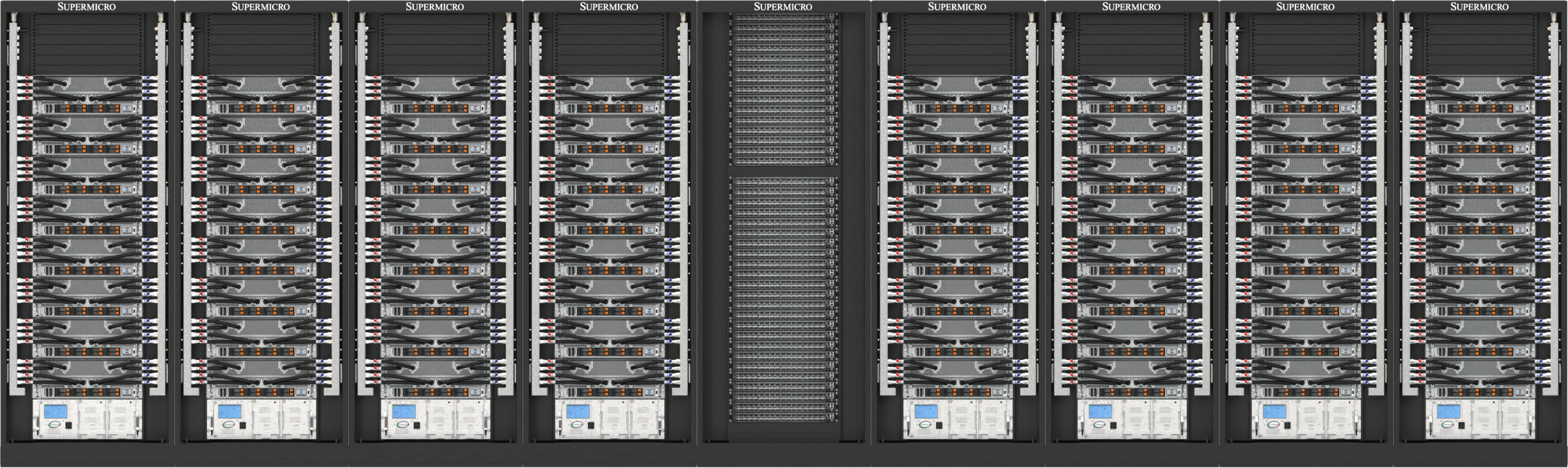

Skalierbare Plug-and-Play-Einheit für NVIDIA Blackwell sofort einsatzbereit

Die neuen SuperCluster-Designs sind in 42U-, 48U- oder 52U-Rack-Konfigurationen für luftgekühlte oder flüssigkeitsgekühlte Rechenzentren erhältlich und integrieren NVIDIA Quantum InfiniBand- oder NVIDIA Spectrum™-Netzwerke in einem zentralisierten Rack. Die flüssigkeitsgekühlten SuperCluster ermöglichen eine nicht blockierende, skalierbare Einheit mit 256 GPUs in fünf 42U/48U-Racks oder eine erweiterte skalierbare Einheit mit 768 GPUs in neun 52U-Racks für modernste KI . Supermicro bietet Supermicro eine In-Row-CDU-Option für große Bereitstellungen sowie eine Rack-Lösung zur Flüssigkeits-Luft-Kühlung, für die kein Wasser aus der Anlage erforderlich ist. Das luftgekühlte SuperCluster-Design folgt der bewährten, branchenführenden Architektur der Vorgängergeneration und bietet eine skalierbare Einheit mit 256 GPUs in neun 48U-Racks.

End-to-End Data Center Building Block Solution und Bereitstellungsservices für NVIDIA Blackwell

Supermicro ein umfassender One-Stop-Lösungsanbieter mit globaler Fertigungskapazität, der Lösungen auf Rechenzentrumsniveau, Flüssigkeitskühlungstechnologien, Switching, Verkabelung, eine vollständige Software-Suite für das Rechenzentrumsmanagement, L11- und L12-Lösungsvalidierung, Installation vor Ort sowie professionellen Support und Service anbietet. Mit Produktionsstätten in San Jose, Europa und Asien Supermicro eine unübertroffene Fertigungskapazität für flüssigkeits- oder luftgekühlte Rack-Systeme und gewährleistet so eine pünktliche Lieferung, reduzierte Gesamtbetriebskosten (TCO) und gleichbleibende Qualität.

Die NVIDIA Blackwell-Lösungen Supermicrosind mit NVIDIA Quantum InfiniBand- oder NVIDIA Spectrum™-Netzwerken in einem zentralisierten Rack für optimale Infrastrukturskalierung und GPU-Clustering optimiert und ermöglichen eine nicht blockierende, skalierbare Einheit mit 256 GPUs in fünf Racks oder eine erweiterte, skalierbare Einheit mit 768 GPUs in neun Racks. Diese Architektur mit nativer Unterstützung für NVIDIA Enterprise-Software wird mit dem Know-how Supermicrobei der Bereitstellung der weltweit größten flüssigkeitsgekühlten Rechenzentren kombiniert, um überragende Effizienz und eine unübertroffene Online-Verfügbarkeit für die anspruchsvollsten KI von heute zu bieten.

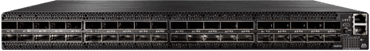

NVIDIA Quantum InfiniBand und Spectrum Ethernet

Von mainstream bis hin zu Hochleistungs-Supercomputern - die NVIDIA Quantum InfiniBand und Spectrum™ Netzwerktechnologie aktivieren das skalierbarste, schnellste und sicherste End-to-End-Netzwerk.

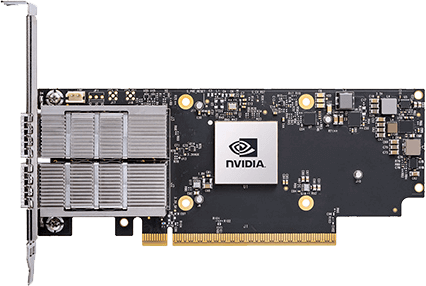

NVIDIA SuperNICs

Supermicro führend bei der Einführung von NVIDIA SuperNICs: NVIDIA ConnectX für InfiniBand und NVIDIA BlueField-3 SuperNIC für Ethernet. Alle NVIDIA HGX B200-Systeme von Supermicrosind mit einer 1:1-Vernetzung zu jeder GPU ausgestattet, um NVIDIA GPUDirect RDMA (InfiniBand) oder RoCE (Ethernet) für massiv paralleles KI zu ermöglichen.

NVIDIA KI Unternehmenssoftware

Voller Zugriff auf NVIDIA Anwendungs-Frameworks, APIs, SDKs, Toolkits und Optimierer sowie die Möglichkeit, KI , NVIDIA NIMs, RAGs und die neuesten optimierten KI einzusetzen. Die NVIDIA KI Enterprise Software rationalisiert die Entwicklung und den Einsatz produktionsreifer KI mit Sicherheit, Support und Stabilität auf Enterprise-Niveau, um einen reibungslosen Übergang vom Prototyp zur Produktion zu gewährleisten.