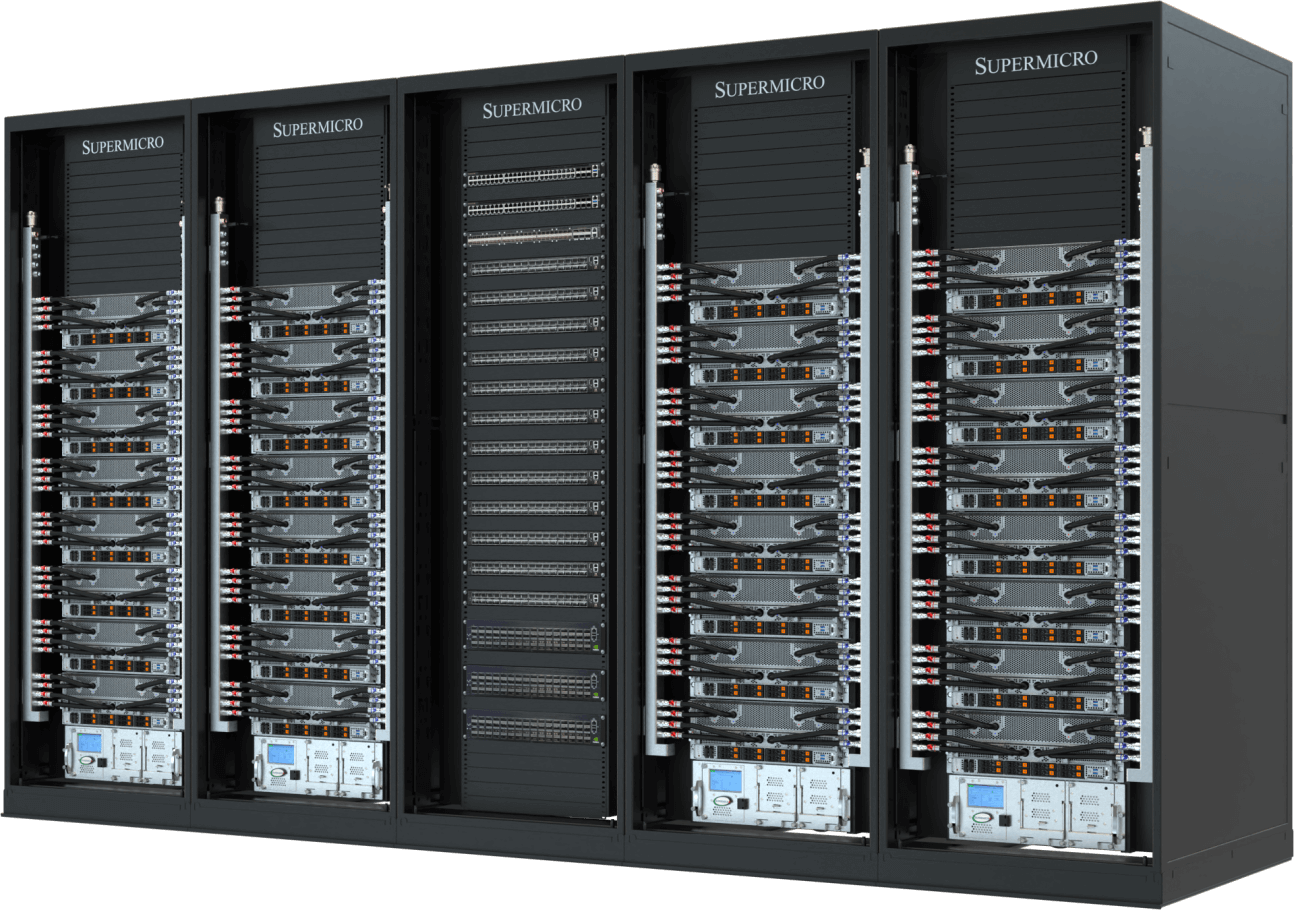

在現今的AI時代,衡量算力的單位不再僅基於伺服器的數量。經互連的GPU、CPU、記憶體、儲存,以及這些機架內多個節點的運算資源,為目前的AI技術奠定了基礎。運算基礎設施需要高速且低延遲的網路結構,以及經精密設計的冷卻技術和電力供應,以維持每個資料中心環境的最佳效能和效率。Supermicro的SuperCluster解決方案可為正快速進步的生成式AI和大型語言模型(LLM)提供端對端AI資料中心解決方案。

完善的大規模式整合

設計並製造完整的機架和叢集,全球製造產能最高可達 5,000 機架 機架/月

透過現場服務進行測試、驗證和部署

L11、L12測試程序可在出貨前針對運作效能與效率進行完整驗證

液冷 / 氣冷技術

包括GPU與CPU冷板、冷卻液分配單元與歧管的完善整合式液冷或氣冷解決方案

供應與庫存管理

一站式服務——可快速、及時提供完全整合式機架,加速交付時間,實現快速部署

Supermicro的完善一站式資料中心解決方案可加快關鍵型企業應用的交付時間,並消除叢集建置所產生的複雜性。此前,這些建置程序需要大量的設計調整和耗時的超級運算最佳化作業。

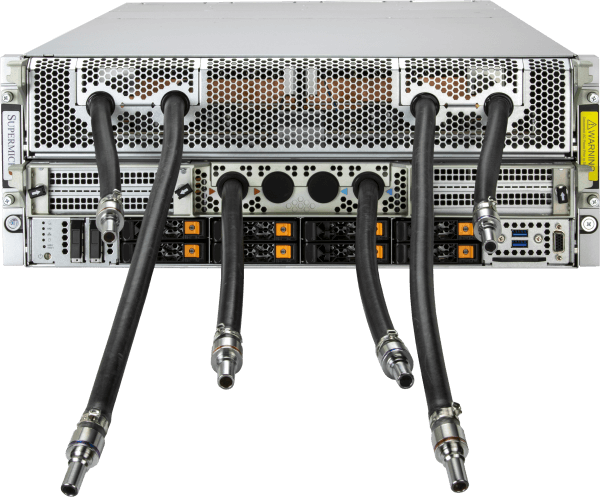

液冷式雙機箱 NVIDIA HGX B300AI

完全整合式液冷144節點叢集,配備高達1152顆NVIDIA B300 GPU

- NVIDIA HGX B300 憑藉緊湊型 2-OU 液冷系統節點,實現無可匹敵的AI 效能密度

- Supermicro 1.8MW 容量的機櫃內冷卻單元(亦提供機架內冷卻單元選項)

- 大型HBM3e GPU記憶體容量(每顆GPU配備288GB* HBM3e記憶體)及基礎模型訓練所需的系統記憶體佔用空間

- 採用 NVIDIAQuantum-X800InfiniBand 實現橫向擴展,打造ultra、高頻寬AI

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- 專為全面支援 NVIDIAAI 平台而設計,包括 NVIDIAAI 與 NVIDIA Run:ai

運算節點

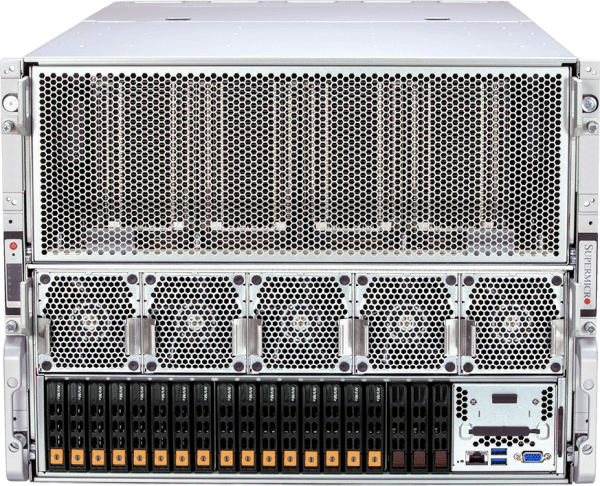

液冷式4U NVIDIA HGX B300AI

完全整合的液冷式72節點叢集,配備多達576顆NVIDIA B300 GPU

- 部署高效能AI 與推論,採用針對運算密度與可維護性優化的 NVIDIA HGX B300

- Supermicro 液冷技術專為持續高功率運作設計,並提升能源效率

- 大型HBM3e GPU記憶體容量(每顆GPU配備288GB* HBM3e記憶體)及基礎模型訓練所需的系統記憶體佔用空間

- 透過 NVIDIASpectrum™-X以太網路或 NVIDIAQuantum-X800InfiniBand 實現橫向擴展

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- 專為全面支援 NVIDIAAI 平台而設計,包括 NVIDIAAI 與 NVIDIA Run:ai

運算節點

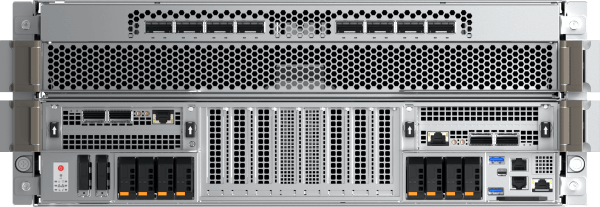

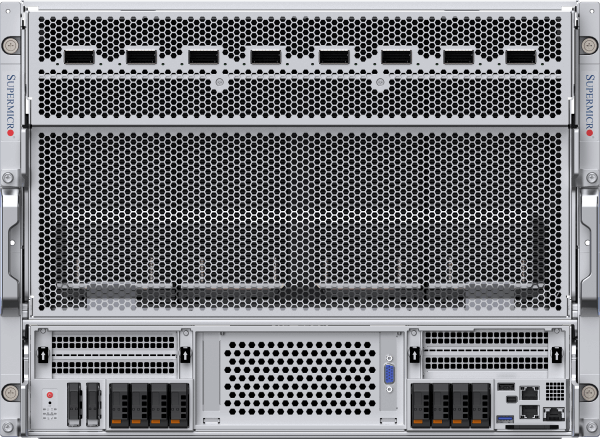

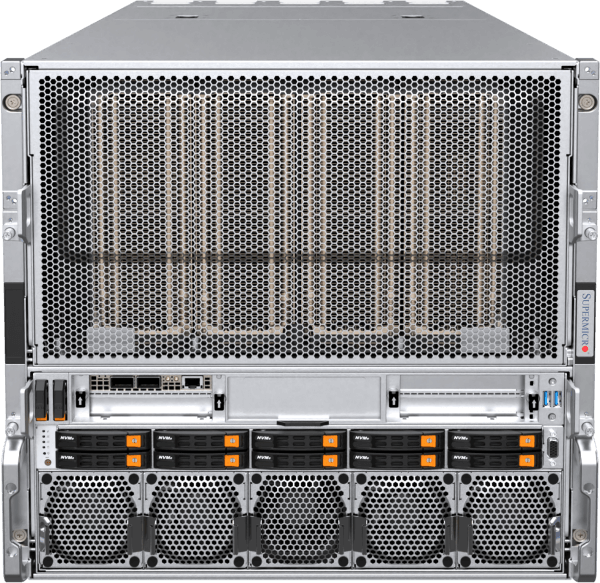

風冷式 8U NVIDIA HGX B300AI

完全整合的風冷式72節點叢集,配備多達576張NVIDIA B300 GPU

- 採用NVIDIA HGX B300實現可擴展AI 推論部署,其風冷設計可提升資料中心的廣泛相容性

- 優化的氣流與散熱設計,實現無需液冷基礎設施即可達成的高效能運作

- 大型HBM3e GPU記憶體容量(每顆GPU配備288GB* HBM3e記憶體)及基礎模型訓練所需的系統記憶體佔用空間

- 透過 NVIDIASpectrum™-X以太網路或 NVIDIAQuantum-X800InfiniBand 實現橫向擴展

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- 專為全面支援 NVIDIAAI 平台而設計,包括 NVIDIAAI 與 NVIDIA Run:ai

運算節點

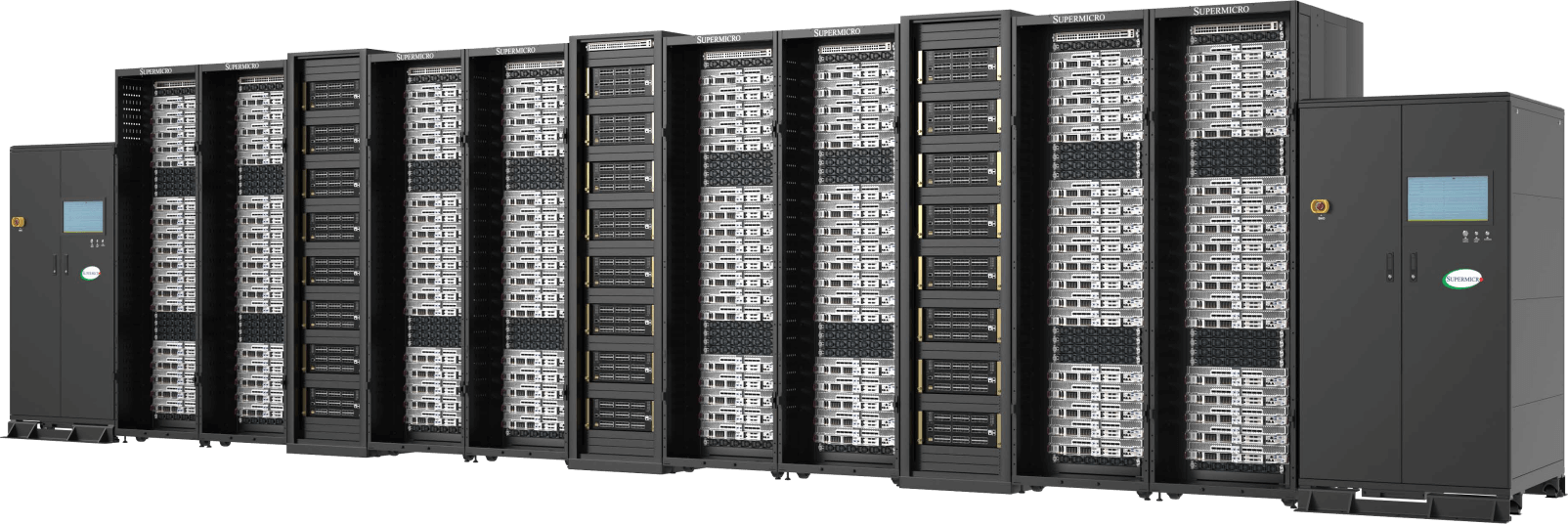

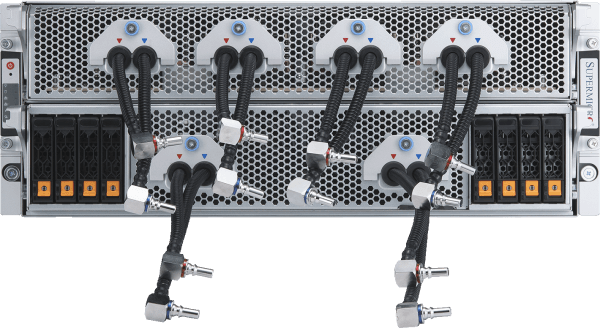

液冷式NVIDIA HGX B200AI叢集

最多可在5個機架中搭載32個NVIDIA HGX B200 8-GPU的4U液冷系統(最多256個GPU)

- 部署頂尖AI 與推論效能,單一可擴展單元(5個機架)內配備256張NVIDIA B200 GPU

- Supermicro直接液冷技術,具有可支援250kW散熱性能的機架內(In-Rack)冷卻液分配裝置(CDU),以及備援PSU和雙熱插拔幫浦

- 單一可擴充單元可支援45TB的HBM3e記憶體

- 可透過400Gb/s NVIDIASpectrum™-X乙太網路或NVIDIA Quantum-2 InfiniBand進行水平擴充

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- 專為全面支援 NVIDIAAI 平台而設計,包括 NVIDIAAI 與 NVIDIA Run:ai

運算節點

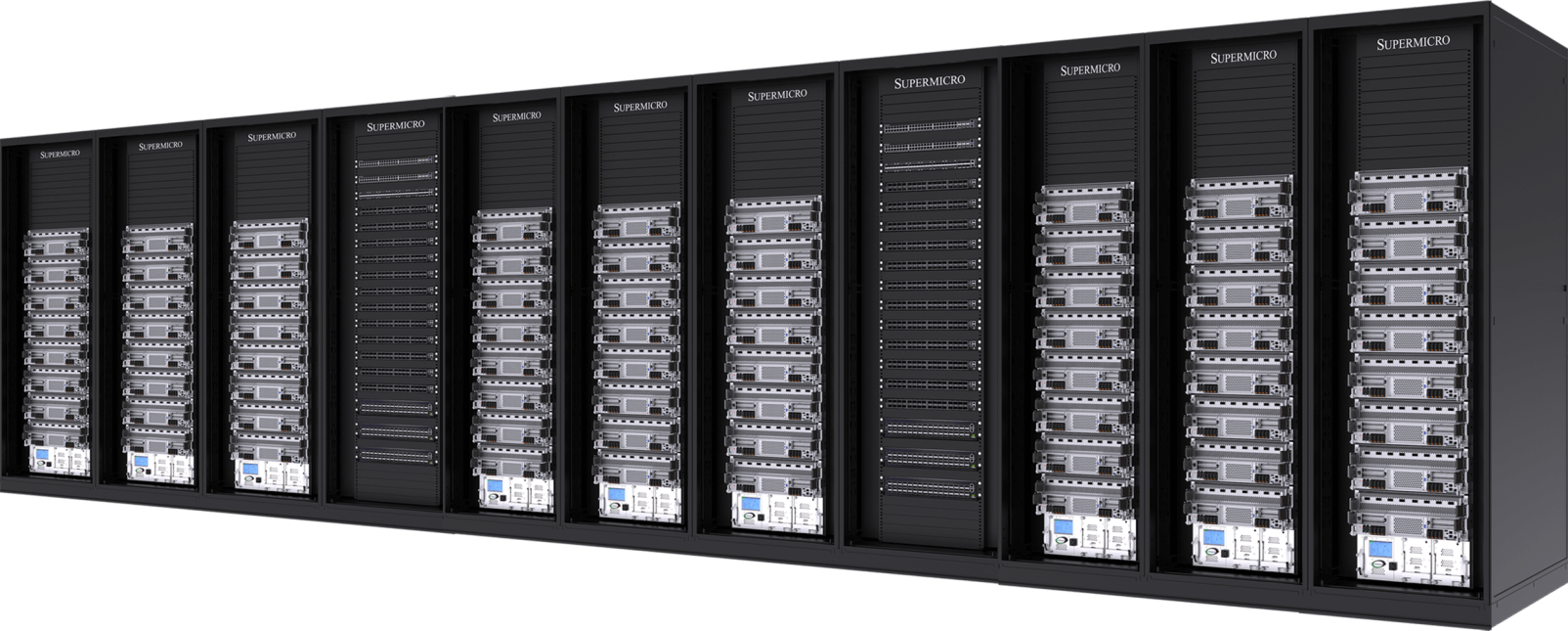

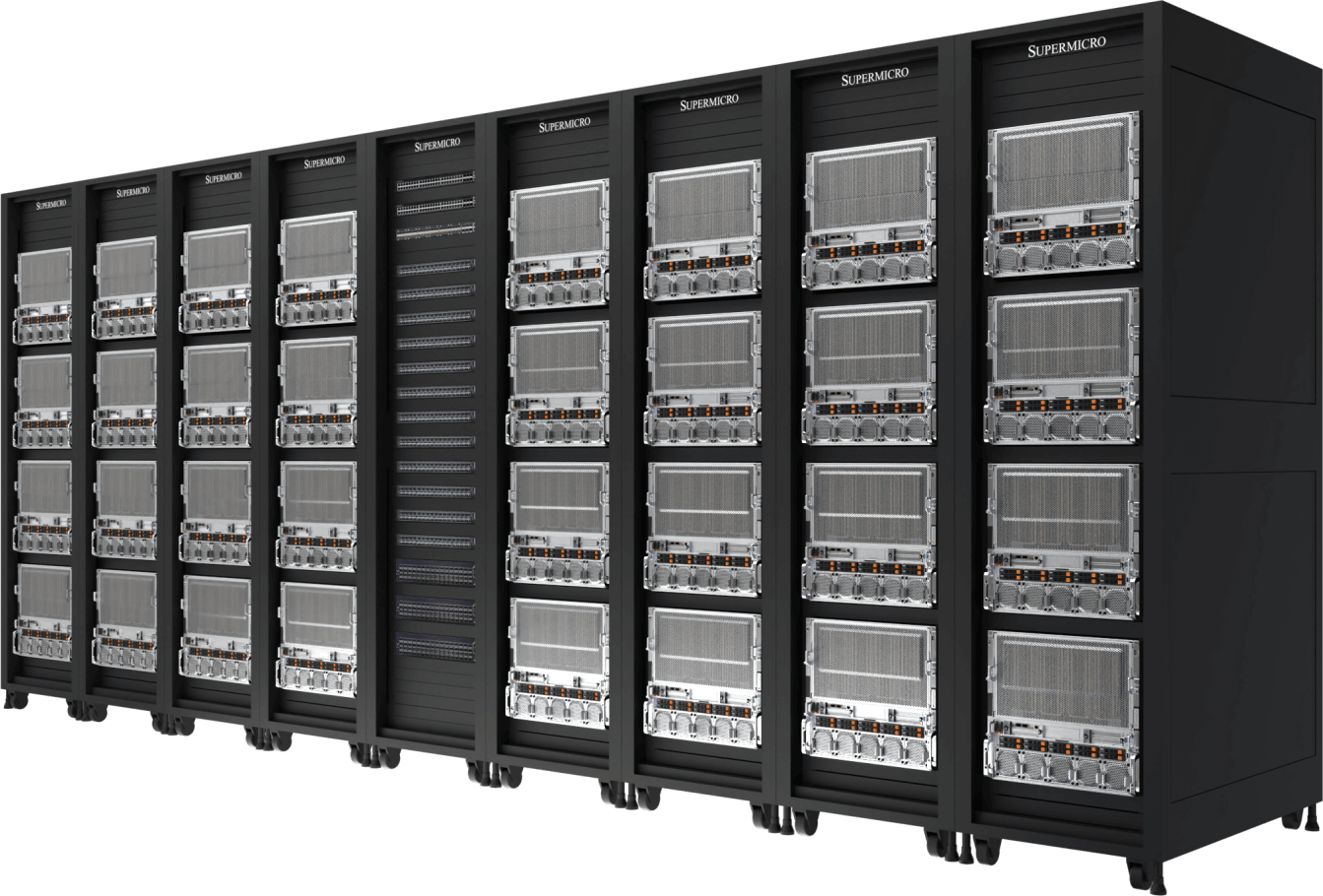

氣冷式NVIDIA HGX B200 AI叢集

可在9組機架內配置32個NVIDIA HGX B200 8-GPU 10U氣冷式系統(256個GPU)

- 經驗證的業界領先架構,可支援全新散熱最佳化氣冷系統平台

- 單一可擴充單元可支援45TB的HBM3e記憶體

- 採用 400Gb/s NVIDIASpectrum-X以太網路或 NVIDIAQuantum-2InfiniBand 實現橫向擴展

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- NVIDIA 認證系統節點,全面支援 NVIDIAAI ,包含 NVIDIAAI 與 NVIDIA Run:ai

運算節點

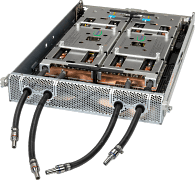

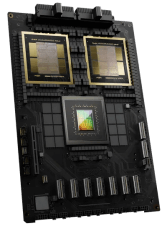

NVIDIA GB200 NVL72

單一機架內的液冷式Exascale運算系統

- 72顆 NVIDIA Blackwell B200 顯示卡整合為單一顯示單元,配備龐大的 HBM3e 記憶體池(每機架 13.5TB)

- 9x NVLink 交換器,每組運算托盤配備 4 個連接埠,可串接 72 顆 GPU,提供 1.8TB/s 的 GPU 間互連效能

- Supermicro直接液冷技術,具有可支援250kW散熱性能的機架內(In-Rack)冷卻液分配裝置(CDU),以及備援PSU和雙熱插拔幫浦

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- 採用 400Gb/s NVIDIASpectrum™-X以太網路或 NVIDIAQuantum-2InfiniBand 實現橫向擴展

- 專為全面支援 NVIDIAAI 平台而設計,包括 NVIDIAAI 與 NVIDIA Run:ai

Compute Tray

- ARS-121GL-NBO-LCC

(不單獨販賣)

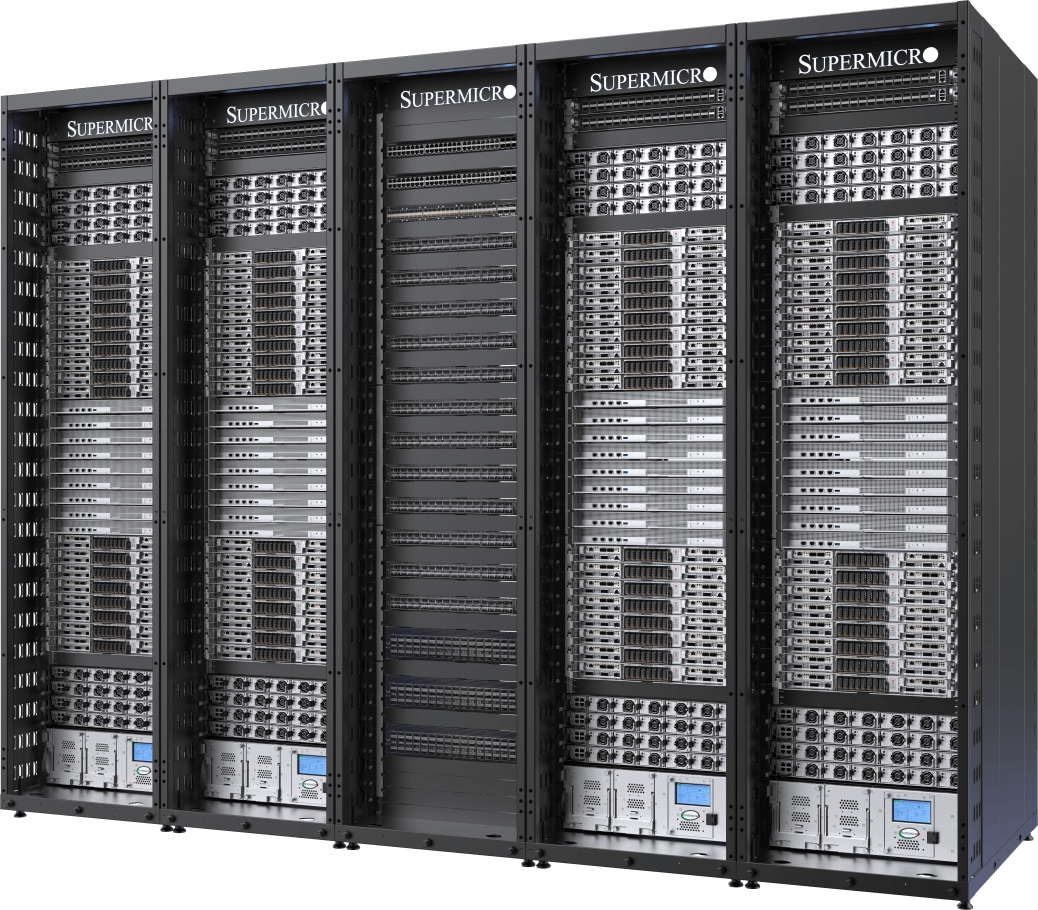

領先的液冷式AI叢集

可在5組機架內配置32個NVIDIA HGX H100/H200 8-GPU 4U液冷系統(256個GPU)

- 透過Supermicro的客製化液冷解決方案,可將資料中心運算密度提升一倍,並降低最多40%的電力成本

- 在單一可擴充式單元中支援256個NVIDIA H100/H200 GPU

- 在單一可擴充式單元中支援20TB的HBM3(H100)或36TB的HBM3e(H200)

- 具備完整 NVIDIA GPUDirect RDMA 與儲存裝置支援或 RoCE 支援的專用儲存架構選項

- 採用 400Gb/s NVIDIASpectrum™-X以太網路或 NVIDIAQuantum-2InfiniBand 實現橫向擴展

- NVIDIA 認證系統節點,全面支援 NVIDIAAI ,包含 NVIDIAAI 與 NVIDIA Run:ai

運算節點

經認證的設計

可在9個機架中搭載32個NVIDIA HGX H100/H200 8-GPU 8U氣冷式系統(256個GPU)

- 經認證的業界領先架構,適用於大規模AI基礎設施部署

- 在單一可擴充式單元中支援256個NVIDIA H100/H200 GPU

- 在單一可擴充式單元中支援20TB的HBM3(H100)或36TB的HBM3e(H200)

- 採用 400Gb/s NVIDIASpectrum™-X以太網路或 NVIDIAQuantum-2InfiniBand 實現橫向擴展

- 可客製化的AI資料管道儲存結構,提供業界領先的平行式檔案系統配置

- NVIDIA 認證系統節點,全面支援 NVIDIAAI ,包含 NVIDIAAI 與 NVIDIA Run:ai

運算節點