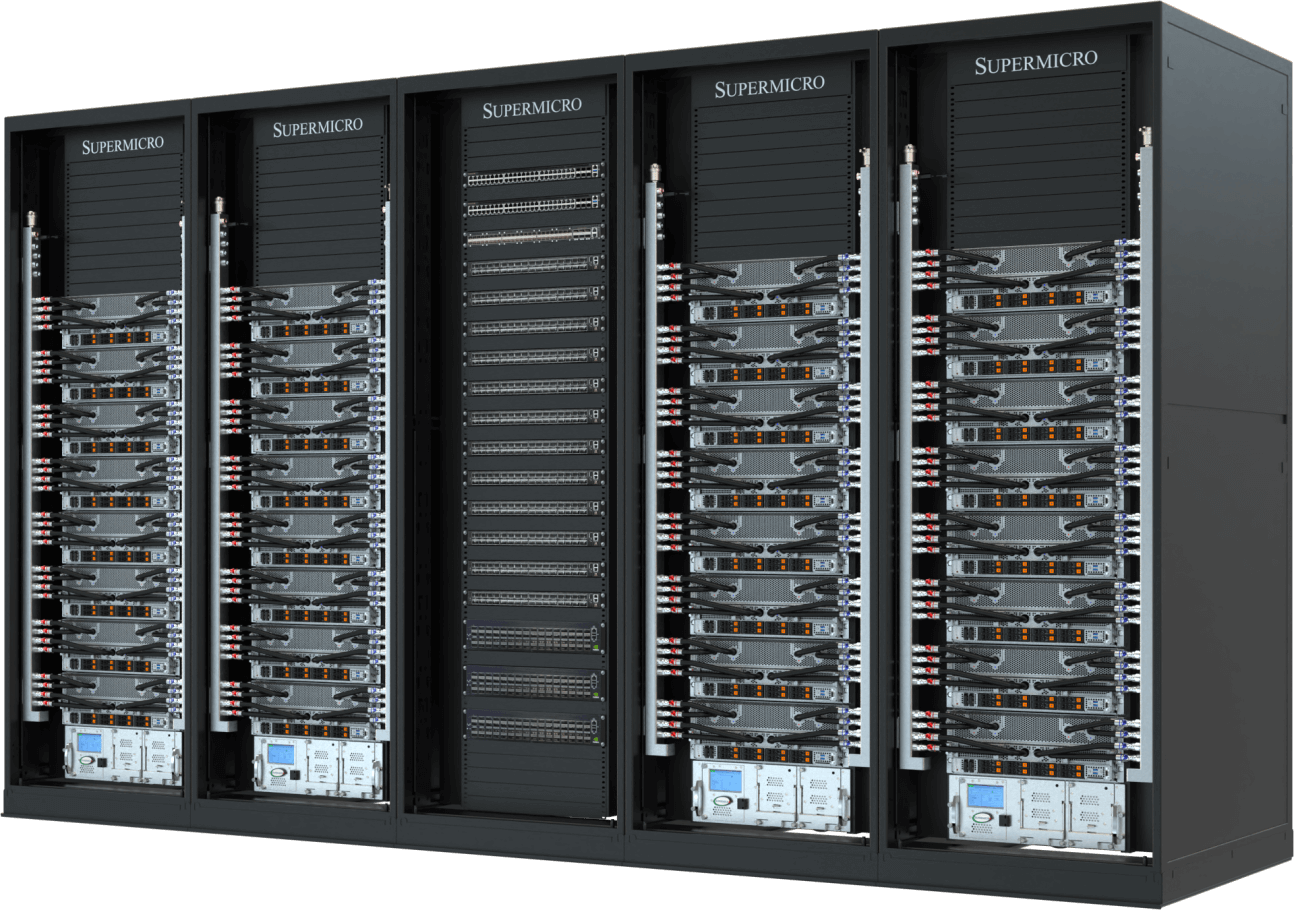

在人工智能时代,计算单元的衡量标准已不再仅限于服务器数量。互联的GPU、CPU、内存、存储设备,以及机架中多个节点间的资源协同构筑了当今的人工智能体系。 该基础设施需要高速低延迟的网络架构,以及精心设计的散热技术和供电方案,以确保每个数据中心环境都能保持最佳性能和效率。Supermicro解决方案为快速发展的生成式人工智能和大型语言模型(LLMs)提供了端到端的AI数据中心解决方案。

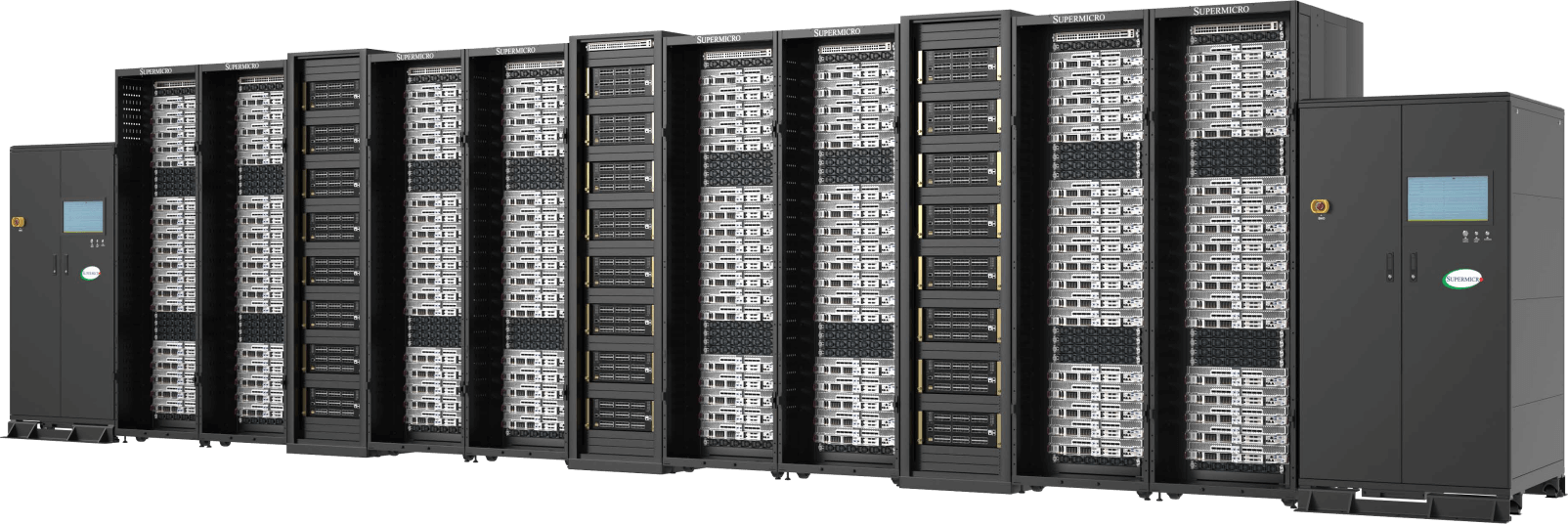

大规模完全集成

设计和建造全机架和集群,全球生产能力达 5,000 机架 每月

通过现场服务进行测试、验证和部署

经过验证的 L11、L12 测试流程可在发货前彻底验证运行效果和效率

液体冷却/空气冷却

完全集成的液冷或风冷解决方案,包括 GPU 和 CPU 冷板、冷却分配器和歧管

供应和库存管理

一站式服务,快速、及时地提供完全集成的机架,缩短解决问题的时间,实现快速部署

全套交钥匙数据中心解决方案加快了关键任务企业用例的交付时间,并消除了构建大型集群的复杂性,而以前只有通过密集的设计调整和耗时的超级计算优化才能实现这一目标。

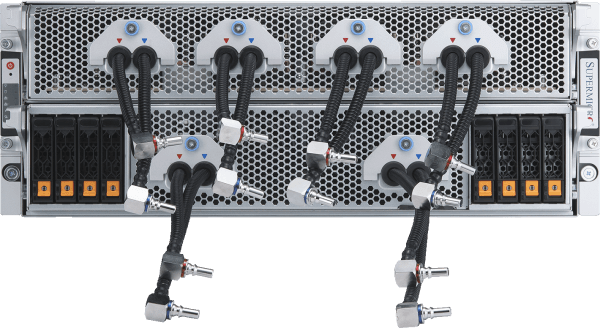

液冷式双机箱NVIDIA HGX B300人工智能集群

完全集成的液冷144节点集群,配备多达1152块NVIDIA B300 GPU

- NVIDIA HGX B300凭借紧凑型2-OU液冷系统节点,实现无与伦比的人工智能训练性能密度

- Supermicro .8MW容量的机架内CDU(亦可选配机柜内CDU)

- 大型HBM3e GPU内存容量(每块GPU配备288GB* HBM3e内存)及基础模型训练所需的系统内存占用空间

- 采用NVIDIAQuantum-X800InfiniBand实现横向扩展,构建ultra、高带宽的人工智能架构

- 专用存储结构选项,全面支持NVIDIA GPUDirect RDMA与存储或RoCE技术

- 专为全面支持NVIDIA人工智能软件平台而设计,包括NVIDIA AI Enterprise和NVIDIA Run:ai。

计算节点

液冷式4U NVIDIA HGX B300人工智能集群

完全集成的液冷72节点集群,配备多达576块NVIDIA B300 GPU

- 部署高性能AI训练与推理,采用NVIDIA HGX B300,专为计算密度与可维护性优化设计

- Supermicro 专为持续高功率运行设计,并提升能源效率

- 大型HBM3e GPU内存容量(每块GPU配备288GB* HBM3e内存)及基础模型训练所需的系统内存占用空间

- 通过 NVIDIASpectrum™-X以太网或 NVIDIAQuantum-X800InfiniBand 实现横向扩展

- 专用存储结构选项,全面支持NVIDIA GPUDirect RDMA与存储或RoCE技术

- 专为全面支持NVIDIA人工智能软件平台而设计,包括NVIDIA AI Enterprise和NVIDIA Run:ai。

计算节点

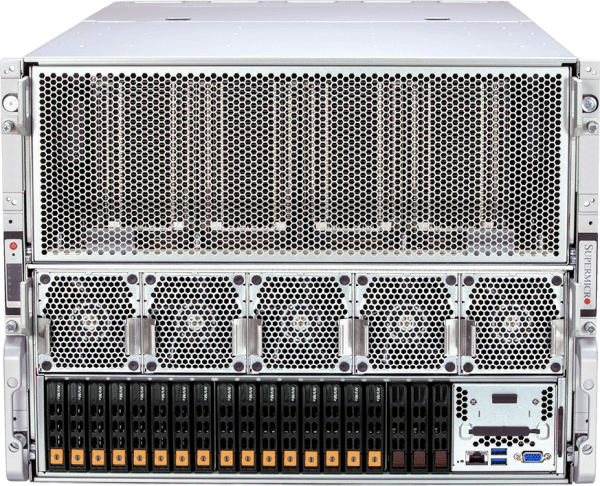

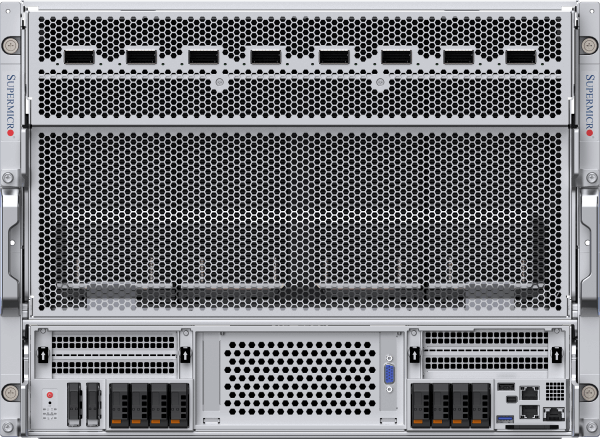

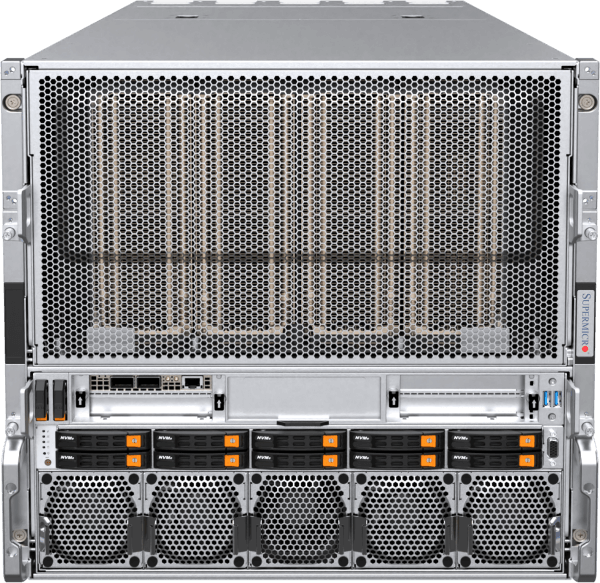

风冷式8U NVIDIA HGX B300人工智能集群

完全集成的风冷式72节点集群,配备多达576块NVIDIA B300 GPU

- 采用NVIDIA HGX B300在风冷设计中部署可扩展的人工智能训练与推理,实现更广泛的数据中心兼容性

- 优化气流与散热设计,无需液冷基础设施即可实现高性能运行

- 大型HBM3e GPU内存容量(每块GPU配备288GB* HBM3e内存)及基础模型训练所需的系统内存占用空间

- 通过 NVIDIASpectrum™-X以太网或 NVIDIAQuantum-X800InfiniBand 实现横向扩展

- 专用存储结构选项,全面支持NVIDIA GPUDirect RDMA与存储或RoCE技术

- 专为全面支持NVIDIA人工智能软件平台而设计,包括NVIDIA AI Enterprise和NVIDIA Run:ai。

计算节点

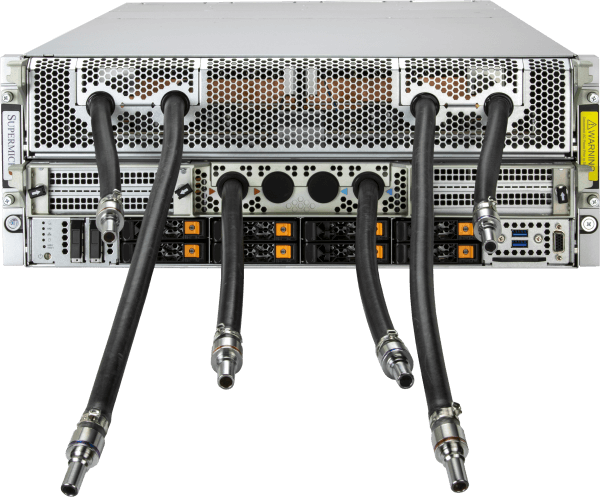

水冷式英伟达 HGX B200AI 集群

在5 个机架中最多可配备 32 个英伟达 HGX B200 8GPU 4U 液冷系统(256 个 GPU

- 部署256块NVIDIA B200 GPU的可扩展单元(5个机架),实现人工智能训练与推理性能的巅峰表现

- Supermicro 系统配备250kW机架式冷却液分配单元(CDU),含冗余电源及双热插拔水泵

- 一个可扩展单元中包含 45 TB HBM3e 内存

- 利用 400Gb/s NVIDIASpectrum™-X以太网或 NVIDIA Quantum-2 InfiniBand 进行扩展

- 专用存储结构选项,全面支持NVIDIA GPUDirect RDMA与存储或RoCE技术

- 专为全面支持NVIDIA人工智能软件平台而设计,包括NVIDIA AI Enterprise和NVIDIA Run:ai。

计算节点

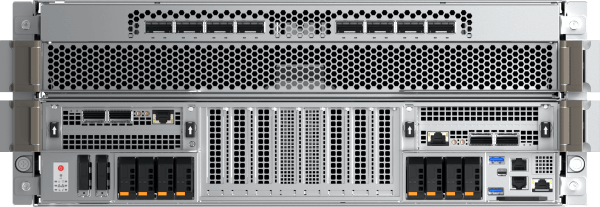

风冷式英伟达 HGX B200 AI 集群

在9 个机架中配备 32 个 NVIDIA HGX B200 8GPU 10U 风冷系统(256 个 GPU

- 经过验证的行业领先架构,采用全新热优化风冷系统平台

- 一个可扩展单元中包含 45 TB HBM3e 内存

- 通过400Gb/s NVIDIASpectrum-X以太网或NVIDIAQuantum-2InfiniBand实现横向扩展

- 专用存储结构选项,全面支持NVIDIA GPUDirect RDMA与存储或RoCE技术

- NVIDIA认证系统节点,全面支持NVIDIA人工智能软件平台,包括NVIDIA AI Enterprise和NVIDIA Run:ai

计算节点

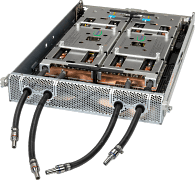

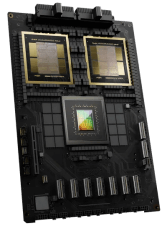

NVIDIA GB200 NVL72

单机架水冷式超大规模计算机

- 72块NVIDIA Blackwell B200 GPU以单GPU模式协同工作,配备海量HBM3e内存池(每机架13.5TB)

- 9x NVLink交换机,每个计算托盘配备4个端口,连接72个GPU,提供1.8TB/s的GPU间互连带宽。

- Supermicro 系统配备250kW机架式冷却液分配单元(CDU),含冗余电源及双热插拔水泵

- 专用存储结构选项,全面支持NVIDIA GPUDirect RDMA与存储或RoCE技术

- 通过400Gb/s NVIDIASpectrum™-X以太网或NVIDIAQuantum-2InfiniBand实现横向扩展

- 专为全面支持NVIDIA人工智能软件平台而设计,包括NVIDIA AI Enterprise和NVIDIA Run:ai。

计算托盘

- ARS-121GL-NBO-LCC

(不单独出售)

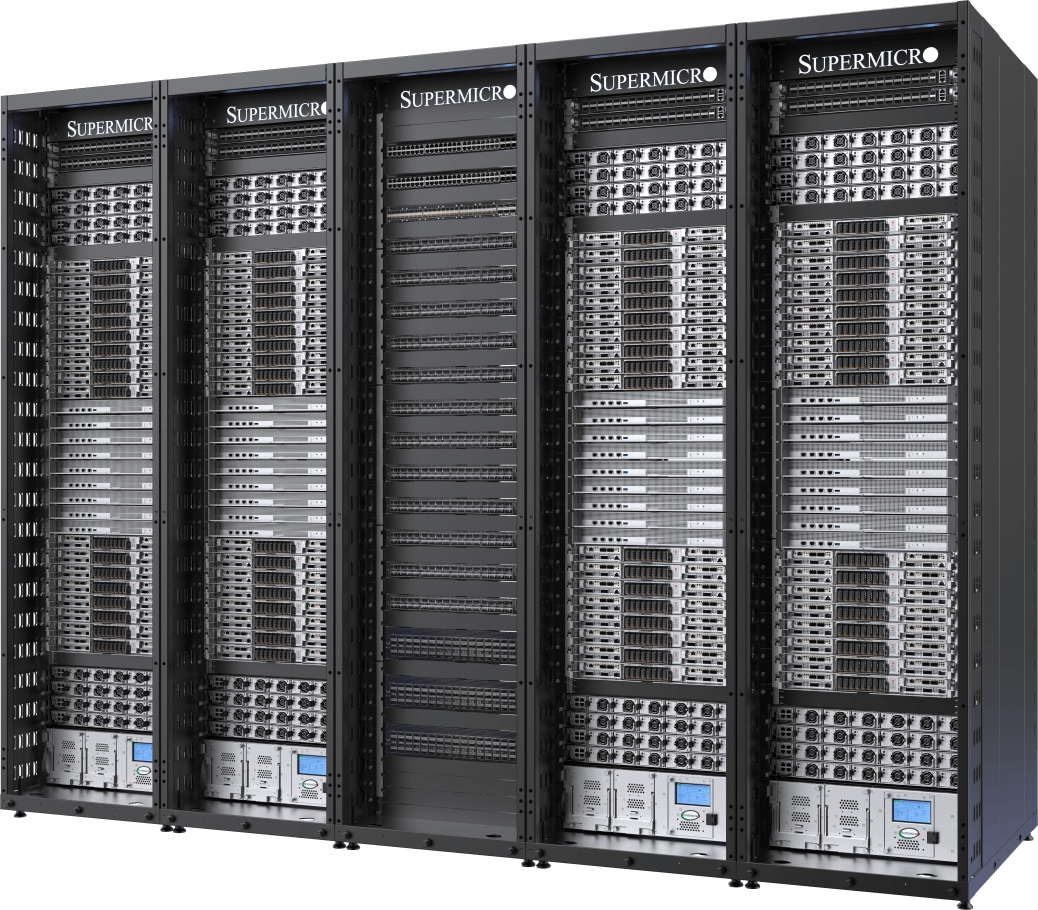

领先的液冷人工智能集群

在5 个机架中配备 32 个 NVIDIA HGX H100/H200 8GPU 4U 液冷系统(256 个 GPU

- 通过Supermicro定制液冷解决方案实现计算密度翻倍,数据中心电费成本最高可降低40%

- 一个可扩展单元中包含 256 个 NVIDIA H100/H200 GPU

- 20TB HBM3(配备 H100)或 36TB HBM3e(配备 H200)可在一个可扩展设备中进行扩展

- 专用存储结构选项,全面支持NVIDIA GPUDirect RDMA与存储或RoCE技术

- 通过400Gb/s NVIDIASpectrum™-X以太网或NVIDIAQuantum-2InfiniBand实现横向扩展

- NVIDIA认证系统节点,全面支持NVIDIA人工智能软件平台,包括NVIDIA AI Enterprise和NVIDIA Run:ai

计算节点

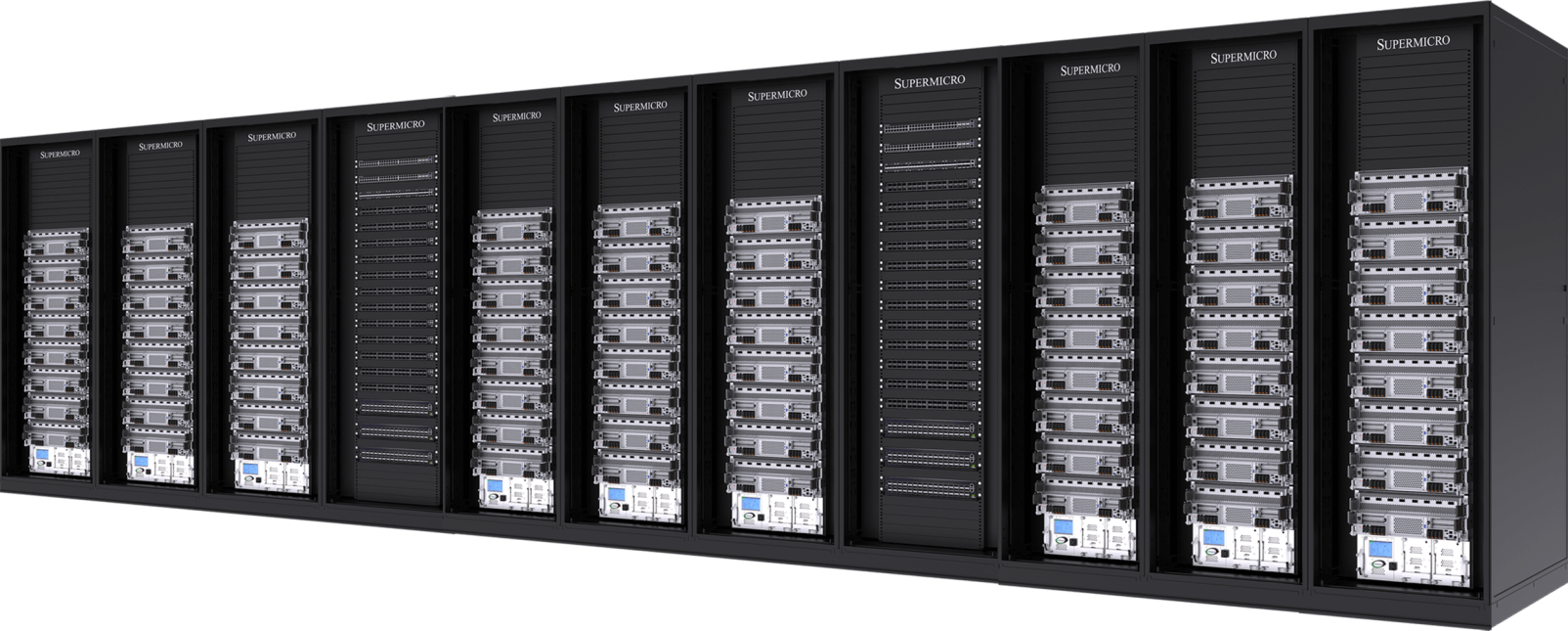

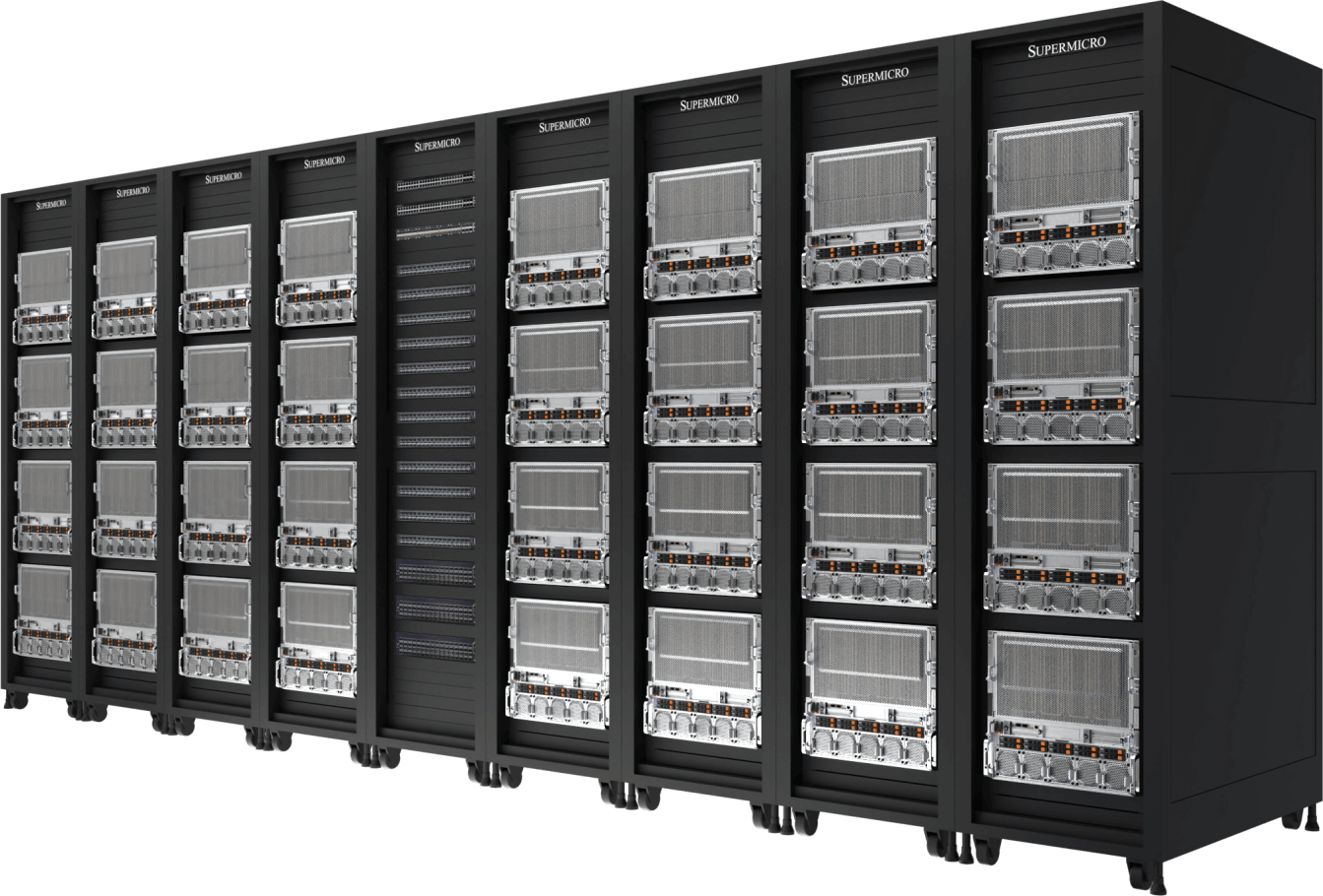

成熟的设计

配备 32 个英伟达 HGX H100/H200 8GPU 8U 风冷系统(256 个 GPU),共9 个机架

- 经过验证的行业领先架构,适用于大规模人工智能基础设施部署

- 一个可扩展单元中包含 256 个 NVIDIA H100/H200 GPU

- 20TB HBM3(配备 H100)或 36TB HBM3e(配备 H200)可在一个可扩展设备中进行扩展

- 通过400Gb/s NVIDIASpectrum™-X以太网或NVIDIAQuantum-2InfiniBand实现横向扩展

- 可定制的人工智能数据管道存储结构,提供业界领先的并行文件系统选项

- NVIDIA认证系统节点,全面支持NVIDIA人工智能软件平台,包括NVIDIA AI Enterprise和NVIDIA Run:ai

计算节点