NVIDIA GB300 NVL72

Liquid Cooled Rack-Scale Solution with 72 NVIDIA B300 GPUs and 36 Grace CPUs

- GPU: 72 NVIDIA B300 GPUs via NVIDIA Grace Blackwell Superchips

- CPU: 36 NVIDIA Grace CPUs via NVIDIA Grace Blackwell Superchips

- Memory: Up to 21 TB HBM3e (GPU Memory), Up to 17 TB LPDDR5X (System Memory)

- Drives: up to 144 E1.S PCIe 5.0 drive bays

Universal GPU Systems

Modular Building Block Design, Future Proof Open-Standards Based Platform in 4U, 5U, 8U, or 10U for Large Scale AI training and HPC Applications

- GPU: NVIDIA HGX H100/H200/B200/B300, AMD Instinct MI350 Series/MI325X/MI300X/MI250 OAM Accelerator, Intel Data Center GPU Max Series

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 32 DIMMs, 9TB

- Drives: Up to 24 Hot-swap E1.S, U.2 or 2.5" NVMe/SATA drives

Liquid-Cooled Universal GPU Systems

Direct-to-chip liquid-cooled systems for high-density AI infrastructure at scale.

- GPU: NVIDIA HGX H100/H200/B200

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 32 DIMMs, 9TB

- Drives: Up to 24 Hot-swap U.2 or 2.5" NVMe/SATA drives

3U/4U/5U GPU Lines with PCIe 5.0

Maximum Acceleration and Flexibility for AI, Deep Learning and HPC Applications

- GPU: Up to 10 NVIDIA H100 PCIe GPUs, or up to 10 double-width PCIe GPUs

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 32 DIMMs, 9TB or 12TB

- Drives: Up to 24 Hot-swap 2.5" SATA/SAS/NVMe

NVIDIA MGX™ Systems

Modular Building Block Platform Supporting Today's and Future GPUs, CPUs, and DPUs

- GPU: Up to 4 NVIDIA PCIe GPUs including NVIDIA RTX PRO™ 6000 Blackwell Server Edition, H200 NVL, H100 NVL, and L40S

- CPU: NVIDIA GH200 Grace Hopper™ Superchip, Grace™ CPU Superchip, or Intel® Xeon®

- Memory: Up to 960GB ingegrated LPDDR5X memory (Grace Hopper or Grace CPU Superchip) or 16 DIMMs, up to 4TB DRAM (Intel)

- Drives: Up to 8 E1.S + 4 M.2 drives

AMD APU Systems

Multi-processor system combining CPU and GPU, Designed for the Convergence of AI and HPC

- GPU: 4 AMD Instinct MI300A Accelerated Processing Unit (APU)

- CPU: AMD Instinct™ MI300A Accelerated Processing Unit (APU)

- Memory: Up to 512GB integrated HBM3 memory (4x 128GB)

- Drives: Up to 8 2.5" NVMe or Optional 24 2.5" SATA/SAS via storage add-on card + 2 M.2 drives

4U GPU Lines with PCIe 4.0

Flexible Design for AI and Graphically Intensive Workloads, Supporting Up to 10 GPUs

- GPU: NVIDIA HGX A100 8-GPU with NVLink, or up to 10 double-width PCIe GPUs

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 32 DIMMs, 8TB DRAM or 12TB DRAM + PMem

- Drives: Up to 24 Hot-swap 2.5" SATA/SAS/NVMe

2U 2-Node Multi-GPU with PCIe 4.0

Dense and Resource-saving Multi-GPU Architecture for Cloud-Scale Data Center Applications

- GPU: Up to 3 double-width PCIe GPUs per node

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 8 DIMMs, 2TB per node

- Drives: Up to 2 front hot-swap 2.5” U.2 per node

GPU Workstation

Flexible Solution for AI/Deep Learning Practitioners and High-end Graphics Professionals

- GPU: Up to 4 double-width PCIe GPUs

- CPU: Intel® Xeon®

- Memory: Up to 16 DIMMs, 6TB

- Drives: Up to 8 hot-swap 2.5” SATA/NVMe

Supermicro :与NVIDIA HGX B200共度一周

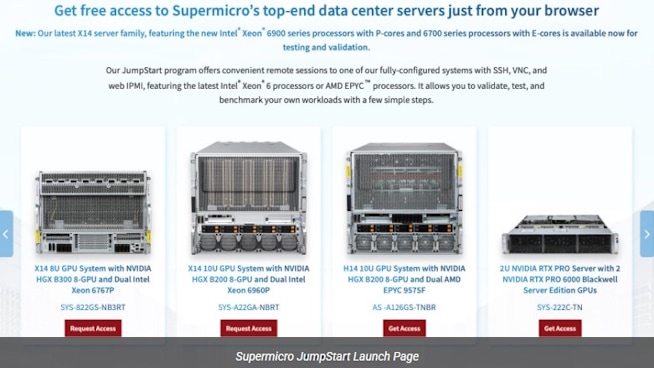

Supermicro硬件评估方面采取了截然不同的方式。它摒弃了在共享实验室环境中进行简短预设演示的做法,转而为符合条件的客户提供免费、限时、裸机访问真实生产服务器的目录权限。

基于英特尔® TDX、NVIDIA机密计算及搭载NVIDIA HGX™ B200Supermicro 的Supermicro服务器的AI工作负载安全防护:构建大规模机密AI的基础架构

本白皮书探讨了英特尔可信域扩展(TDX)与英伟达机密计算技术如何通过SupermicroHGX B200系统的解决方案,共同为新一代人工智能基础设施打造强大、安全且可扩展的平台。

樱花互联网光谷云服务加速人工智能服务

樱花互联网公司Supermicro推出全新服务,采用搭载NVIDIA HGX™ 8-GPU人工智能超级计算平台的8U SYS-821GE-TNR系统,加速生成式人工智能应用发展。

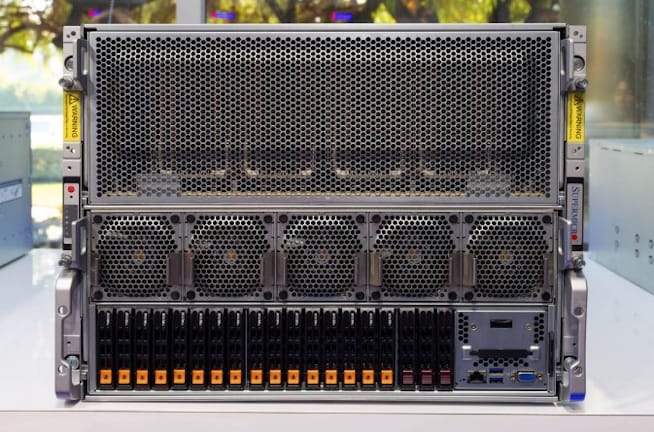

Supermicro 8路 NVIDIA H200 GPU 风冷式人工智能服务器

今天我们将继续探讨大型AI服务器,重点Supermicro 。当人们讨论SupermicroAI服务器Supermicro实力时,这款采用空气冷却技术的NVIDIA服务器正是市场上独树一帜的系统之一。

Supermicro AMD EPYC (型号:AS-4125GS-TNRT)

Supermicro 多种形态和尺寸的GPU服务器,其丰富程度远超本文能详述的范围。本次我们聚焦其相对较新的4U风冷GPU服务器,该机型支持AMD EPYC 处理器、PCIe Gen5接口,并可灵活配置八张双宽或十二张单宽的附加GPU显卡。

Supermicro 打造解决方案,加速汽车与航空航天行业的计算流体动力学仿真

搭载NVIDIA数据中心GPU的Supermicro 为计算流体动力学仿真提供显著加速,助力制造企业缩短产品上市周期

Supermicro 8路NVIDIA H100人工智能服务器深度解析

今天我们想看看这款液冷Supermicro 。Supermicro8路NVIDIA H100系统,但有个特别之处:它采用了液冷设计,能降低散热成本和功耗。既然我们手头有照片,就决定把它写成一篇专题报道。

Supermicro 提升GPU效率,助力多租户大型语言模型训练

在人工智能和机器学习的动态世界中,多租户环境中 GPU 资源的高效管理至关重要,尤其是在大型语言模型 (LLM) 训练方面。

3000WAMD Epyc 服务器拆解,来自 Level1Techs 的 Wendell 撰文

我们正在考察一款专为人工智能和机器学习优化的服务器。Supermicro 2114GT-DNR(2U2N)这款密度优化服务器,力求在有限空间内实现最大配置。其结构设计堪称精妙:仅2U机箱内便容纳了两套系统。 两组冗余电源各提供2600W功率,后续将揭示如此高功率的需求缘由。该服务器搭载AMD Instinct GPU及Epyc 。Supermicro 服务器设计中Supermicro 工程水准。

Supermicro :高密度AI训练/深度学习服务器

我们最新的数据中心系统配备了最高密度的先进英伟达安培图形处理器,以及快速的GPU-GPU互连和第3代英特尔®至强®可扩展处理器。在本 TECHTalk 中,我们将展示如何在 4U 机架高度的封装中实现无与伦比的人工智能性能。

混合型2U2N GPU工作站-服务器平台Supermicro 实机体验

今日我们将通过审视Supermicro 来结束最新系列报道——这是一款2U双节点6 GPU系统,Patrick近期在Supermicro 对其进行了实机体验。

Supermicro NVIDIA Redstone 2U服务器

今天我们将关注Supermicro 服务器,Patrick最近在Supermicro 对其进行了实机体验。

利用虚拟化英伟达™(NVIDIA®)A100 GPU最大限度地提高人工智能开发和交付能力

搭载NVIDIA HGX A100Supermicro 提供灵活的解决方案组合,支持NVIDIA虚拟计算服务器(vCS)和NVIDIA A100 GPU,助力人工智能开发与交付,实现大小型AI模型的运行。

Supermicro :2U双节点服务器

Supermicro突破性的多节点GPU/CPU平台与市面上现有产品截然不同。凭借先进的模块化解决方案®设计和资源节约型架构,该系统在节省空间的机箱内集成了最先进的CPU和GPU引擎以及先进的高密度存储,提供无与伦比的能效和灵活性。

超级一分钟:配备 HGX A100 8 图形处理器的 4U 系统

针对最严苛的人工智能工作负载Supermicro 基于NVIDIA A100™张量核心GPUSupermicro 性能最强、上市最快的服务器。凭借最新版NVIDIA® NVLink™和NVIDIA NVSwitch™技术,这些服务器可在单台4U机箱内提供高达5 PetaFLOPS的人工智能性能。

超级一分钟:配备 HGX A100 4 GPU 的 2U 系统

新型 AS -2124GQ-NART 服务器采用了英伟达™(NVIDIA®)A100 Tensor Core GPU 和 HGX A100 4-GPU 底板。系统支持 PCI-E Gen 4,可快速连接 CPU-GPU 和高速网络扩展卡。