您的 NVIDIA Blackwell 之旅从这里开始

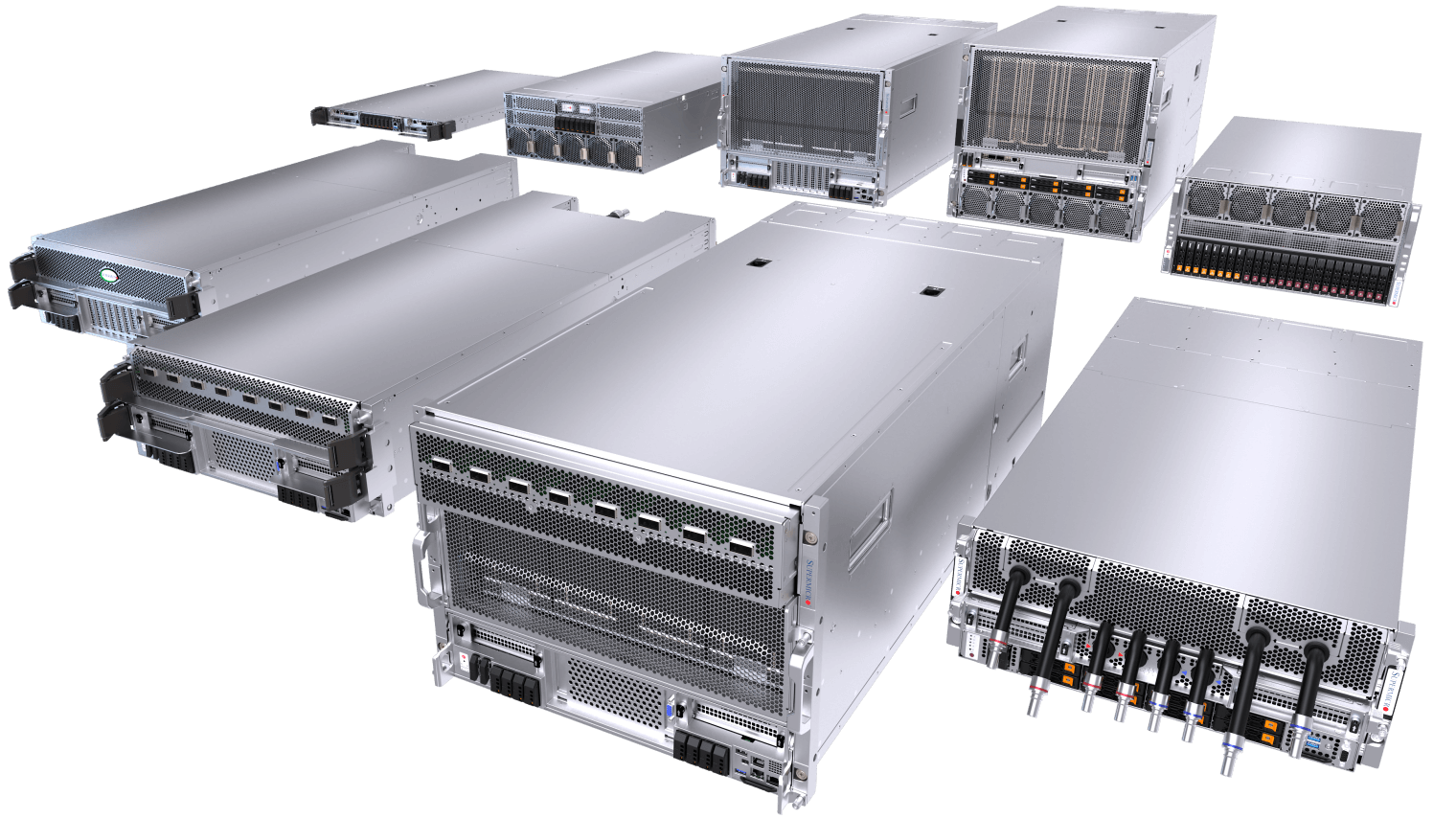

在这个人工智能变革的时代,不断演进的规模化法则持续突破数据中心能力的极限。我们与英伟达紧密合作开发的最新Blackwell架构解决方案,凭借新一代风冷与液冷架构,实现了前所未有的计算性能、密度与能效。 凭借可快速部署的AI数据中心构建模块解决方案Supermicro 您开启NVIDIA Blackwell之旅的首选合作伙伴,提供可持续的前沿解决方案,加速AI创新进程。

端到端人工智能数据中心构建模块解决方案优势

广泛的风冷和液冷系统,提供多种 CPU 选项、全套数据中心管理软件套件、交钥匙机架级集成、全套网络、布线和集群级 L12 验证、全球交付、支持和服务。

- 丰富的经验

- Supermicro数据中心构建模块解决方案,为全球规模最大的液冷人工智能数据中心部署提供动力。

- 灵活的产品

- 风冷或水冷、GPU 优化、多种系统和机架外形、CPU、存储、网络选项。可根据您的需求进行优化。

- 液体冷却先锋

- 经验证、可扩展、即插即用的液冷解决方案,助力人工智能革命。专为英伟达™(NVIDIA®)Blackwell 架构设计。

- 快速上网时间

- 利用全球能力、世界一流的部署专业知识和一站式服务加速交付,快速将您的人工智能投入生产。

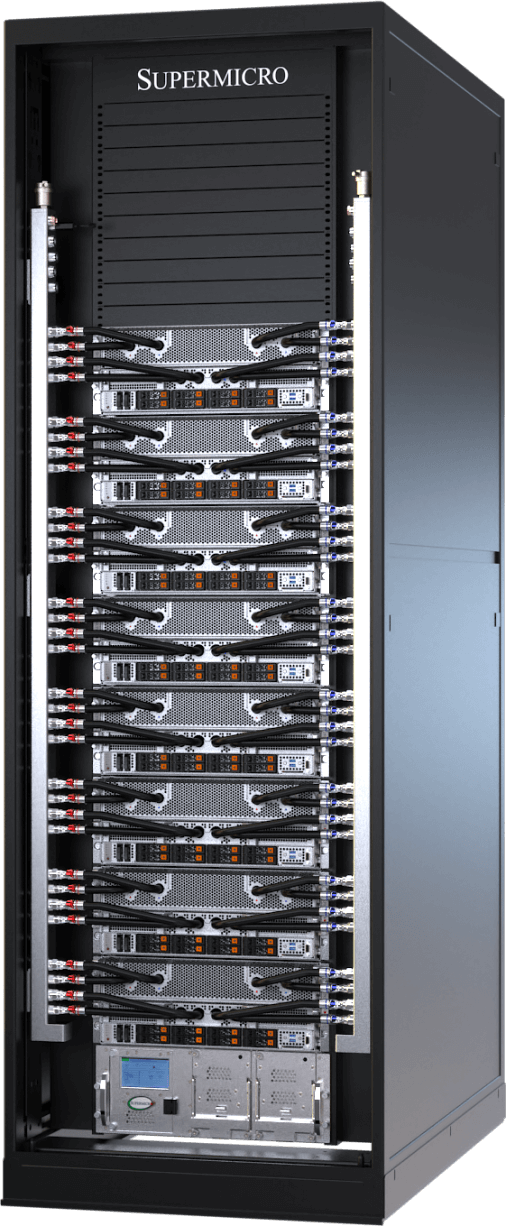

最紧凑的超大规模人工智能平台

NVIDIA HGX™ B300系统专为开放计算项目ORV3设计优化,单机架可容纳多达144个GPU。

Supermicro-OU液冷式NVIDIA HGX B300系统为超大规模部署提供无与伦比的GPU密度。该系统遵循OCP ORV3规范并采用先进的DLC-2技术,每个紧凑型8-GPU节点可适配21英寸机架,实现每机架最多18个节点、总计144个GPU的部署。 该系统采用盲插式歧管连接与模块化GPU/CPU托盘架构,在将机架占地面积、功耗及散热成本大幅降低的同时,可为每块B300 GPU提供高达1100W的TDP支持。其卓越的可维护性与极致性能密度,使其成为人工智能工厂的理想之选。

每GPU配备288 GB HBM3e内存

2-OU 液冷系统

适用于英伟达 HGX B300 8 图形处理器

单个标准化ORV3机架内最多可容纳144块NVIDIA BlackwellUltra

人工智能推理的Ultra 性能

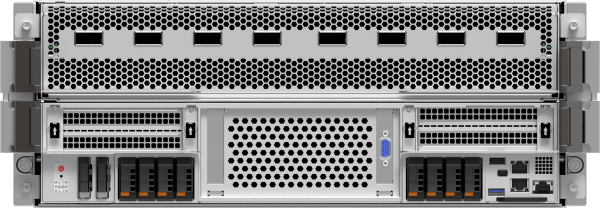

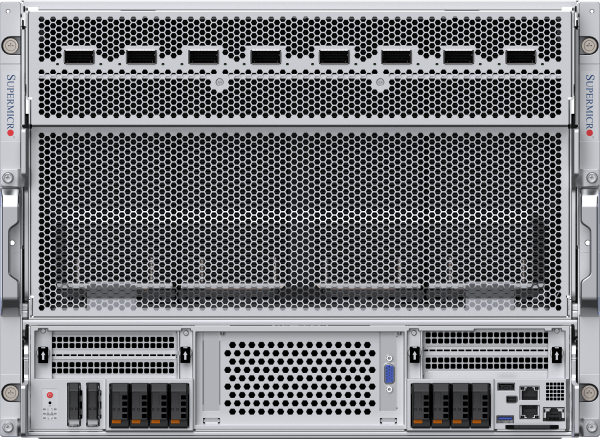

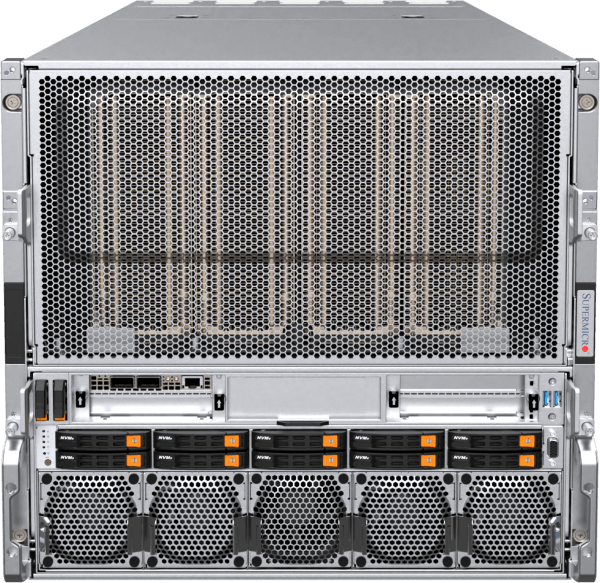

用于 NVIDIA HGX™ B300 的最先进的风冷和水冷架构

Supermicro HGX平台为全球众多大型AI集群提供动力,为当今变革性AI应用提供计算输出。该8U风冷系统现搭载NVIDIA BlackwellUltra,通过八块1100W HGX B300 GPU和总计2.3TB的HBM3e内存实现性能最大化。 八个前置OSFP端口集成ConnectX®-8SuperNIC网卡(800Gb/s速率),支持NVIDIA Quantum-X800 InfiniBand或Spectrum-X™以太网集群的即插即用部署。 4U液冷系统采用DLC-2技术,热捕获率达98%,实现数据中心40%的能耗节约。Supermicro 构建模块解决方案®(DCBBS)结合现场部署专长,提供涵盖液冷、网络拓扑布线、供电及热管理的完整解决方案,加速人工智能工厂上线进程。

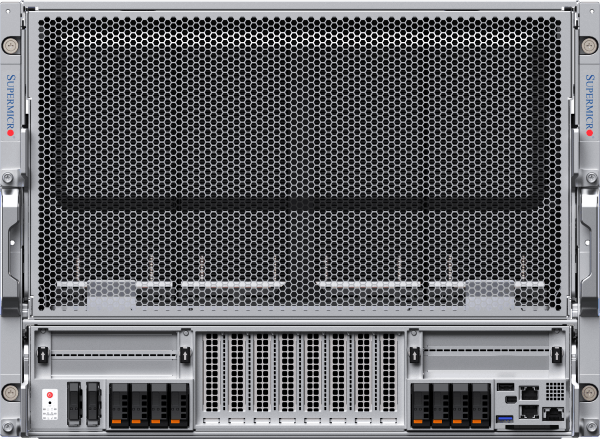

4U液冷系统或8U风冷系统

适用于英伟达 HGX B300 8 图形处理器

前置I/O液冷系统,集成NVIDIAConnectX-8800 Gb/s网络接口

用于英伟达Ultra (NVIDIA®)BlackwellUltra HGX B300 8-GPU 的前置 I/O 风冷系统,集成英伟达™(NVIDIA®)ConnectX-8 网络功能

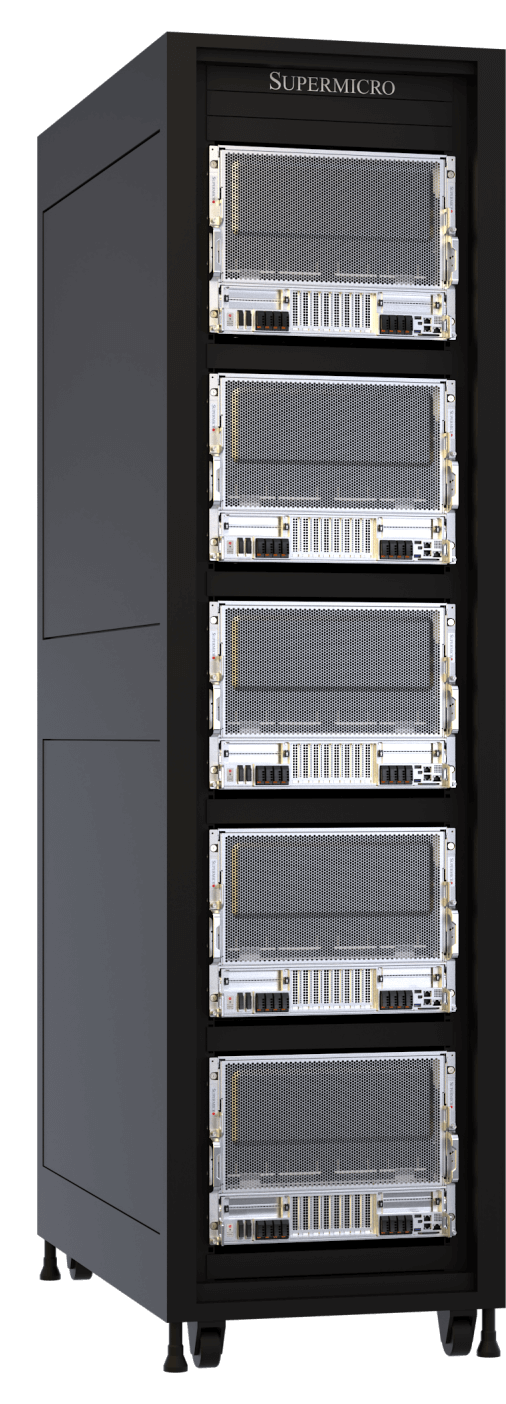

在机架中实现超大规模计算

针对 NVIDIA GB300 NVL72 的端对端水冷解决方案

Supermicro GB300 NVL72可应对从基础模型训练到大规模推理推断的AI计算需求。该系统将卓越的AI性能与Supermicro直接液体冷却技术相结合,实现最高计算密度与效率。基于NVIDIA BlackwellUltra,单机架集成72块NVIDIA B300 GPU,每块配备288GB HBM3e内存。 凭借1.8TB/s NVLink互连技术,GB300 NVL72单节点即可实现百亿亿次级超级计算机性能。升级的网络架构使计算架构性能翻倍,支持800Gb/s传输速率。Supermicro强大的制造能力和端到端服务,加速了液冷AI工厂的部署进程,显著缩短了GB300 NVL72集群的上市周期。

英伟达 GB300 NVL72 和 GB200 NVL72

用于 NVIDIA GB300/GB200 Grace™ Blackwell 超级芯片

一个英伟达™(NVIDIA®)NVLink 网域中包含 72 个英伟达™(NVIDIA®)BlackwellUltra GPU。现在具有Ultra 性能和可扩展性

一个英伟达™(NVIDIA®)NVLink 网域中包含 72 个英伟达™(NVIDIA®)Blackwell GPU。人工智能计算架构的顶点。

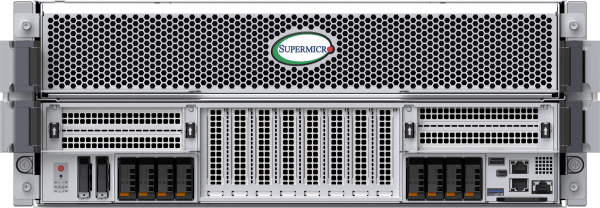

进化型风冷系统

针对英伟达 HGX B200 8GPU 重新设计和优化的最畅销风冷系统

全新风冷式NVIDIA HGX B200 8-GPU系统采用增强型散热架构,支持CPU、内存、存储及网络的高灵活配置,并优化了前/后侧维护便捷性。 每个机架可安装多达4台新型8U/10U风冷系统并实现完全集成,在保持与上一代相同密度的同时,提供高达15倍的推理性能和3倍的训练性能。Supermicro HGX B200系统均采用1:1的GPU与网卡配比,支持NVIDIABlueField®-3或NVIDIAConnectX®-7技术,可在高性能计算架构中实现扩展。

8U前置输入/输出或 10U后置输入/输出风冷系统

适用于 NVIDIA HGX B2008-GPU

前置 I/O 风冷系统,具有更高的系统内存配置灵活性和冷通道可维护性

后置 I/O 风冷设计,适用于大型语言模型训练和大量推理

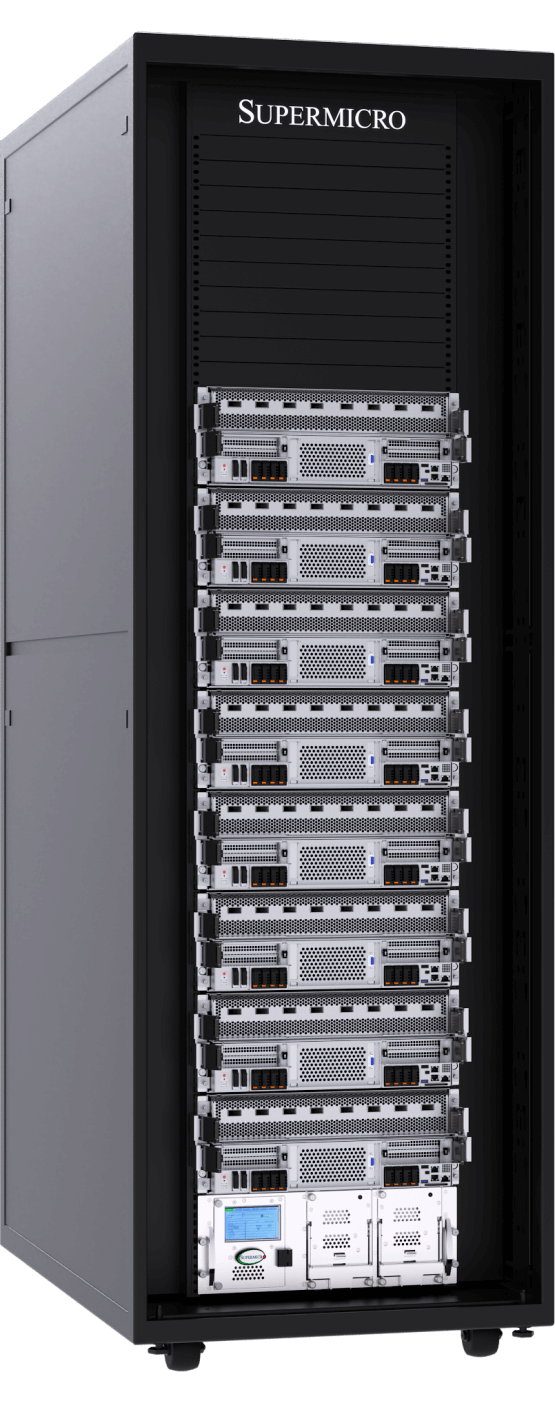

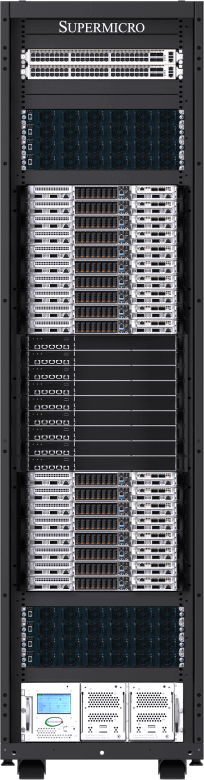

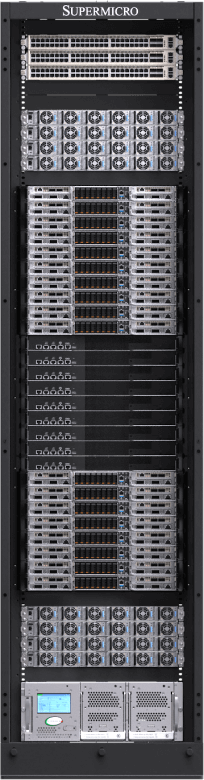

新一代水冷系统

单个机架中最多可安装 96 个 NVIDIA HGX™ B200 GPU,实现最高的可扩展性和效率

全新前置I/O液冷式4U NVIDIA HGX B2008-GPU系统Supermicro技术。直接液冷技术现可捕获高达92%的服务器组件发热量,包括CPU、GPU、PCIe交换机、DIMM、VRM和PSU,实现数据中心能耗最高40%的节省,噪音水平低至50分贝。 该新架构在前代产品基础上进一步提升了效率与可维护性,前代产品专为NVIDIA HGX H100/H2008-GPU系统设计。 该机架级设计提供42U、48U或52U三种配置,采用新型垂直冷却液分配管路(CDM),彻底解放了原本被水平管路占用的宝贵机架空间。这使得42U机架可容纳8套系统(共64块NVIDIA Blackwell GPU),52U机架则可容纳多达12套系统(共96块NVIDIA GPU)。

4U前置输入/输出或后置输入/输出水冷系统

适用于 NVIDIA HGX B2008-GPU

前置 I/O DLC-2 液冷系统可为数据中心节省高达 40% 的电力,噪音水平低至 50 分贝

后置 I/O 液冷系统,专为实现最高计算密度和性能而设计

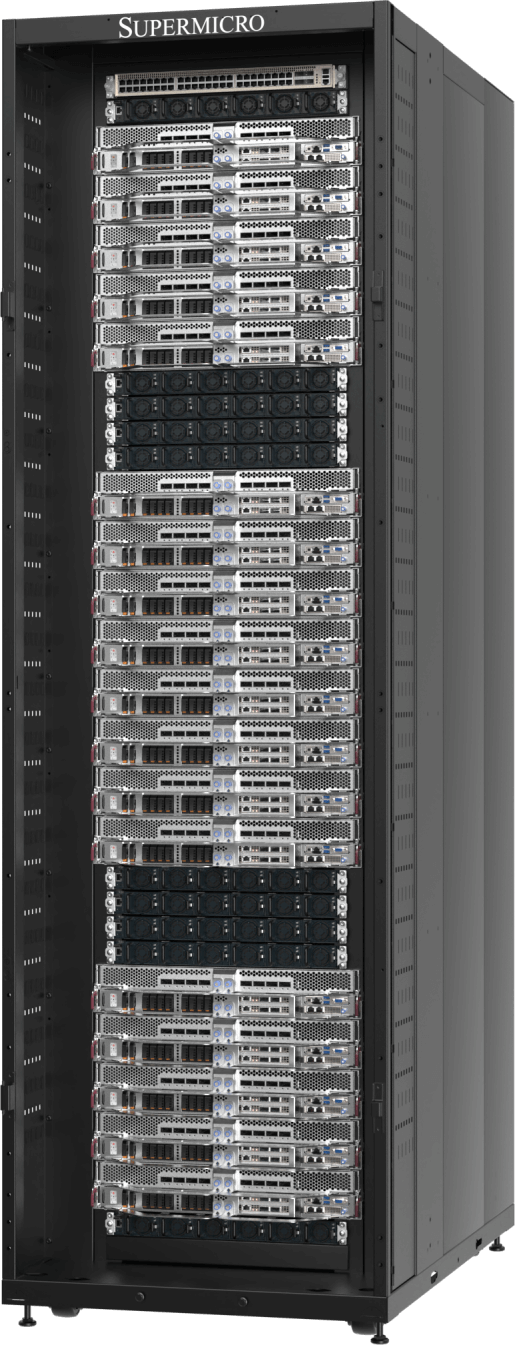

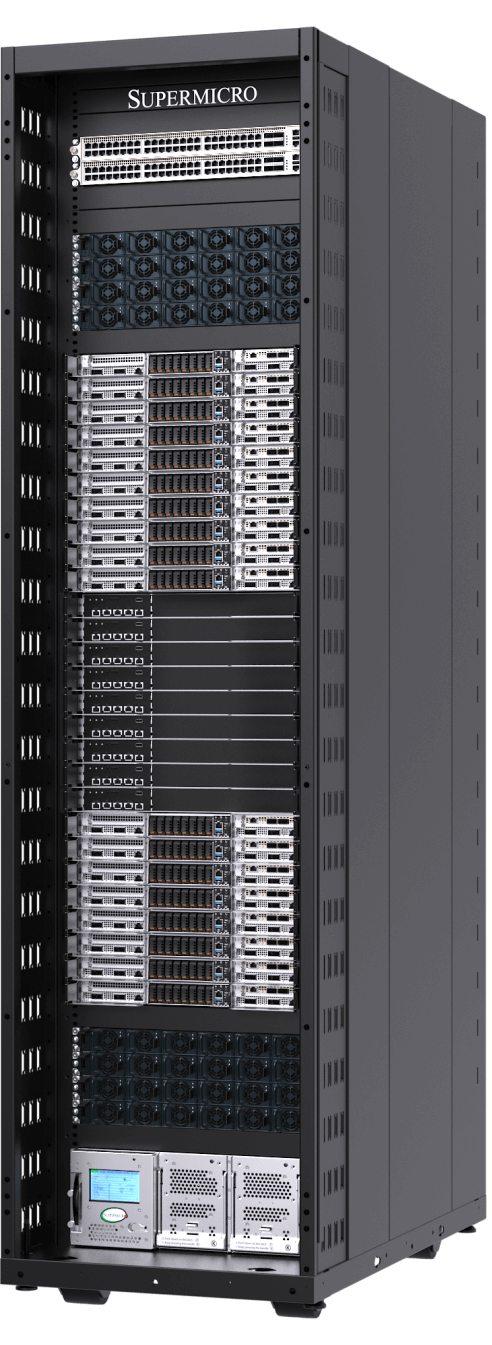

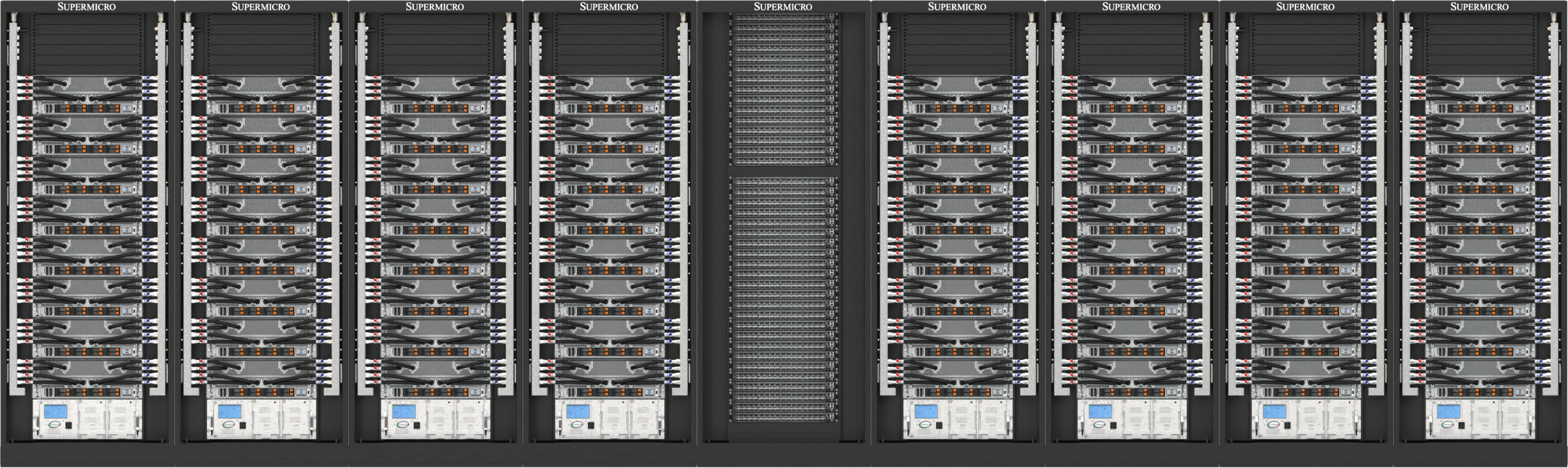

即插即用的可扩展装置可随时部署到 NVIDIA Blackwell 中

全新SuperCluster设计提供42U、48U或52U机架配置,适用于风冷或液冷数据中心。其在集中式机架中集成NVIDIA Quantum InfiniBand或NVIDIA Spectrum™网络技术,液冷SuperCluster可实现无阻塞的 在五个42U/48U机架中实现256-GPU可扩展单元,或在九个52U机架中扩展至768-GPU可扩展单元,满足最先进的人工智能数据中心部署需求。Supermicro 大规模部署提供行内CDU选项,以及无需设施供水的水冷转风冷机架解决方案。 风冷版SuperCluster延续上一代行业领先的成熟架构,通过九个48U机架实现256-GPU可扩展单元。

NVIDIA Blackwell 端到端数据中心构建模块解决方案和部署服务

Supermicro 全球制造规模的综合性一站式解决方案供应商,提供数据中心级解决方案设计、液冷技术、交换机、布线系统、全套数据中心管理软件、L11和L12解决方案验证、现场安装以及专业支持与服务。 凭借遍布圣何塞、欧洲及亚洲的生产基地Supermicro 在液冷或风冷机架系统领域Supermicro 无可匹敌的制造能力,确保及时交付、降低总体拥有成本(TCO)并保持品质稳定。

SupermicroVIDIA Blackwell解决方案通过集中式机架优化NVIDIA Quantum InfiniBand或NVIDIA Spectrum™网络架构,实现最佳基础设施扩展与GPU集群部署,可在五台机架中构建256 GPU的无阻塞可扩展单元,或在九台机架中扩展至768 GPU的可扩展单元。 该架构原生支持NVIDIA企业级软件,结合Supermicro在全球最大液冷数据中心部署领域的专业经验,为当今最具雄心的AI数据中心项目提供卓越能效与无与伦比的上线速度。

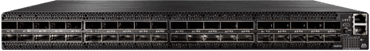

英伟达量子 InfiniBand 和频谱以太网

从mainstream 企业服务器到高性能超级计算机,NVIDIA Quantum InfiniBand 和 Spectrum™ 网络技术激活了最具扩展性、速度最快且最安全的端到端网络。

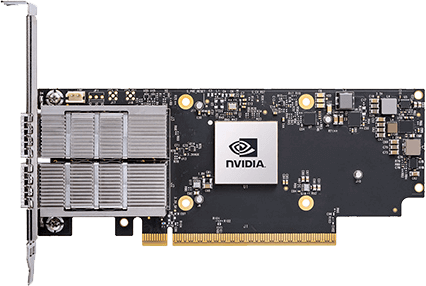

英伟达超级网卡

Supermicro 采用NVIDIA SuperNIC网络卡的前沿:包括适用于InfiniBand的NVIDIA ConnectX以及适用于以太网的NVIDIABlueField-3SuperNIC。SupermicroVIDIA HGX B200系统均配备1:1网络连接至每块GPU,支持NVIDIA GPUDirect RDMA(InfiniBand)或RoCE(以太网)技术,实现大规模并行AI计算。

英伟达™(NVIDIA®)人工智能企业软件

全面访问 NVIDIA 应用程序框架、API、SDK、工具包和优化器,并能够部署 AI 蓝图、NVIDIA NIM、RAG 和最新优化的 AI 基础模型。英伟达™(NVIDIA®)人工智能企业软件凭借企业级安全性、支持和稳定性,简化了生产级人工智能应用的开发和部署,确保从原型到生产的平稳过渡。