NVIDIA GB300 NVL72

Liquid Cooled Rack-Scale Solution with 72 NVIDIA B300 GPUs and 36 Grace CPUs

- GPU: 72 NVIDIA B300 GPUs via NVIDIA Grace Blackwell Superchips

- CPU: 36 NVIDIA Grace CPUs via NVIDIA Grace Blackwell Superchips

- Memory: Up to 21 TB HBM3e (GPU Memory), Up to 17 TB LPDDR5X (System Memory)

- Drives: up to 144 E1.S PCIe 5.0 drive bays

Universal GPU Systems

Modular Building Block Design, Future Proof Open-Standards Based Platform in 4U, 5U, 8U, or 10U for Large Scale AI training and HPC Applications

- GPU: NVIDIA HGX H100/H200/B200/B300, AMD Instinct MI350 Series/MI325X/MI300X/MI250 OAM Accelerator, Intel Data Center GPU Max Series

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 32 DIMMs, 9TB

- Drives: Up to 24 Hot-swap E1.S, U.2 or 2.5" NVMe/SATA drives

Liquid-Cooled Universal GPU Systems

Direct-to-chip liquid-cooled systems for high-density AI infrastructure at scale.

- GPU: NVIDIA HGX H100/H200/B200

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 32 DIMMs, 9TB

- Drives: Up to 24 Hot-swap U.2 or 2.5" NVMe/SATA drives

3U/4U/5U GPU Lines with PCIe 5.0

Maximum Acceleration and Flexibility for AI, Deep Learning and HPC Applications

- GPU: Up to 10 NVIDIA H100 PCIe GPUs, or up to 10 double-width PCIe GPUs

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 32 DIMMs, 9TB or 12TB

- Drives: Up to 24 Hot-swap 2.5" SATA/SAS/NVMe

NVIDIA MGX™ Systems

Modular Building Block Platform Supporting Today's and Future GPUs, CPUs, and DPUs

- GPU: Up to 4 NVIDIA PCIe GPUs including NVIDIA RTX PRO™ 6000 Blackwell Server Edition, H200 NVL, H100 NVL, and L40S

- CPU: NVIDIA GH200 Grace Hopper™ Superchip, Grace™ CPU Superchip, or Intel® Xeon®

- Memory: Up to 960GB ingegrated LPDDR5X memory (Grace Hopper or Grace CPU Superchip) or 16 DIMMs, up to 4TB DRAM (Intel)

- Drives: Up to 8 E1.S + 4 M.2 drives

AMD APU Systems

Multi-processor system combining CPU and GPU, Designed for the Convergence of AI and HPC

- GPU: 4 AMD Instinct MI300A Accelerated Processing Unit (APU)

- CPU: AMD Instinct™ MI300A Accelerated Processing Unit (APU)

- Memory: Up to 512GB integrated HBM3 memory (4x 128GB)

- Drives: Up to 8 2.5" NVMe or Optional 24 2.5" SATA/SAS via storage add-on card + 2 M.2 drives

4U GPU Lines with PCIe 4.0

Flexible Design for AI and Graphically Intensive Workloads, Supporting Up to 10 GPUs

- GPU: NVIDIA HGX A100 8-GPU with NVLink, or up to 10 double-width PCIe GPUs

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 32 DIMMs, 8TB DRAM or 12TB DRAM + PMem

- Drives: Up to 24 Hot-swap 2.5" SATA/SAS/NVMe

2U 2-Node Multi-GPU with PCIe 4.0

Dense and Resource-saving Multi-GPU Architecture for Cloud-Scale Data Center Applications

- GPU: Up to 3 double-width PCIe GPUs per node

- CPU: Intel® Xeon® or AMD EPYC™

- Memory: Up to 8 DIMMs, 2TB per node

- Drives: Up to 2 front hot-swap 2.5” U.2 per node

GPU Workstation

Flexible Solution for AI/Deep Learning Practitioners and High-end Graphics Professionals

- GPU: Up to 4 double-width PCIe GPUs

- CPU: Intel® Xeon®

- Memory: Up to 16 DIMMs, 6TB

- Drives: Up to 8 hot-swap 2.5” SATA/NVMe

Supermicro レビュー:NVIDIA HGX B200 との一週間

Supermicro、ハードウェア評価において非常に異なるアプローチを採用しております。共有ラボ環境での短時間の定型デモではなく、ジャンプスタートでは、条件を満たしたお客様に、実際の生産サーバーのカタログから、無料かつ時間制限付きのベアメタルアクセスを提供いたします。

インテル® TDX、NVIDIA Confidential Computing、およびNVIDIA HGX™ B200 GPUを搭載したSupermicro によるAIワークロードの保護:大規模な機密AIの基盤

本ホワイトペーパーでは、インテルのトラストドメイン拡張(TDX)と、NVIDIAの機密コンピューティングを、SupermicroB200ベースシステムと組み合わせることで、次世代AIインフラストラクチャ向けに強力で安全かつスケーラブルなプラットフォームをいかに実現するかについてご説明いたします。

さくらインターネット、AIサービスを加速するクラウドサービス「Koukaryoku

サクラインターネット株式会社は、NVIDIA HGX™ 8-GPU AIスーパーコンピューティングプラットフォームSupermicroSYS-821GE-TNRシステムを活用し、新たなサービスを提供いたします。これにより、生成AIアプリケーションの高速化を実現いたします。

Supermicro NVIDIA H200 GPU搭載 空冷式 AIサーバー

本日は大規模AIサーバーの比較を継続し、Supermicro についてご紹介します。Supermicro技術力を議論される際、このシステムは市場において空冷式NVIDIAサーバーとして他とは異なる存在です。

Supermicro 3 AISupermicro 、AI要件に対応するスケーラブルな性能を提供いたします。

あらゆる規模とワークロードのデータセンターに最適化された幅広いソリューション 新サービスと顧客満足度の向上を実現

Supermicro 3システムが、エンタープライズAIインフラを推進します

IntelXeon 6プロセッサーを使用した高帯域幅AIシステムにより、エンタープライズ規模での効率的なLLMとGenAIのトレーニングと推論を実現

ラミニはLLMチューニングサービス向けにSupermicro を選択いたしました

AMD Instinct™MI300Xアクセラレータを搭載したSupermicro を活用することで、Laminiは高速なLLMチューニングを提供することが可能となりました。

Supermicro システムは、ANSYS® LS-DYNA®において4倍の性能を実現します。

Supermicro スーパーチップシステムは、同等の電力消費量で4倍の性能を発揮します。

アプライド・デジタル、Supermicro GPUサーバーで大規模なAIクラウドを構築

アプライド・デジタルは、Supermicro サーバーを活用し、AIトレーニングおよびHPCシミュレーション向けに、スケーラブルなAIおよびHPCインフラストラクチャの最新技術をご提供いたします。

Supermicro AMD EPYC 柔軟性を提供します(AS-4125GS-TNRT)

Supermicro 長年、GPUサーバーを多様な形状とサイズで提供Supermicro 本レビューで全てを網羅するには時間が足りません。今回は比較的新しい4U空冷GPUサーバーを検証いたします。本サーバーAMD EPYC CPUを2基搭載可能で、PCIe Gen5をサポートし、8基のダブル幅または12基のシングル幅のアドインGPUカードから選択いただけます。

Supermicro エヌビディアSupermicro 、自動車および航空宇宙産業向けのCFDシミュレーションを加速するソリューションを共同で開発いたしました。

NVIDIAのデータセンター向けGPUを搭載したSupermicro 、CFDシミュレーションにおいて大幅な高速化を実現し、製造業の市場投入までの時間を短縮します。

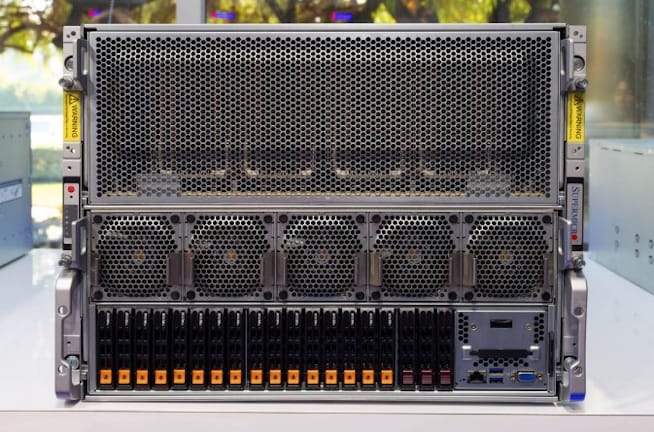

液体冷却式Supermicro 8x NVIDIA H100 AIサーバーのご紹介

本日は、液体冷却方式Supermicro をご紹介いたします。SupermicroNVIDIA H100を搭載したシステムですが、冷却コストと消費電力の削減を目的とした液体冷却方式が特徴となっております。写真もご用意できましたので、本記事でご紹介することにいたしました。

高性能サーバー・アーキテクチャにおけるPCIe GPUへのアクセス・オプション

Supermicro の設定オプションを理解することで、ワークロードに対して最高のパフォーマンスを実現します

ペトロブラスはコスト削減と探査精度の向上のため、アトスが統合したSupermicro いたしました。

Supermicro 、2022年11月発表のTOP500ランキングにおいて、ペトロブラス社を第33位に導きました。

Supermicro プロフェットストアは、マルチテナントLLMトレーニングにおけるGPU効率を最大化します

AIと機械学習のダイナミックな世界では、マルチテナント環境におけるGPUリソースの効率的な管理が、特に大規模言語モデル(LLM)のトレーニングにおいて最も重要です。

Supermicro 、SEEWEB社向けのGPU提供を拡充し、要求の厳しいお客様に対し、AIおよびHPCワークロードにおいてより高速な結果を実現します。

シーウェブは、HPCおよびAIワークロードにおけるお客様の需要に応えるため、Supermicro を採用いたしました。

3000WのAMD Epyc サーバーのティアダウン、Level1TechsのWendell氏撮影

AIおよび機械学習向けに最適化されたサーバーを検討しております。Supermicro 、2114GT-DNR(2U2N)という高密度最適化サーバーに可能な限り多くの機能を詰め込むため、多大な努力Supermicro 。これは非常に優れた設計で、この2Uシャーシ内に2つのシステムが搭載されております。 2基の冗長電源ユニットは各2,600Wの出力であり、これほどの電力が必要な理由が後ほど明らかになります。AMD Instinct GPUとデュアルEpyc を搭載しています。Supermicro がこのサーバー設計にSupermicro 技術力のレベルをご覧ください。

NECは、Supermicro社の先進的なGPUシステムを活用し、AI研究を推進しております。

Supermicro :高密度AIトレーニング/ディープラーニングサーバー

当社の最新のデータセンター・システムは、高速GPU-GPUインターコネクトと第3世代インテル® Xeon® Scalableプロセッサーを備えた先進的なNVIDIA Ampere GPUを最高密度で搭載しています。このTECHTalkでは、4Uラックハイトパッケージで比類のないAIパフォーマンスを実現する方法を紹介します。

ハイブリッド2U2N GPUワークステーション・サーバープラットフォームSupermicro SYS-210GP-DNR実機体験レポート

本日は最新のシリーズを締めくくるにあたり、Supermicro をご紹介します。これは2Uサイズの2ノード・6GPUシステムで、パトリックが先日Supermicro にて実際に操作する機会を得たものです。

Supermicro NVIDIA Redstone 2U サーバー

本日は、パトリックが先日Supermicro にて実際に操作したSupermicro についてご紹介いたします。

GPUシステム設計の飛躍的進化を明らかにする -Supermicro TECHTalk with IDC

ジョシュ・グロスマン氏(Supermicro プリンシパルプロダクトマネージャー)Supermicro ピーター・ラッテン氏(IDC インフラストラクチャシステムズ リサーチディレクター)によるご講演

ミッションクリティカルなサーバーソリューション

仮想化されたNVIDIA A100 GPUによるAI開発と提供の最大化

NVIDIA HGX A100を搭載Supermicro 、NVIDIA Virtual Compute Server(vCS)およびNVIDIA A100 GPUをサポートする柔軟なソリューション群を提供し、AI開発と提供を可能にします。これにより、小規模から大規模なAIモデルの実行が実現されます。

Supermicro :2U 2ノードサーバー

Supermicro画期的なマルチノードGPU/CPUプラットフォームは、市場に存在する既存製品とは一線を画すものです。当社の先進的なBuilding Block Solutions®設計と省資源アーキテクチャにより、このシステムは最先端のCPUおよびGPUエンジンと高度な高密度ストレージを省スペース設計で統合し、比類のないエネルギー効率と柔軟性を実現しております。

SuperMinute: HGX A100 8GPU搭載4Uシステム

最も要求の厳しいAIワークロード向けに、Supermicro NVIDIA A100™ Tensor Core GPUを搭載した最高性能かつ市場投入最速のサーバーをSupermicro 。最新のNVIDIA® NVLink™およびNVIDIA NVSwitch™テクノロジーにより、これらのサーバーは単一の4Uシステムで最大5ペタフロップスのAI性能を実現いたします。

SuperMinute: HGX A100 4GPU搭載2Uシステム

新しいAS -2124GQ-NARTサーバは、NVIDIA A100 Tensor Core GPUとHGX A100 4-GPUベースボードのパワーを特徴としています。システムは、高速CPU-GPU接続および高速ネットワーク拡張カード用のPCI-E Gen 4をサポートしています。